法國AI新創Mistral AI周二(7/16)發表了兩個新模型Codestral Mamba 7B與Mathstral 7B,前者為程式碼生成模型,後者則是數學推論模型,皆採用Apache 2.0開源授權,並透過Hugging Face存取。

根據Mistral AI的說明,有別於Transformer模型強調自注意機制與支援複雜時空的運算能力,Codestral Mamba採用新型架構,支援線性時間推論,因此得以更有效地處理長序列,理論上可支援無限長的序列,可與用戶進行廣泛互動且快速獲得回應,對於產生程式碼特別有效率,Mistral AI並以高級的程式碼及推論能力來訓練該模型,使其可比美最先進的Transformer模型。

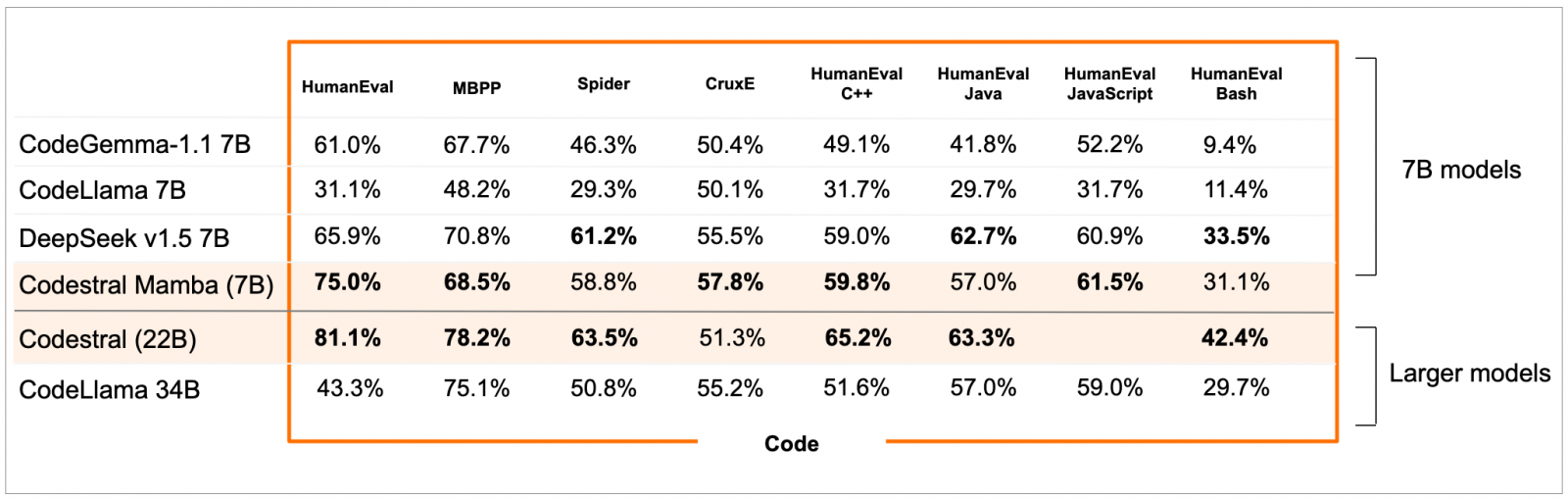

Mistral AI比較了同屬7B規格的CodeGemma-1.1、CodeLlama、DeepSeek v1.5,發現Codestral Mamba在多數的基準測試上皆勝出,對於更大的Codestral 22B及CodeLlama 34B等模型,Codestral Mamba 7B也與其不相上下。

圖片來源/Mistral AI

此外,Mistral AI也已測試多達256K Token的Codestral Mamba脈絡檢索能力,預期它可成為出色的本地端程式碼助手。

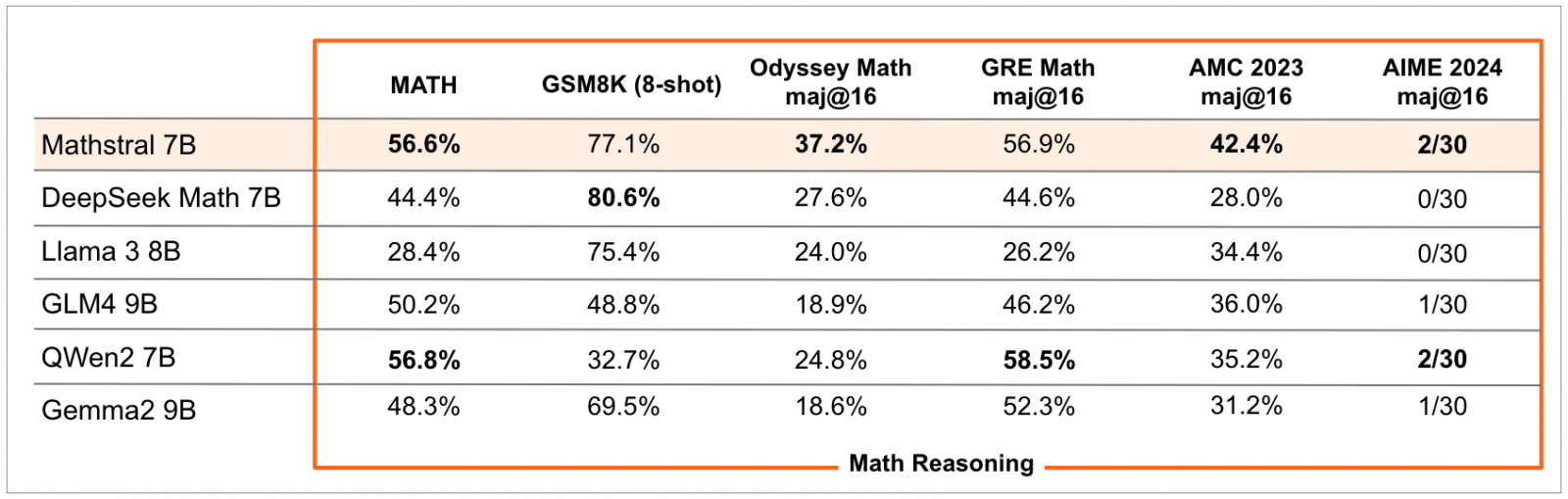

至於Mathstral 7B則是個奠基在Mistral 7B的數學推論模型,專攻科學、技術、工程及數學(STEM)相關領域的主題,將它與DeepSeek Math 7B、Llama 3 8B、GLM4 9B、QWen2 7B、Gemma2 9B進行比較,Mathstral 7B不管是在MATH、GSM8K、Odyssey Math、GRE Math、AMC 2023或AIME 2024等基準測試上都有出色的表現,而且若能擁有更多的運算資源與時間,就會有更好的推論表現。

圖片來源/Mistral AI

Mathstral 7B是個預訓練模型,已可直接用來推論,亦可根據需求來微調它。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09