Nvidia發布了一套名為Nemotron-CC的大型英文資料集,總計包含6.3兆個Token,其中1.9兆包含合成資料。Nemotron-CC的釋出使得學術界與企業界有能力再進一步推進大型語言模型的訓練成果,提升其準確性。

大型語言模型被廣泛用於自然語言處理、機器翻譯、文本生成等領域,而強大的大型語言模型仰賴大量且高品質的訓練資料。現有的公開資料集往往在資料規模或品質上有所侷限,難以滿足當前模型訓練需求。

以Meta發布的Llama系列模型為例,其訓練資料規模高達15兆個Token,如此龐大的資料需求對現有公開資料集是一大挑戰。而Nemotron-CC的出現,正是為了解決這個模型訓練資料瓶頸,其6.3兆的Token規模和經過驗證的資料品質,使其成為訓練大型語言模型的理想素材。

Nemotron-CC資料集基於Common Crawl的網頁資料,再經過一系列嚴謹的資料處理流程,擷取出高品質子集Nemotron-CC-HQ。與目前領先的公開英文資料集DCLM相比,Nemotron-CC-HQ在MMLU(Massive Multitask Language Understanding)基準測試中,提升了MMLU分數5.6。

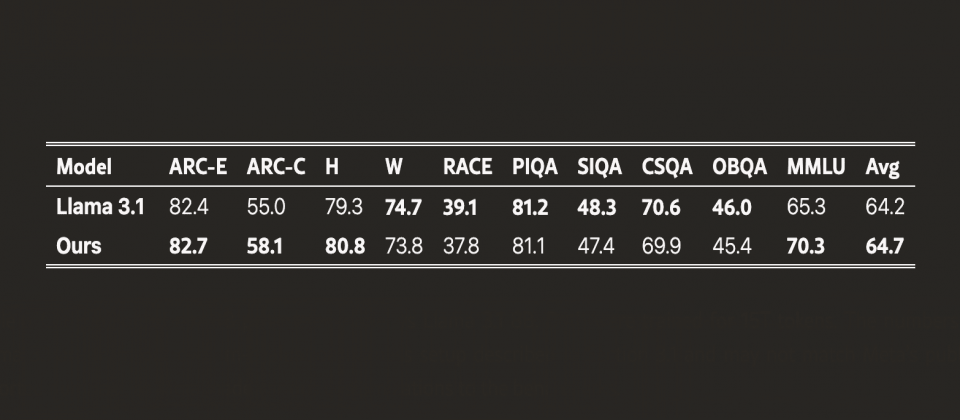

DCLM(Deep Common Crawl Language Model)是基於Common Crawl英文資料建構的資料集,曾被視為同類中表現最佳的公開資料集,但是模型使用Nemotron-CC-HQ高品質子集訓練,準確性卻比DCLM訓練出來的模型更高。而進一步測試顯示,基於Nemotron-CC訓練的80億參數模型,在MMLU基準測試中分數提升5分,在ARC-Challenge基準測試中提升3.1分,並在十項不同任務的平均表現中提高0.5分,超越了基於Llama 3訓練資料集所開發的Llama 3.1 8B模型。

Nvidia官方提到,Nemotron-CC開發過程採用了模型分類器、合成資料重述(Rephrasing)等技術,最大程度地確保資料品質和多樣性。同時,針對高品質資料則減少了傳統非學習啟發式過濾器來處理高品質的資料,進一步提升高品質Token數量並避免損害精確度。

Nemotron-CC資料集目前已在Common Crawl網站開放下載,其完整的資料處理流程與合成資料產生方法,也即將在Nvidia/NeMo-Curator GitHub專案中公開,以促進人工智慧社群更深入地理解和運用Nemotron-CC資料集,共同推進大型語言模型的發展。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06