對OpenAI而言,影片生成服務Sora的戰略意義在於,AI生成影片是通用人工智慧藍圖的重要一環,因為影片是AI學習的重要環境,可以讓AI從中學到人類在真實世界中的行為。(圖片來源/OpenAI)

在去年底的十二天發表會期間,OpenAI以新一代推理模型o1正式上線啟用揭開序幕。執行長Sam Altman表示,OpenAI的模型技術,開始從通用型的LLM,轉向具有複雜推理能力的新一代模型系列。

第一天:新一代推理模型o1正式上線

正式版的o1比先前的預覽版本更強大,開始支援多模態的輸入,不只文字,還可以輸入圖片。

o1也能支援結構化輸出,可以指定輸出JSON格式的內容,可以保證產生有效的JSON,但不一定會依據使用者透過推斷 API 呼叫提供的JSON 結構描述定義來生成。

OpenAI採取了一套人工評估作法,發現o1正式版比o1預覽版的錯誤率,減少了34%,平均回答速度也快了50%。預覽版回應太慢的問題也獲得不少改善,現在輸入第一句話後,只需要10秒就可以獲得回應,甚至會依據問題難易度,簡單問題的回應快,而複雜問題回應速度才會較慢。

在推理能力上,OpenAI特別在意o1模型對於輔助開發的成效,以全球程式競賽平臺Codeforces的得分來說,GPT-4o可以得到11%(解出11%的問題),o1預覽版62%,但是正式版o1達到89%的高分,可以解答近9成的程式問題。

不只是推出了新一代推理模型,OpenAI還發表了要價高達每月200美元的ChatGPT Pro訂閱模式,在這個模式下可以取得o1 Pro Mode,用更多算力來提高難題的回答準確度。

也就是說,ChatGPT可以按算力提供分級服務,意味著,這款o1模型是一款可以增加算力,來提高準確度的模型,因此,未來是可以購買更多算力,來提高o1的推理能力。

目前,微軟Azure AI也開始提供o1推理模型,目前在美國和瑞典各有一個雲端區域提供這項模型。

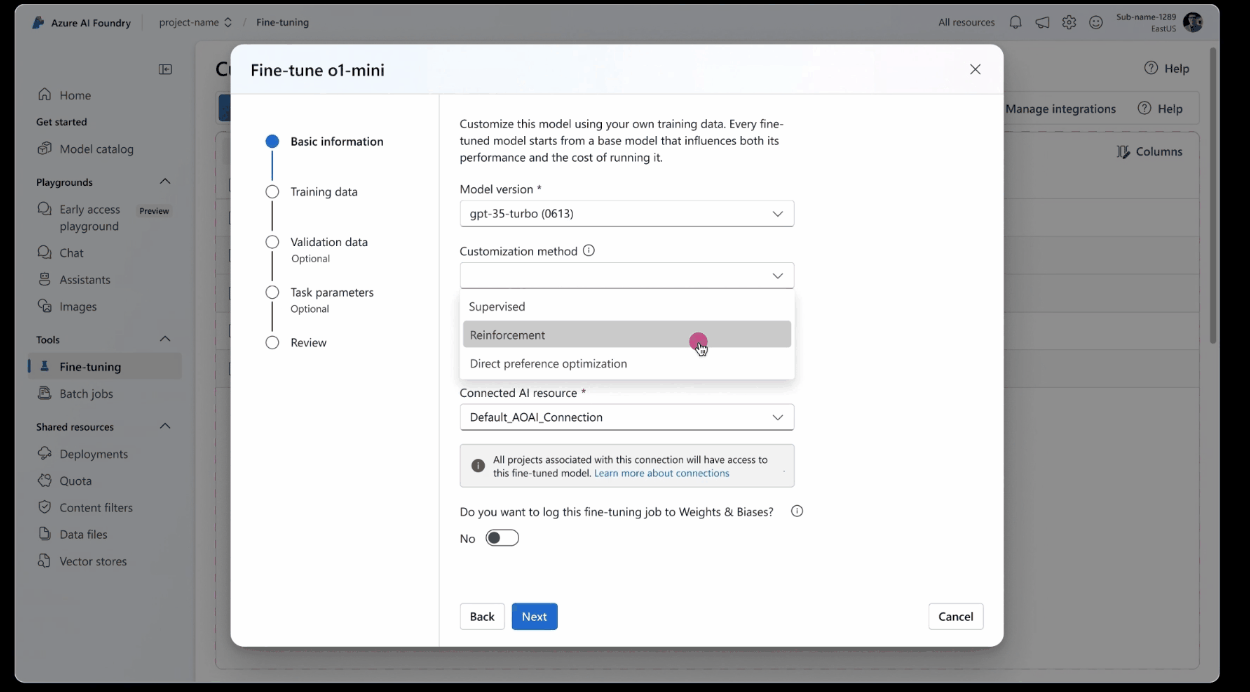

第二天:全新的模型客製化作法RFT

正式推出o1模型的發表會之後,OpenAI研究副總裁Mark Chen緊接著登場,公布了新的模型客製新功能,增強式微調(Reinforcement Fine-tuning,RFT),可以讓企業用自己的資料來微調o1模型,但不只是過去的標準微調作法,而是新的增強式微調作法。Mark強調,RFT作法可以讓高中生的能力,變成博士等級的模型。微軟Azure AI已經開始提供o1模型,同時也開始提供新的增強式微調模式。

Mark Chen強調,RFT適合用於特定領域的任務,透過增強式學習模式,來建立專家級的模型,像是法務,金融,工程,保險,都可以適用。

增強學習微調的原理是,提供一個問題讓模型回答,依據不同的思考路線產生一系列的多個答案,針對每一個答案的正確程度,來提供獎勵分數,針對得到正確答案的思考線路進行增強,而同時抑制得到錯誤答案的思考線路。不過,使用者不用考慮背後的運作過程,只需要上傳訓練資料和驗證資料集即可。「這讓模型用一種全新的方式,也是更有效的方式,來學會特定領域的推理方式。」Mark解釋,增強式學習不是優化模型的輸出,而是讓模型學會「推理」方法,只要十幾個訓練案例,就可以有效果。這也是OpenAI用來訓練GPT4o和o1模型的訓練方式,變成一項平臺功能。

進行RFT微調時,企業需要先上傳JSON格式的訓練資料集,每一行是一筆資料,也可以加入提示工程的指令,產生推論結果後,還要上傳一份驗證用的資料。透過一個評分器機制,將推論產生的答案和正確答案比較,模型會回傳0到1的分數,1代表完全正確,0則代表完全錯誤。

OpenAI將會提供不同類型的評分器,作為增強式微調使用,也開放企業可以自己用Python來定義自己的評分器,上傳使用。目前執行一次RFT的時間,可能從數小時到數天不等。

微軟Azure AI服務在12月18日也新增了這項功能,先提供給9月釋出的o1-mini可以用RFT,也先在美國North Central US和瑞典 Sweden Central這兩個區域提供,支援UI介面操作。

微軟Azure AI服務在去年12月18日開始提供新的增強式微調RFT功能,先開放對9月釋出的o1-mini模型使用RFT,目前先在美國North Central US和瑞典 Sweden Central這兩個區域提供。(圖片來源/微軟)

目前已有搶先試用RFT的大型企業,例如Thomson Reuter法律顧問公司用RFT來微調o1-mini模型,用於自家GAI 法務助理Co-Counsel。Thomson Reuter公司在2024年2月發表了用GPT-4打造的法務助理Co-Counsel,更在2024年11月時,宣布開始測試客製化版的o1-mini。這個客製化就是用了RFT來客製化法律事務專門的推理能力。

Thomson Reuter這款AI助理混用了三家公司的LLM模型,處理不同任務。用Google的Gemini處理超長上下文的大型法律文件整合。

用Anthropic的Claude處理稅務和合規等需要高度流程客製化的作業,最後則是用客製化版的o1-mini來處理法院訴訟案件摘要中,需要專業人員才能辨識的細微用語差異。

根據他們目前的POC測試結果,RFT微調後的o1-mini模型,可以辨識出律師與當事人往來的保密信件中的用語差異,這是連GPT-4都無法辨識的細節,甚至,過去得靠專門律師才能判斷的用詞,這也加速了他們文件審查,法律研究,訴訟申請等作業。

OpenAI線上發表時揭露了一項遺傳基因研究的RFT應用案例,用了1,100個案例微調o1-mini的正確率達到31%,比單純用o1-mini的17%高了不少,甚至比沒有微調的o1模型的25%還要高。這也反映出微調的效果。微軟官網上也介紹了另一個適合RFT的場景是物理學量子光學數學方程式的生成。

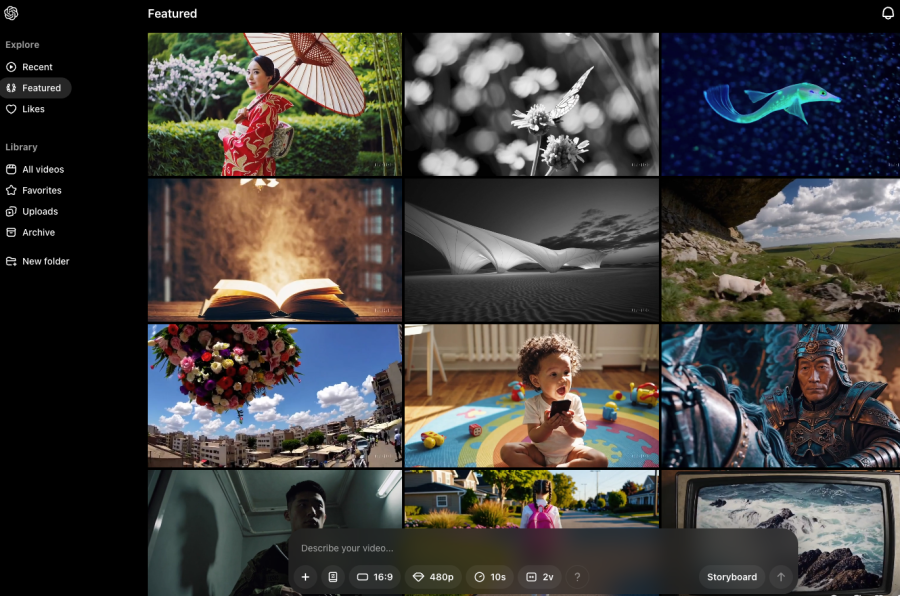

第三天,Sora正式上線,開放付費用戶使用

Sam Altman親自主持第三場發表,也就是影片生成服務Sora的上線,開放所有付費用戶使用。他指出,AI影片工具是新型態的共同創造模式,他們希望AI可以理解影片,「生成影片將會深深地改變人們使用電腦的方式。」

不只如此,Sora服務對OpenAI有更大的戰略意義,Sam Altman強調,AI生成影片是通用人工智慧藍圖的重要一環。他表示「因為影片是AI學習的重要環境,可以讓AI從中學到人類在真實世界中的行為。」

目前正式推出的影片生成模型不是去年2月公布的預覽版,而是新的進階版Sora Turbo,可以提供文字生成影片,圖片生成影片,影片生成影片等,可選擇生成480P到1080P不等影片畫質,5秒到20秒長度的影片。

影片生成服務Sora服務採用了新的進階版Sora Turbo模型,可提供文字生成影片、圖片生成影片、影片生成影片等,也能選擇生成480P到1080P不等影片畫質,或是5到20秒長度的影片。(圖片來源/OpenAI)

另外在Sora服務中也推出故事板功能,可以讓使用者像是導演般的設計和安排一整個影片的生成,像是描述角色,也可以下提示指令來建立一系列的行為。生成的影片可以用來重新編輯和混合,或是跟另一部影片後製成一個新影片。

特別的是,因為這些是AI生成的影片,使用者可以透過提示,來改變影片中的角色。在發表會的展示中,直接把影片中在沙漠中移動的猛瑪象,要Sora模型替換成了機器人在沙漠中的移動,場景和移動方式都一樣,但是影片主角變成了類似大象的四腳機器人。目前Plus版訂閱用戶每個月可以生成50次影片,而Pro版訂閱者才能夠更多使用量,另外,Sora服務也搭配了避免生成影片濫用的控管機制。

Sora影片生成服務有一項特別的分享機制,打開Soar服務主頁,提供了一項探索功能,提供了精選推薦影片和最新生成影片兩類,展示了全球使用者使用Sora生成且可公開的影片,最大特色是,不只是可以觀看這些影片,還能夠編輯混合(remix)這些影片,甚至有不少精選影片允許編輯故事板,讓其他人都可以參考這個影片。這等於公開了這一隻影片的製作過程,讓其他人可以快速複製修改,做出自己的版本。

雖然,目前Sora服務最大的挑戰是,同一個角色不容易延續到多個影片,來產生更長,故事性延續性更多的長影片。但是,透過開放影片故事板的功能,可以產生很多隻風格,角色相似的短影片來拼貼成更長的敘事。

另外,這樣的影片製作共享能力,也大幅降低了新影片生成的門檻,參考專業導演、影片創作者釋出的影片故事板,也能快速做出不錯的影片。像是企業可以建立一套公版影片,再讓行銷團隊修改,客製,用於不同行銷活動中,這都能加速生成影片在企業的實用性。

對OpenAI來說,這些生成影片和相關的提示指令、故事板描述,甚至使用者自己上傳用來生成影片的素材,都可以成為他們再利用於訓練下一代模型的資料,越多人使用,生成式AI模型就有越多影片素材可用,這正是OpenAI打造通用人工智慧的關鍵之一。

第四到六天:ChatGPT大升級,全新人機協作,深度整合蘋果生態

接著連續三場,從第四天到第六天,主要聚焦在ChatGPT產品的大升級,將原本以對話形式為主的功能,發展成多型態的人機協作平臺,也跨入更大的蘋果產品生態圈。

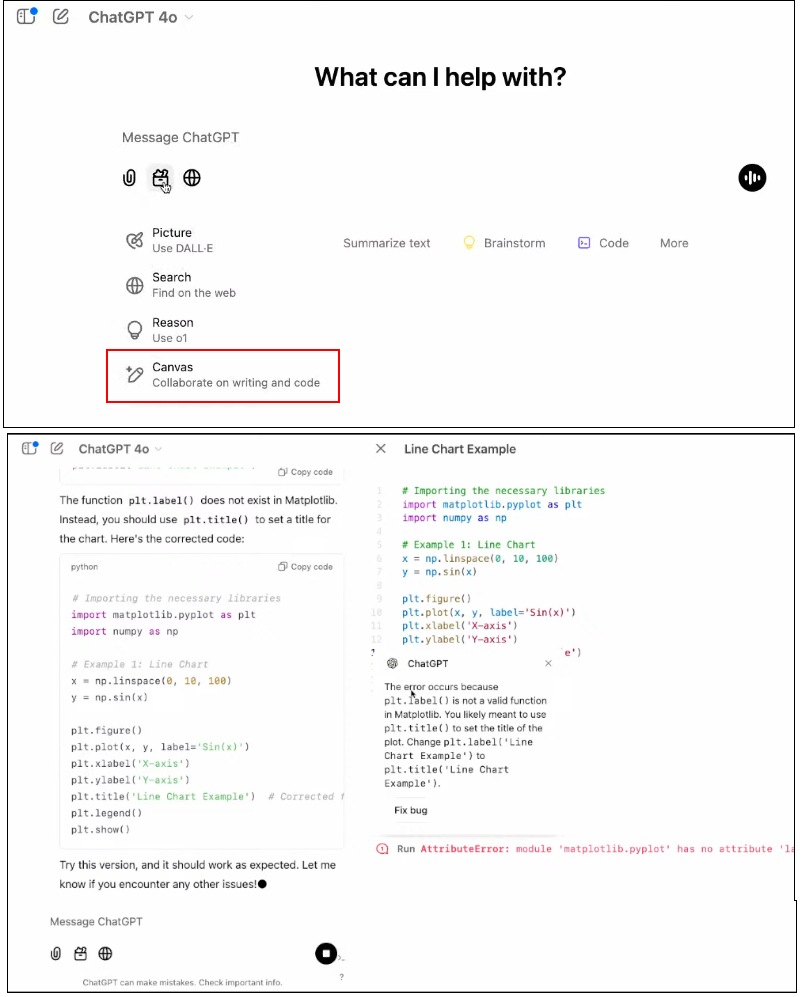

第四天正式推出了ChatGPT的人機協作新工具Canvas,讓使用者與ChatGPT對話,來生成和編輯一篇文章,Canvas讓ChatGPT變成了以文件寫作為主的創作工具,可以一邊和AI討論和修改,並行畫面中的文件內容,提供了新的人機協同寫作方式。

不只用於文件寫作,甚至可以用來撰寫Python程式碼,Canvas提供了Python直譯器,可以直接在線上執行這段Python程式碼,甚至呼叫常用的函式庫,繪製圖表等。ChatGPT也能補齊程式碼的註解,甚至是進行除錯,提供建議修改的正確程式碼段落,只要同意就可以套用。

在GPT商店中,有許多客製化GPTs,使用特定提示和設計,打造的GPT機器人,可以與其他人分享。現在可以將Canvas模式,加入到客製化GPTs中,讓使用這款客製GPTs的其他人,不用刻意打開Canvas,也能使用。換句話說,客製GPT可以把人機協作寫作工具Canvas加入到GPTs的生成結果,直接生成一份可以人機共同編輯的文件。

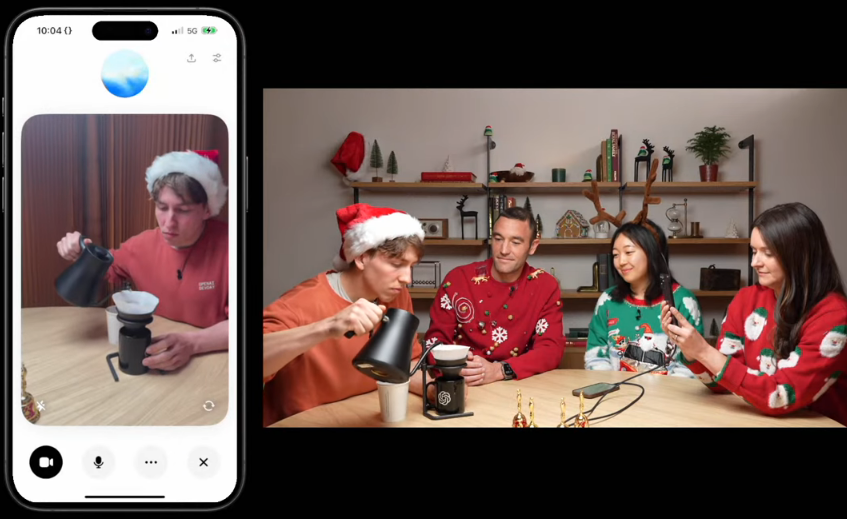

與蘋果生態圈的整合上,ChatGPT提供了三種整合方式。第一種是與Siri整合。使用者向Siri提出要求後,Siri會自動建議是否更適合使用ChatGPT,詢問使用者同意後就會自動換手來處理。第二項整合ChatGPT和蘋果系統內建寫作工具,可以套用到全系統各處的寫作功能,對文件內容進行修改、摘要或畫重點等。第三項整合是相機控制,ChatGPT現在可以控制iPhone 16的相機功能,將畫面和聲音傳到ChatGPT上,讓ChatGPT了解使用者的世界,使用者可以自己控制要不要讓ChatGPT取得鏡頭控制權。

蘋果則在公布與ChatGPT深度整合計畫的同時宣布,蘋果智慧服務將開始支援更多地區和語言,一方面在澳洲、加拿大、愛爾蘭、紐西蘭、南非和英國等國提供在地化英語支持,另一方面也在語言支援上,將會支援中文、印度英語、新加坡英語、法語、德語、義大利語、日語、韓語、葡萄牙語、西班牙語和越南語等,預計2025年4月開始透過軟體更新陸續升級這些支援。

ChatGPT另外一項重要的大升級,則是進階語音對話功能,開始支援影音對話,這是第六天發表會的重點。這項具備影音能力的進階語音對話功能,使用了4o模型,可以支援50種語言,以更自然的方式與人對話,現在更可以支援即時影音,也能將使用者的螢幕分享給ChatGPT來剖析。這項功能也開啟了全新的人與ChatGPT互動的方式,從文字互動,跨入了影音互動的模式,在第六天的線上發表會中,OpenAI工程師用手機拍攝自己沖咖啡的過程,ChatGPT可以監看手沖咖啡的過程,一步步指示,現在要倒多少咖啡粉,如何移動熱水壺來倒水的過程,就像旁邊有一位資深咖啡師的指導一般。

對OpenAI來說,進階語言功能支援影音對話,提供了一個新的搜集真實世界環境影片的來源,等於多了一個讓生成式模型認識真實世界的資料源。一般用戶所拍攝的影片,都會成為新的訓練素材,Sam Altman自己就強調,AI生成影片是通用人工智慧藍圖的重要一環。OpenAI現在透露出自己掌握通用人工智慧打造方法後,也加速搜集更多、更大量的影音資料,所以,現在才將進階語音功能,發展成了影音對話服務,這是他們邁向通用人工智慧的另一個關鍵。

(圖片來源/OpenAI)

ChatGPT越來越像是附帶開發高手的開發整合工具

o1新一代推理模型的上線,讓GAI應用有了一款更擅長剖析做計畫又擅長解決開發難題的AI助手,使用者可以在ChatGPT中選擇GPT-4o或是o1系列模型(如o1-mini)。

再加上ChatGPT新Canvas功能也能支援程式碼的人機協同開發,再加上新增的「專案」功能,甚至後來在2025年初,推出了「任務」排程執行機制。

這讓ChatGPT不只是一款對話助手,而更像是一款附帶了開發高手陪同開發的開發整合工具(IDE),從開發,除錯,到部署配置建議都能涵蓋。尤其Canvas內建了Python直譯器,不用切換操作介面,就能直接執行Python程式碼,可預期OpenAI未來會增加更多動態語言直譯器支援,例如已有SDK的Node/JavaScript。

這讓ChatGPT上的程式碼開發,不只是可以透過人機協作來生成程式碼,自動產生程式碼的詳細註解,甚至可以採用一種新型態的GAI解讀式除錯作法,透過直譯器檢驗程式碼的可執行性,但不用自己找到出錯的程式碼,改由開發解讀能力超越真人的o1模型,來幫開發者找出程式碼無法執行的問題,甚至提供臭蟲修改建議,直接套用即可。

根據OpenAI釋出的數據,在Codeforces 解題競賽得分上,o1模型達到1891分,大約是全球前5千多名的佳績,至少超越了16萬名真人開發者(全部排名約有16.8萬人)。這個軟體開發解題能力,已經超過了一般企業的新手開發者,可以在線上輔助解決Python程式碼的錯誤。這將會大大改變企業軟體開發除錯的方式,不用自己一行一行追蹤,而是直接問GAI助手給建議。這也是一些軟體輔助開發助手像是GitHub Copilot越來越擅長的除錯輔助能力,可以大大加速除錯的速度,對企業原有的軟體開發方法和流程,帶來很大的影響。

不只是除錯,從OpneAI在發表會上的展示,借助專案功能,可以將相關的開發文件,程式碼範本,業務素材和參考資料,都上傳到同一個專案中,方便管理,也能用o1模型來進行開發框架的切換,將使用舊版開發框架的程式版本,要求o1模型參考開發框架的要求和範本程式碼,將舊版框架的程式碼,轉換成新版框架,也能自動更新套用專案中的業務素材,這都可以大大減少開發者的程式碼更版和維護工具。

隨著o1推理模型,Canvas人機協作寫作與開發、專案管理功能,讓ChatGPT可以成為軟體開發IDE的新選擇。

在OpenAI十二天發表中的前半段,大多聚焦在全新的模型,全新的ChatGPT服務,這些服務不只是增強原本的服務,而是讓人與GAI的互動,從文字互動模式,進入了影音互動,甚至可以說是彷彿是人與機器在真實世界中互動的新典範。

變革關鍵是多模態模型(Large Multimodal Model,簡稱LMM)技術的成熟,去年還只是一項熱門的前瞻技術,到了今年,則變成了人人可用的新型態GAI產品。我們將在下一期繼續剖析十二天發表會的下半場。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06