中國DeepSeek公司宣布以MIT授權開源R1推論模型系列,該系列在數學與程式開發等相關測試中表現出色,部分領域已達到與OpenAI o1模型相當的水準。而R1模型系列的特別之處在於其以強化學習(Reinforcement Learning,RL)為核心訓練方法、不需要監督微調(Supervised Fine-Tuning,SFT),突破了傳統對大規模標註資料的依賴。

DeepSeek-R1系列模型其訓練方法的突破,在DeepSeek-R1-Zero模型完全透過強化學習,展現出關聯思考(Chain of Thought,CoT)、自我驗證與反思能力等推理特性。與傳統仰賴大規模標註資料的模型不同,DeepSeek證明了僅憑強化學習即可激發大型語言模型的推理能力。

只不過DeepSeek-R1-Zero模型的可讀性和語言一致性仍不足,為了克服該問題並提高推理效能,DeepSeek在強化學習之前,進一步採用冷啟動資料及多階段訓練策略,推出了改進版本DeepSeek-R1,成功提升了模型的整體性能。

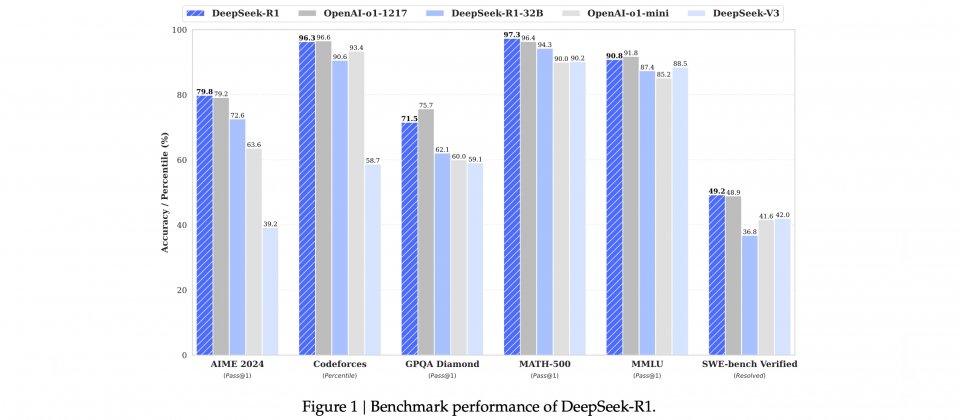

根據DeepSeek公開的論文,DeepSeek-R1模型在多項基準測試表現突出,在數學相關的MATH-500測試,其Pass@1準確率達到97.3%;在AIME 2024數學競賽測試中,達到79.8%的準確率,表現接近OpenAI o1模型。此外,DeepSeek-R1在Codeforces程式競賽平臺上的評分達到2029,勝過96.3%的參賽者,僅略低於OpenAI o1的96.6%,顯示其在程式開發領域的應用潛力。

在開源策略上,DeepSeek釋出了完整模型,還推出多個經過蒸餾處理的模型版本,參數範圍從15億至700億不等,供不同資源需求的開發者或研究者使用。根據測試結果,蒸餾模型在AIME 2024、MATH-500與CodeForces等多項基準測試,超越像是GPT-4o與Claude-3.5-Sonnet等模型。

雖然DeepSeek-R1表現出強大的能力,但仍存在一些限制,例如模型對提示詞的敏感性較高,尤其是當使用小樣本提示(Few-Shot Prompting)時,模型的性能會明顯下降,因此,建議用戶採用零樣本提示(Zero-Shot Prompting)的方式,也就是直接描述問題並明確說明輸出格式,而不提供任何範例。此外,目前該模型主要針對中英雙語最佳化,在處理其他語言的查詢時偶爾會出現語言混用現象。

DeepSeek-R1也以deepseek-reasoner API的形式提供服務,輸入部分快取命中每百萬Token為0.14美元,未命中是0.55美元,輸出部分則按推理內容與最終答案的總Token數計價,每百萬Token收費2.19美元。與其他同等商業模型相比,DeepSeek-R1提供了極具競爭力的價格。

不過,由於DeepSeek-R1模型來自中國公司,無論API服務與開源模型皆受中國政府言論審查,企業與個人使用仍應注意其潛在的內容生成規範與風險,特別是在敏感領域的應用。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10