鴻海揭露自家700億參數的繁中語言模型FoxBrain,以Llama 3.1 70B模型為基礎,再以合成資料和120張H100 GPU訓練而成,在數學推理等領域表現優異,超越國內同等規模的Llama-3-Taiwan-70B。

鴻海

鴻海研究院3月10日揭露自家首款繁體中文大型語言模型(LLM)FoxBrain,以Llama 3.1 70B模型為基礎,以120張H100 GPU、花4周訓練而成,不只繁中能力超越Llama-3-Taiwan-70B,還具備良好的數學和邏輯推理能力,可執行數據分析、決策輔助、文書協作和程式碼生成等任務。鴻海預告,後續將開源FoxBrain。

用980億Token中文合成資料訓練模型,表現超越Llama-3-Taiwan-70B

進一步來說,鴻海研究院人工智慧研究所選定Llama 3.1 70B模型作為基礎,並以連續預訓練(Continual Pre-Training)、監督式微調(Supervised Finetuning)、AI回饋強化學習(RLAIF)和適應性推理反思(Adaptive Reasoning Reflection)等方法來強化模型表現。

其中,連續預訓練是要加強模型繁中能力,於是團隊先建立24類主題的資料增強方式和品質評估方法,來生成980億個Token的高品質中文預訓練資料,讓模型具備更好的繁中理解力。

再來,他們使用120張Nvidia H100 GPU和Nvidia Quantum-2 InfiniBand網路來擴展運算,只花四周就完成訓練,比其他同等模型的訓練效率更好、成本更低。鴻海補充,他們採用Nvidia的Taipei-1超級電腦,以及Nvidia NeMo生成式AI雲原生框架來訓練模型。

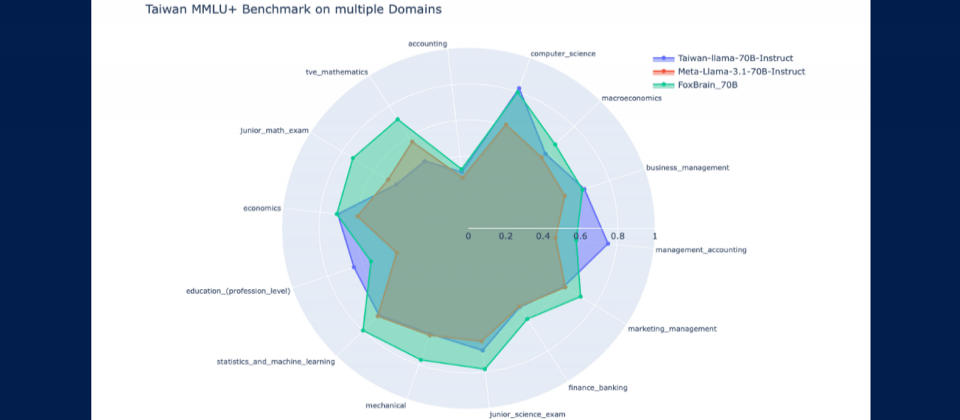

這個FoxBrain可處理的上下文長度為128K Token,再加上團隊使用Adaptive Reasoning Reflection方法,讓模型學會自主推理。經TMMLU+基準測試,FoxBrain在大多數領域優於國內同規模的繁中模型Llama-3-Taiwan-70B,比如統計和機器學習、財務、行銷管理等;在數學和邏輯推理方面,表現更突出許多。

FoxBrain模型與Meta Llama 3.1 70B、Llama-3-Taiwan-70B在TMMLU+上的重要領域得分比較

與Meta基礎模型Llama 3.1相比,FoxBrain在數學領域表現好,甚至在數學推理能力上超越Meta目前的同等級模型,但與DeepSeek的蒸餾模型仍有些微差距。

鴻海表示,FoxBrain模型原是鴻海研究院為集團內部應用而設計,未來將開源模型,並持續與技術夥伴合作、擴大應用範圍,同時也要推動AI在製造業、供應鏈管理和智慧決策領域的應用。

FoxBrain也將成為鴻海智慧應用升級的重要引擎,來優化他們的智慧製造、智慧電動車、智慧城市等三大平臺數據分析效率。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06