綜觀近期一系列以Intel® Optane™ 產品線為主軸的文章,針對 Intel® Optane™ 持續性記憶體 (Intel® Optane™ Persistent Memory;PMEM) 的論述中,提到PMEM除支援記憶體模式 (Memory Mode) 外,亦支援應用程式導引模式 (App Direct Mode)。

假使設定為 App Direct Mode,應用程式與作業系統會察覺到伺服器平台中,存有兩種可直接載入/儲存資料的記憶體,且能根據資料的讀取或寫入,導引至適合的 DRAM 或 PMEM。如需要持續保留、或本身結構相對龐大的資料,就適合交由PMEM處理。

以下的篇幅,將介紹一款來自Intel® 策略夥伴 Lightbits Labs 公司的產品,為 Lightbits 軟體定義儲存 (SDS) 解決方案,便是採用 App Direct Mode 的經典案例。具體來說,Lightbits 並非僅能使用Intel® 硬體,但已針對Intel® 的CPU、NIC、PMEM 等元件進行最佳化調適,所以透過 Lightbits、Intel® 的軟硬搭配,可展現最佳執行效率。

採分離式架構,運算、儲存各據一隅

當今市場上已有不少SDS產品,但大多偏向超融合 (HCI) 架構,反觀Lightbits則是走截然不同的「分離式」路線,算是一種Disaggregated NVMe/TCP Block Storage解決方案。

何謂分離式 (Disaggregated)?在概念上,Lightbits 將運算、儲存兩種節點分開,所以若企業資料中心採用該產品,一端會有一群應用伺服器,這些伺服器都不會把資料存在自己肚子裡的磁碟,而會存放於另一端的儲存叢集 (Storage Cluster)。在儲存叢集內,通常會配置3台 (含) 以上儲存節點,企業可自由選用任一廠牌 x86 伺服器來扮演儲存節點角色,惟每一個節點皆需安裝 Lightbits 軟體。

雖然運算、儲存分處兩端,但令人驚艷的是,應用伺服器不管讀取或寫入資料,就好像在本地執行一樣,兼具高效能、低延遲雙重優勢。另一方面,舉凡應用端所能支援的軟體類型,不論 Kubernetes、Docker、Kafka、MySQL、MongoDB…等等,Lightbits 基本上通通都支援;換言之 HCI 環境能跑的軟體,到了 Disaggregated 環境,也照樣能跑。

微秒級低延遲表現,猶如存取本地磁碟

談到 Intel® 與 Lightbits Labs 展開合作的原因,如同前述在於 Lightbits 軟體針對 Intel® 元件進行優化。它除了支援 PMEM 的 App Direct Mode 外,也支援 Intel® Xeon® 可擴充處理器的 VMD 功能,無需借助額外硬體轉接器,便可從 PCIe 匯流排直接控制和管理 NVMe SSD;另支援 Intel® Ethernet 800 系列網卡,不僅能藉由 100GbE 高速網路,將應用端的資料快速傳送到儲存端,且拜支援應用裝置佇列 (Application Device Queues;ADQ) 技術所賜,得以顯著降低應用程式延遲。

無論應用伺服器運行在 Kubernetes、VMware 或裸機等環境,只要立基於 Intel® 架構,並將 NVMe Driver 安裝妥善,便能立即以無縫接軌方式,高速連通 Lightbits 所在的儲存叢集。

經過實測,假設以 Random 4KB I/O 為前提,Lightbits 在 Read Only 狀態下,IOPS 為 14M、頻寬為 53GB/s,效能表現堪稱優異;若在 Write Only 狀態,由於需要寫入兩份 Copy、做的事情更多,以致處理效能會慢於 Read Only,但以 IOPS 2.3M、頻寬 8.9 GB/s 的實際表現來看,對比其餘儲存方案仍相對突出。

說到這裡,必須針對 DRAM、PMEM 兩者在 Replication 的差異點提出說明。不難理解,資料中心裡的數據極為重要,萬一遺失或損毀,後果不堪設想,故需透過多份複製來保護資料。以一般 DRAM 架構來看,皆會產生 3 份 Copy,反觀 PMEM,因它本身既是 Persistent 記憶體、也是 Persistent 儲存,資料只要寫入它,就算是 Commit 完成,不再有遺失風險,既然相對安全,所需 Copy 可減為兩份,連帶有助提高寫入效能。

不過針對資料庫應用場景,經常需要彙集一筆筆小資料、再做合併寫入,其間難免有等待過程,如此就不能一昧只看頻寬大小,更需關注延遲 (Latency)。此時同樣以 Random 4KB I/O 為前提,Lightbits 在 Read Only 狀態下,平均延遲為 158.76 微秒 (usec),而一般由伺服器內置的 NVMe Disk,延遲約為 80~100 微秒,足見 Lightbits 即便在 Disaggregated 架構下,其延遲已非常接近內置式磁碟,相較一般 Remote Storage 的延遲動輒 2 毫秒 (msec)、3 毫秒甚至超過 10 毫秒的表現,更是遙遙領先。

針對寫入部份,Lightbits 的平均延遲為 493 微秒,相當於原來 Application Node 寫入肚子裡硬碟的速度,依舊值得讚賞。

擴充彈性大,且無 Vendor Locking 疑慮

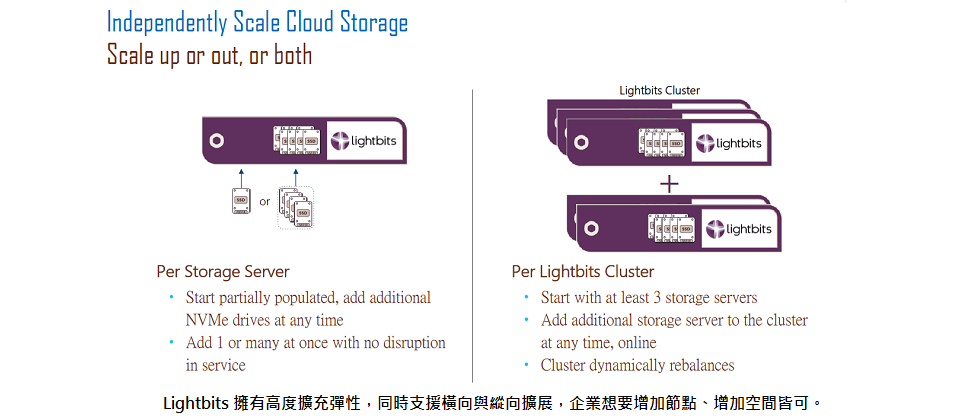

大致上來說,Lightbits 蘊含幾項少見優勢。首先大家在使用儲存叢集時,最在意的無非就是擴展性,確實也有部份解決方案要依照運算、儲存的配比同步執行擴充,不僅彈性較低,也迫使企業做出不必要的投資;然而 Lightbits 的擴充彈性甚大,不管要在原有節點上擴充儲存空間,或在叢集中加入新節點,通通皆可,企業想怎麼做就怎麼做。此外 Lightbits 完全不綑綁硬體,企業可選用任何偏好的 x86 伺服器,也算是另一種高彈性。

更重要的,綜觀前面提到的效能/延遲實測數據,在在顯示 Lightbits 即便採取分離式架構、而非融合式架構,仍可展現快捷的資料寫入與處理速度,此與應用端、儲存端之間走 100GbE 高速網路,有所關聯。

就業界經驗法則,要達到微秒級低延遲,需要搭配較為高速的網路,一種是 100GbE,另一種是 RDMA (Remote Direct Memory Access);然而 Lightbits 採用 100GbE 技術的好處,在於它仍是常見的 TCP/IP 網路,網路架構與設備變動需求微小,但企業若欲採用 RDMA,則需另外購置其他設備,成本相當吃重,就這點來看,確實能突顯 Lightbits 高性價比特質。著眼於此,已有過去採用 Ceph 架構的用戶,開始轉換跑道改採 Lightbits 方案,以期大幅提升 IOPS 並降低延遲。

了解更多,請點此。

熱門新聞

2026-02-05

2025-09-18

2026-01-30

2025-07-17

2025-05-02

2025-03-28