對於全球三大公有雲服務供應商(CSP)而言,這幾年陸續揭露本身IT基礎架構進行改良的技術發展。以AWS為例,2013年開始研發Nitro系統架構,2017年正式公開,如今已開展出Nitro Cards、Nitro Security Chip、Nitro Hypervisor、Nitro Enclaves、NitroTPM等多項技術。

其他雲端服務業者也急起直追。例如,微軟在2018年3月發表論文,揭露2015年開始部署基於FPGA晶片而成的訂製型SmartNIC,以此建置加速網路環境Azure Accelerated Networking(AccelNet),並提及他們打造的兩代Azure SmartNIC,後續升級採用Intel Arria 10 FPGA技術。到了2023年,7月下半微軟預告將推出全新的系統架構Azure Boost,11月中正式上線。根據微軟目前公開的文件指出,此架構可將網路、儲存、伺服器管理等傳統由Hypervisor與作業系統處理的工作,卸載到專屬設計的硬體與為此進行調校的軟體執行,整體配置包含多種元件,目前已知有網路卡Microsoft Azure Network Adapter(MANA)、固態硬碟Azure Boost SSD、Azure Boost系統單晶片(SoC)、Azure Boost FPGA晶片,以及Cerberus硬體信任根晶片、SELinux作業系統(不過,他們並未透露與Azure既有加速網路環境的差異)。

Google Cloud這兩年也開始公開相關的技術進展,像是2022年10月他們發表C3系列運算服務,除了標榜採用即將上市的英特爾第四代Xeon Scalable處理器,也提到裡面將搭配為其量身打造、由Google Cloud與英特爾共同設計的基礎設施處理器(IPU),以及區塊儲存服務Hyperdisk,相較於上一代運算服務C2,效能增長20%。2023年5月C3正式推出,Google Cloud提到IPU主要負責網路處理的卸載(Offload),8月底更揭露他們發展的系統架構Titanium system,等於正式宣告邁入以硬體加速IT基礎架構的新紀元,也突顯運用專屬系統架構來分攤底層資源管理負擔的作法躍居主流,成為大型資料中心環境強化整體IT服務性能的必備技術。

從FPGA延伸至基礎設施處理器,英特爾確立兩種路線

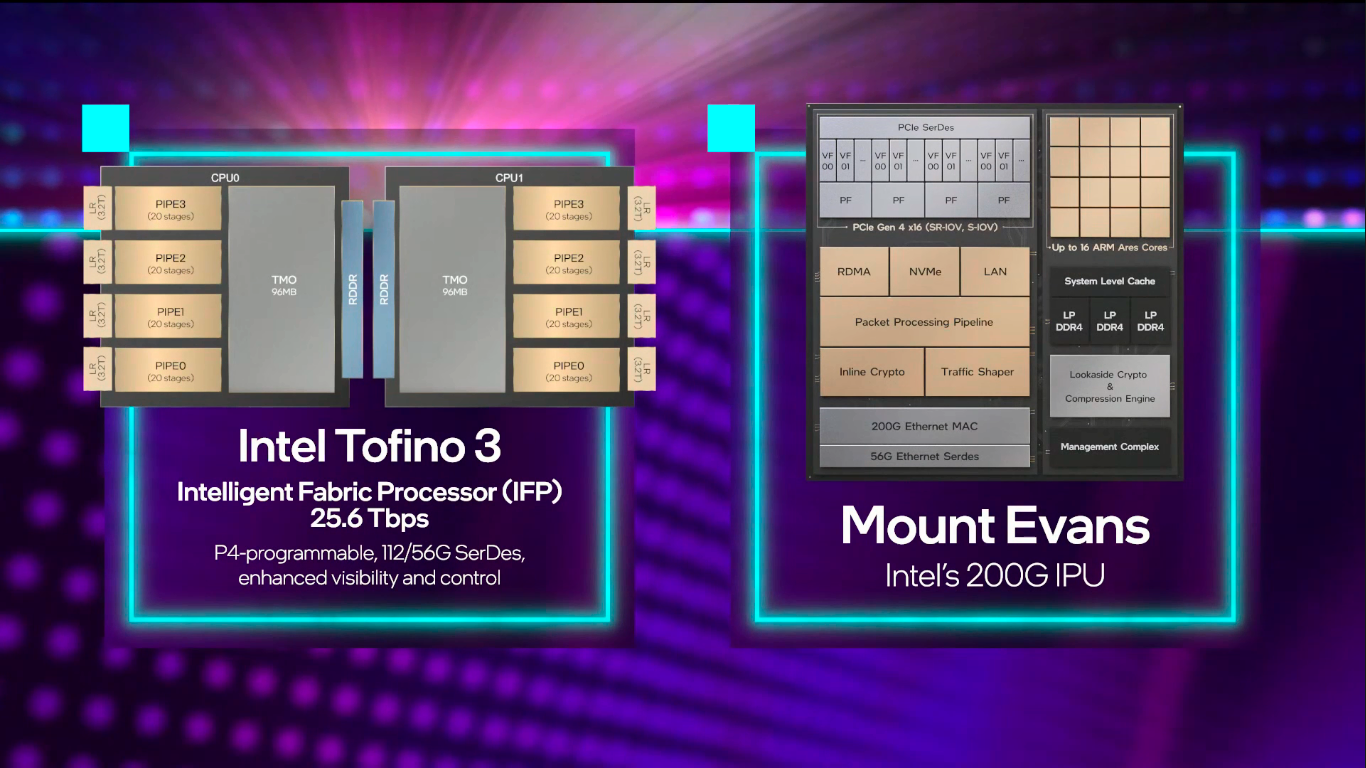

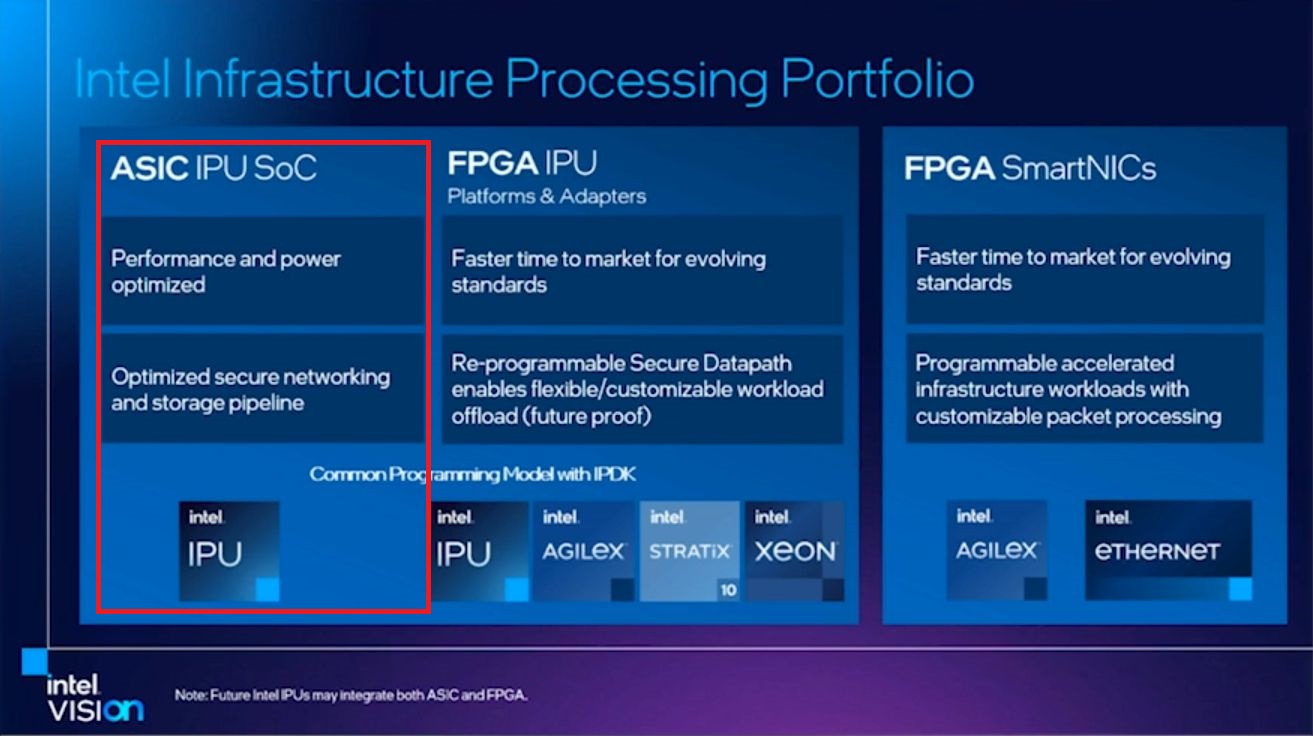

隨著SmartNIC與DPU這類I/O加速產品被拱上檯面,英特爾在2021年6月正式提出基礎設施處理器的產品概念,當中囊括基於FPGA的加速運算卡與專屬ASIC,而在8月舉行的英特爾架構日活動,他們正式公布IPU產品陣容,的確區隔如上述的兩大類,並將第一類細分為IPU平臺與SmartNIC,代表的產品分別是代號為Oak Springs Canyon的參考平臺(FPGA搭配Xeon/英特爾架構(IA)),以及代號為Arrow Creek的加速開發平臺N6000,第二類則是代號為Mount Evans的ASIC架構IPU,當時英特爾大方公布這款晶片的元件組成,我們在同年9月的封面故事《2022 Intel運算架構大公開!》,也整理他們初步揭露的幾項特色,像是包含運算與網路兩大部分,前者內建16顆Arm Neoverse N1核心、英特爾QAT密碼學與壓縮處理加速技術,以及用於管理的專屬處理器,後者則內建封包處理引擎、NVMe、200GbE網路、RDMA等技術。

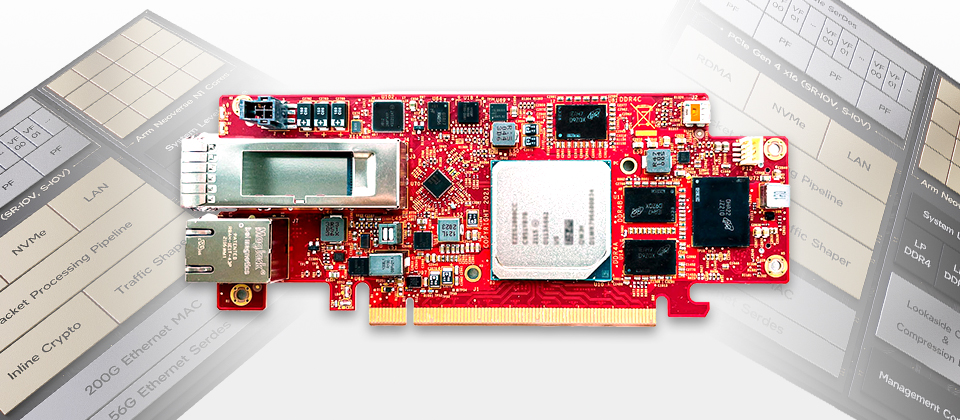

研發代號為Mount Evans的英特爾IPU E2000,區分為兩大元件,一個是運算複合體,包含Arm處理器核心、低功耗DDR4記憶體、密碼學與壓縮加速引擎;另一個是網路子系統,提供200 Gb乙太網路介面、封包處理管線,支援RDMA、NVMe的網路與I/O存取,也內建I/O虛擬化功能。

2021年英特爾預告將推出ASIC架構的基礎設施處理器(IPU),在8月舉行的架構日,首度揭露這款晶片的外觀與技術架構。

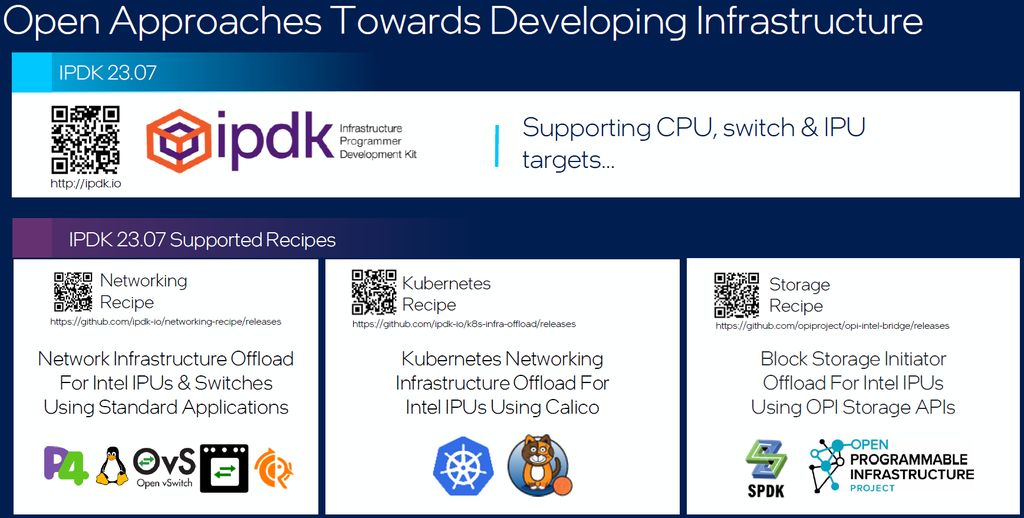

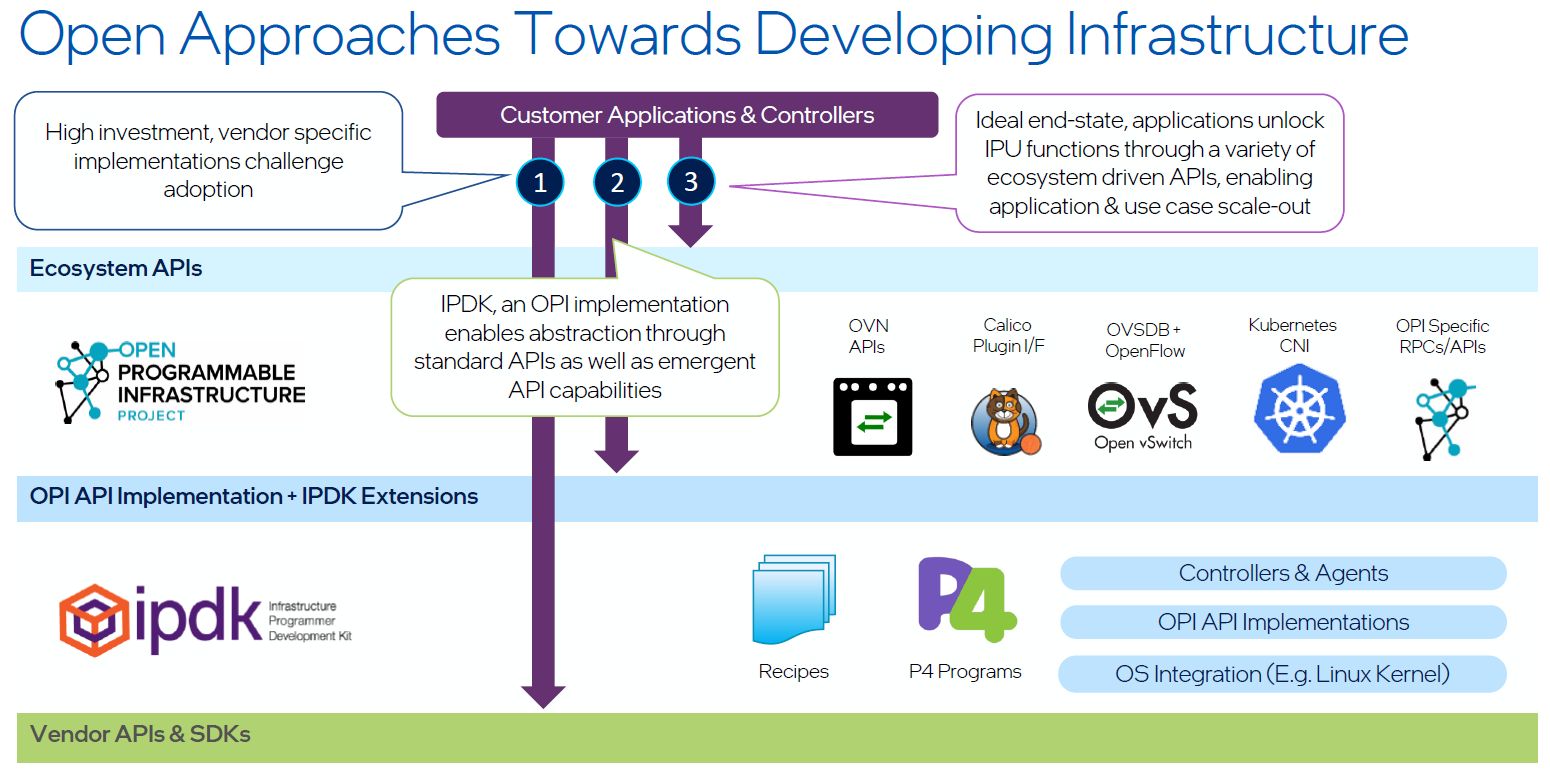

2021年10月舉行的Innovation年度用戶大會,英特爾表示,關於Mount Evans的運用,將與公有雲業者Google Cloud展開深層合作,設計與發展支援P4程式語言,以及基礎架構程式設計師開發套件(IPDK)的開放解決方案,以便簡化開發者存取Google Cloud資料中心的方式。

到了2022年5月舉行的上半年用戶大會,英特爾默默將Mount Evans定名為IPU E2000,並預告這一年開始出貨給Google與其他服務供應商,2023年可望廣泛部署。

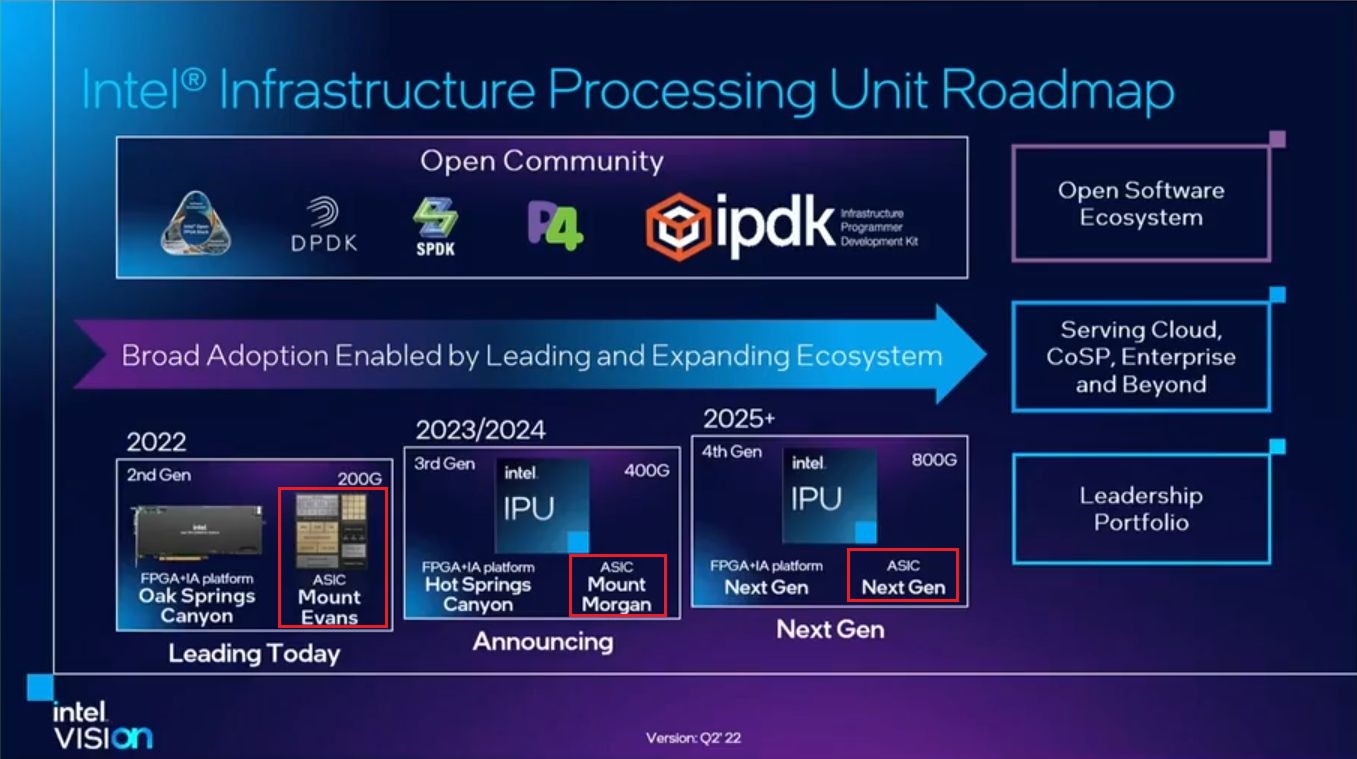

他們也公布2022至2025年IPU發展藍圖,其中先上陣的產品,就是先前介紹的Oak Springs Canyon(原本稱為FPGA IPU C6000X-PL,現改名為IPU Platform F2000X-PL),以及代號為Mount Evans的IPU E2000,將它們定調為第二代IPU,可支援200 Gb/s網路環境;2023至2024年將推出第三代IPU,分別是代號為Hot Springs Canyon的FPGA+IA平臺,以及代號為Mount Morgan的ASIC架構IPU,可支援400 Gb/s網路環境;2025年以後將推出第四代IPU,FPGA+IA平臺與ASIC架構IPU都將有新一代產品,可支援800 Gb/s網路環境。

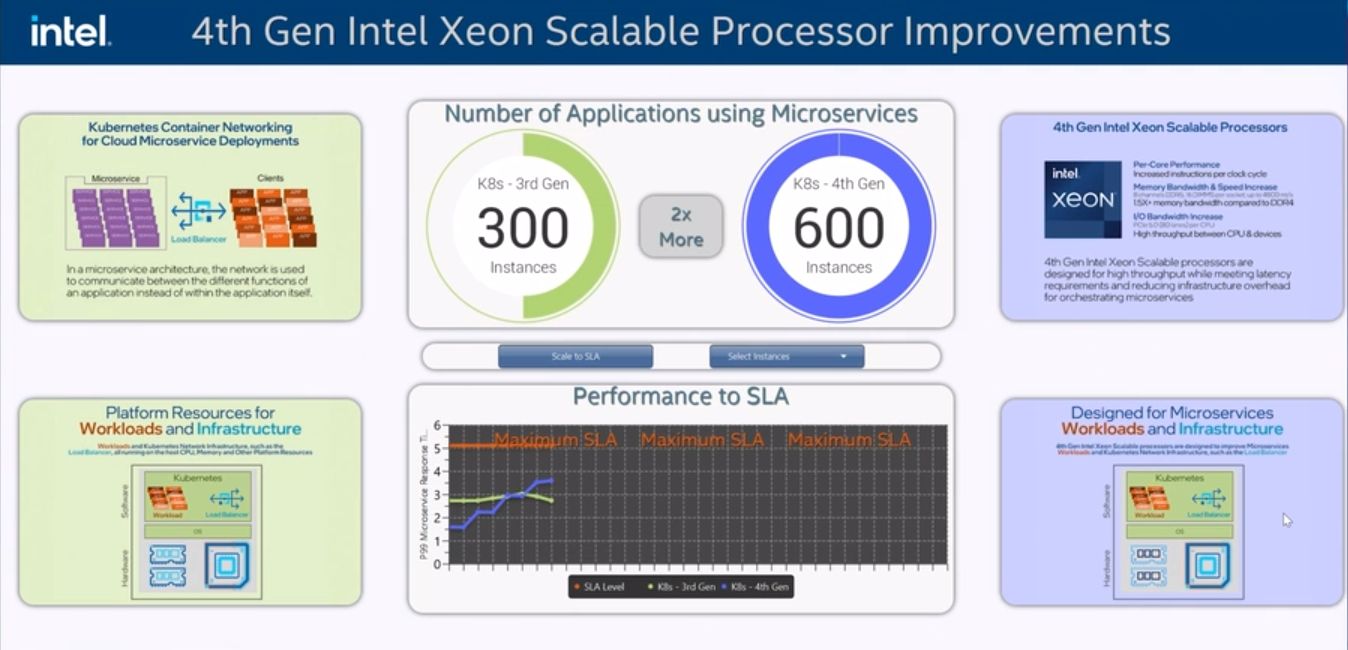

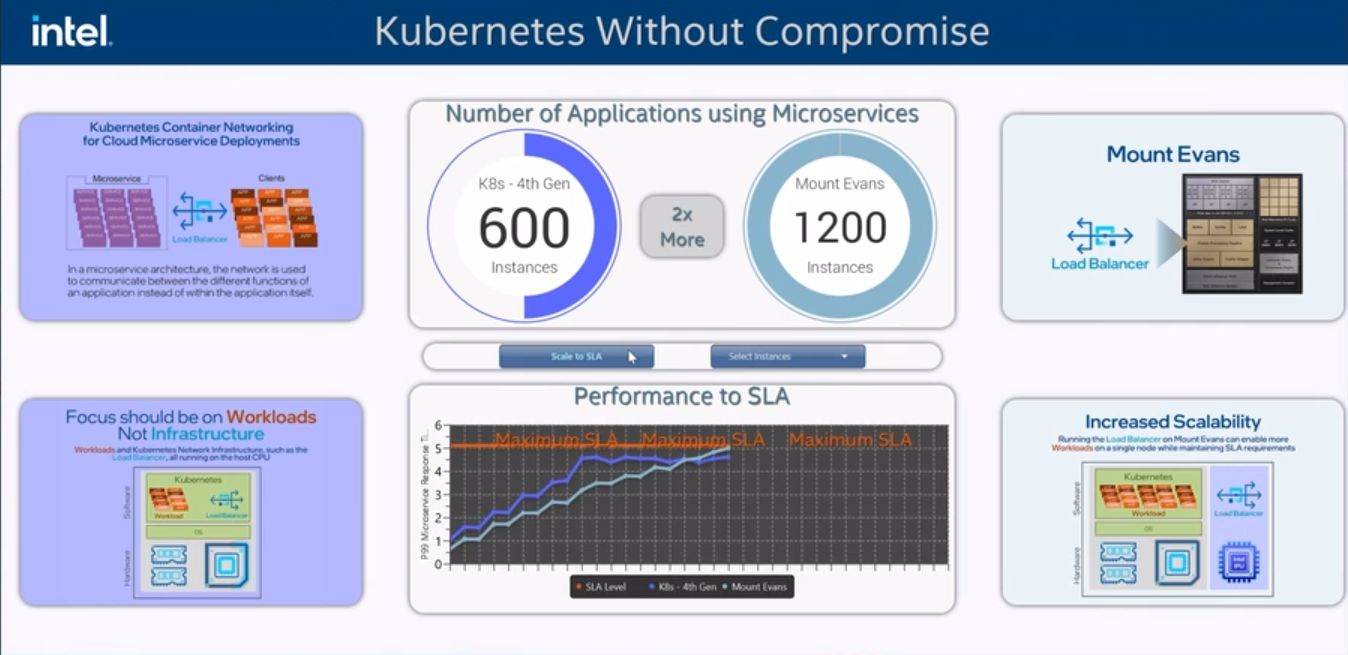

在此同時,他們還特別揭露了ASIC架構IPU的效能。以採用第四代Xeon Scalable處理器的伺服器為基準,搭配Mount Morgan之後,效能改善幅度為30%,在低於5毫秒的延遲要求之下,可支援的用戶端數量可從600臺增加到1,200臺。

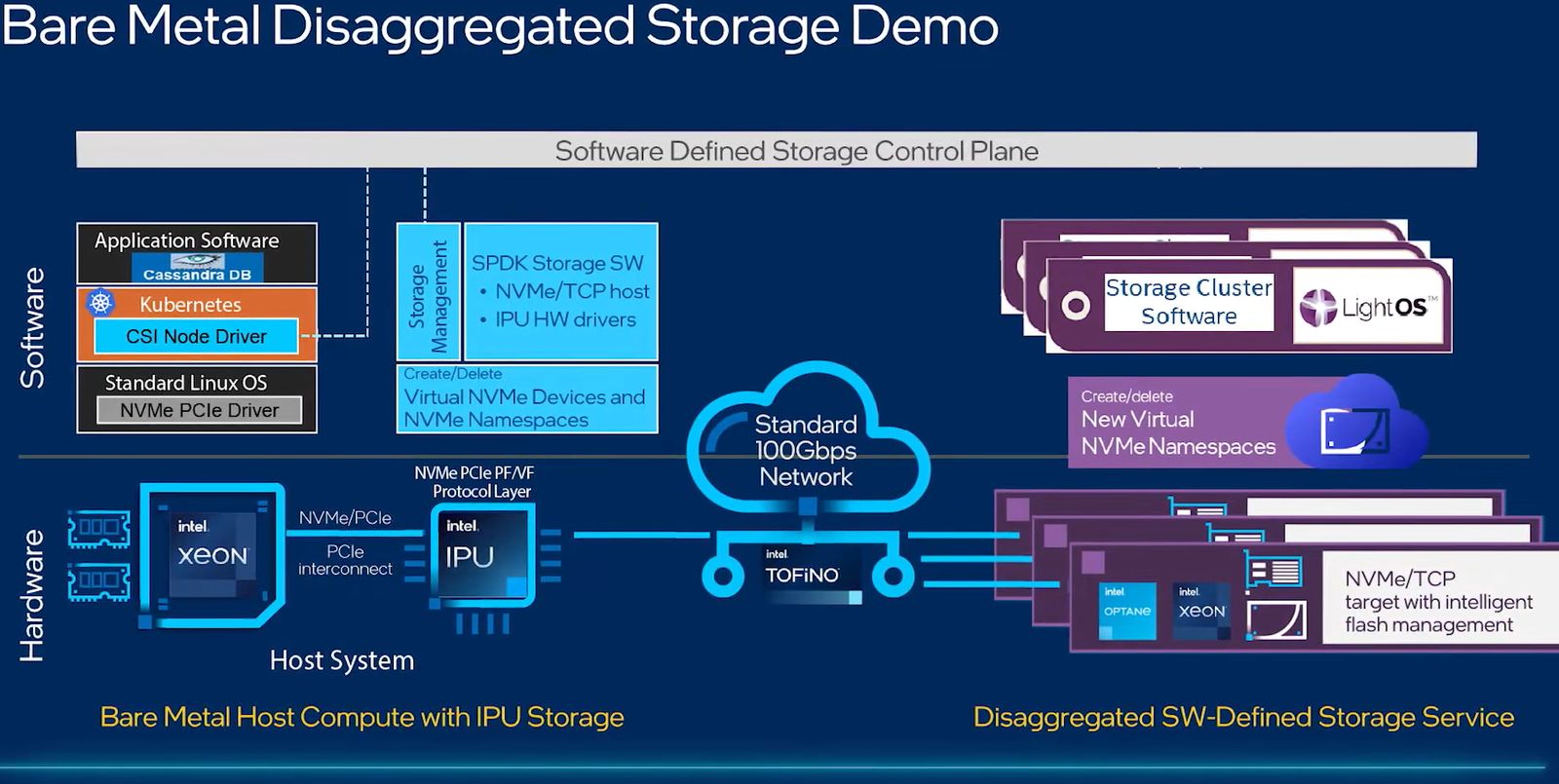

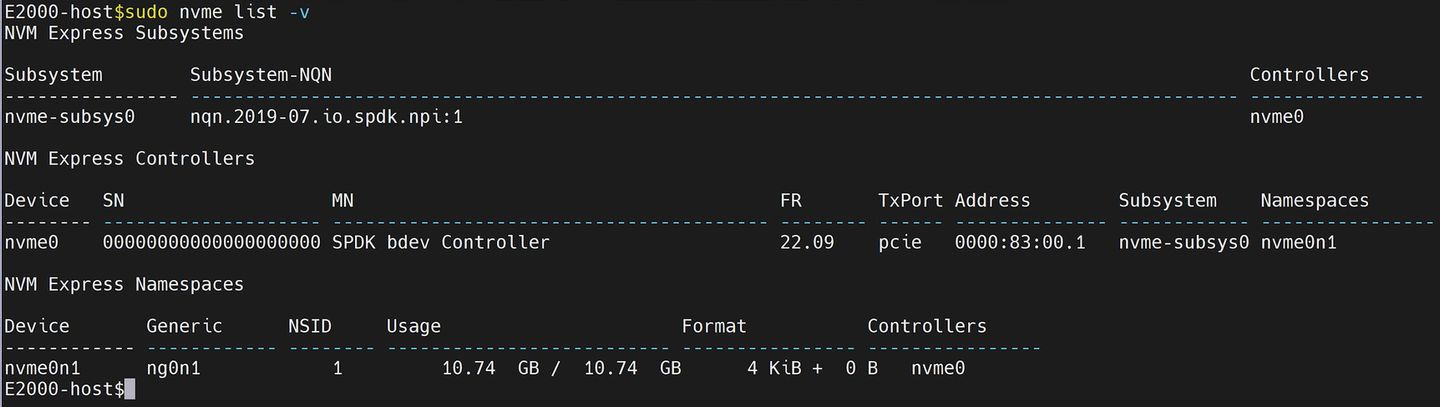

英特爾2022年9月底舉行的下半年Innovation全球用戶大會,也展示Intel IPU E2000的儲存負載卸載成效,顯示儲存系統搬移到搭配IPU的系統時,處理器運算循環週期可節省至少2倍,並且能因應耗用大量頻寬需求的儲存解決方案使用,提供等同於網路線速(linespeed)的傳輸能力。

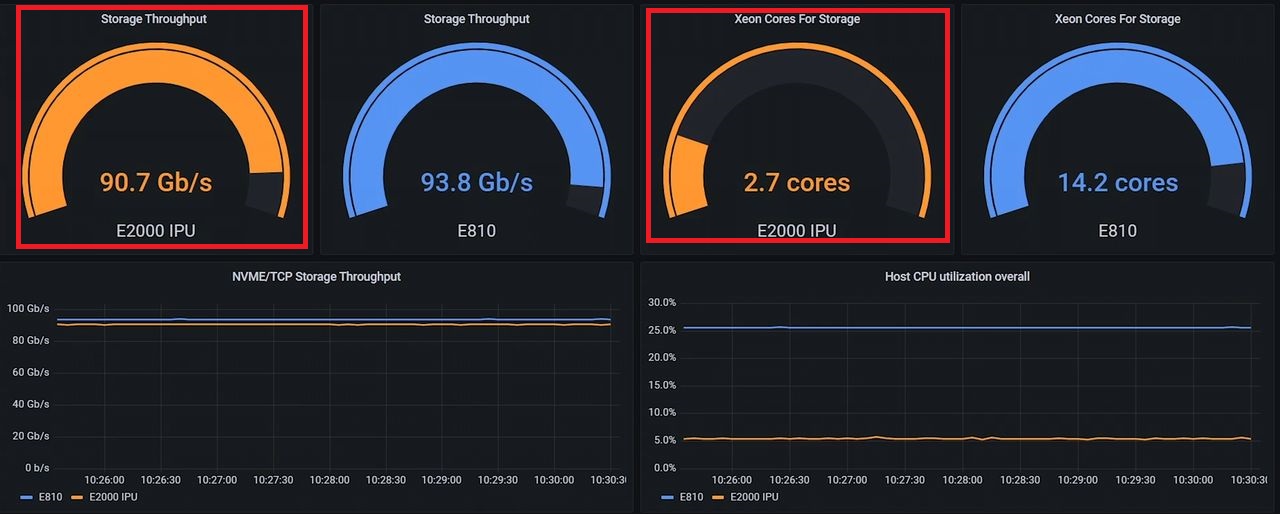

透過儲存系統的測試上,英特爾試圖證明IPU系統所需的網路頻寬較低。在他們設置的環境中,搭配E810網卡的伺服器連上Lightbits公司的軟體定義NVMe/TCP儲存叢集系統LightOS,網路流量為93.8 Gbps,而搭配IPU E2000的系統連接這套儲存系統時,網路流量為90.8 Gbps;

關於CPU資源的耗用上,搭配英特爾第四代Xeon Scalable處理器與E810網卡的系統,CPU核心會使用到14.3顆之多,至於搭配Intel IPU E2000的系統,由於可將儲存系統發起端(initiator)的邏輯處理交由IPU負責(從CPU卸載至IPU),因此,CPU只需要用到2.7顆核心,並且維持網路吞吐量與運算效能,等於可節省11.6顆核心。

Google是英特爾ASIC架構IPU的最大支持者

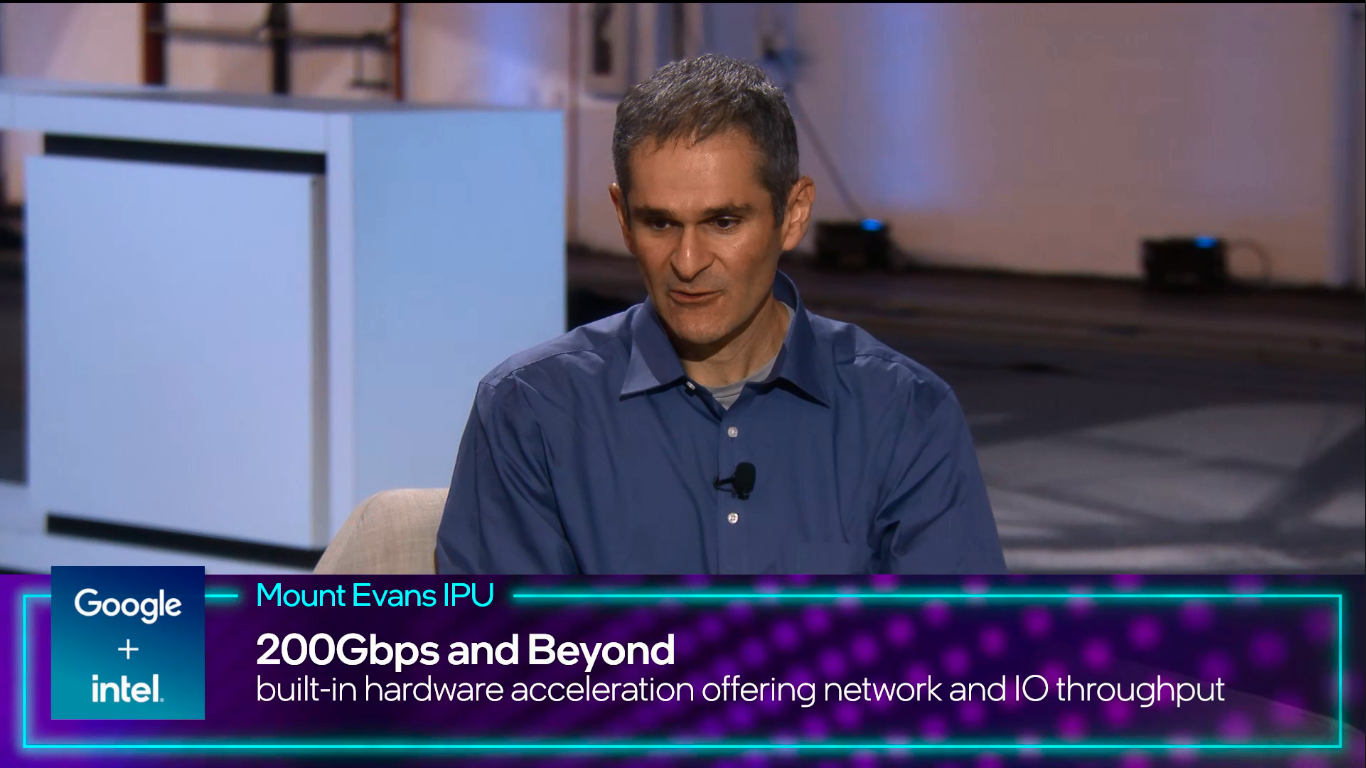

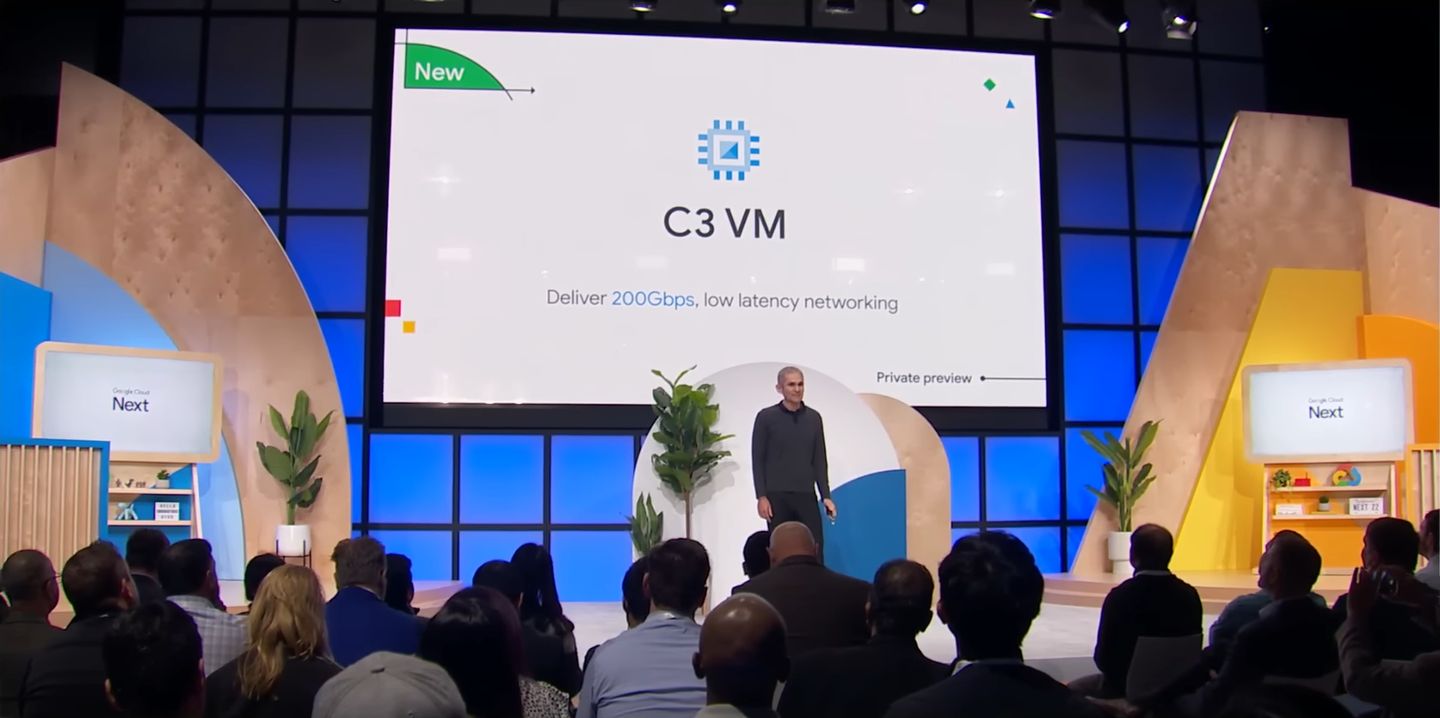

相隔幾週之後,Google Cloud在2022年的Next用戶大會發表新的執行個體(虛擬機器)服務C3,開放用戶進行封閉預覽測試,這系列鎖定一般用途的雲端運算服務,預計將採用英特爾第四代Xeon Scalable處理器,以及他們與英特爾共同設計的訂製型ASIC架構IPU,而這款元件也就是Intel IPU E2000,Google Cloud會將可程式化的封包處理負擔從CPU端釋出,轉交IPU E2000處理,並以安全的方式運作,提供200Gb/s線速與低延遲的網路傳輸能力——當中將會支援Google Cloud在2022年開放原始碼的PSP安全協定(PSP Security Protocol),以此提供硬體卸載大規模密碼學處理的機制,做到以線速進行的網路傳送過程加密(In-transit encryption),而且,目前用於正式環境的Linux系統核心、網路虛擬化堆疊Andromeda,以及主機網路系統Snap,都已支援PSP。

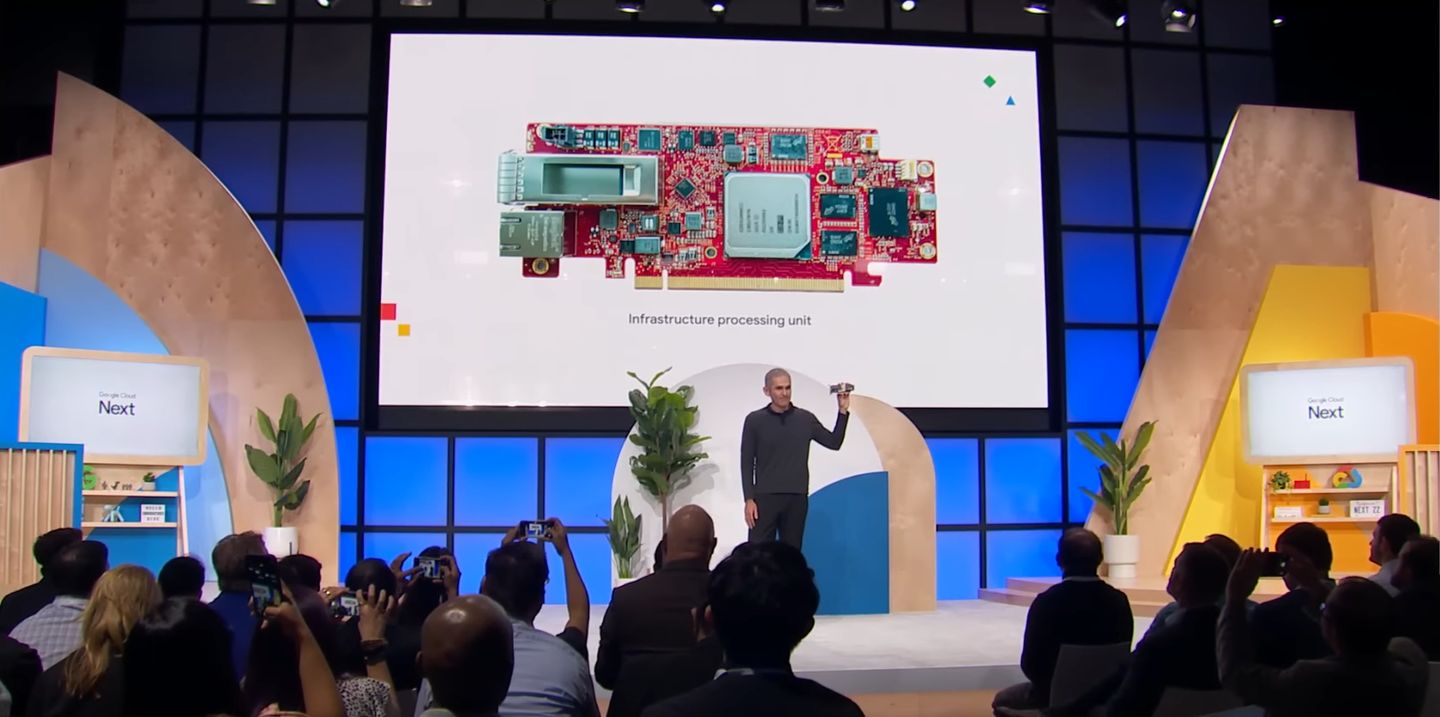

2022年10月英特爾ASIC架構IPU正式亮相,出現的場合是在Google Cloud的年度用戶大會,該公司機器學習系統和Cloud AI副總裁暨總經理Amin Vahdat公開展示這款產品,並表示這是他們與英特爾共同設計的訂製型解決方案。

2023年5月,C3正式上線,Google Cloud對於IPU的運用,特別提到幾個特色。首先是IPU內含兩個元件,一個是將工作負載卸載至IPU的網路虛擬化堆疊Andromeda,另一個是可程式化封包處理引擎,能實現更高階的網路連線效能供應、隔離,以及安全控管功能;第二,IPU能讓C3支援更大規模的虛擬機器組態,可減少用戶工作負載與應用程式網路I/O對其造成的干擾;第三,C3系列的虛擬機器可使用200 Gbps的低延遲網路連線,提供兩倍於前代虛擬機器的連線效能,更適合用於緊耦合架構的分散式運算、高效能運算,以及網路密集型工作負載。

除此之外,Google Cloud的區塊儲存服務Hyperdisk,也能利用IPU技術,讓虛擬機器能夠將原本綑綁的儲存處理進行解耦,提供更強大的效能、彈性與效率,而在C3搭配的區塊儲存Hyperdisk,相較於前一代虛擬機器C2,可提供4倍的儲存吞吐量,以及10倍的IOPS效能。

而在同一時間,他們也發表新一代GPU運算服務A3,比起上一代的同類虛擬機器服務A2,網路頻寬可提升10倍,提供高度穩定與低度尾延遲(low tail latencies)的表現,原因在於採用他們訂製的200 Gbps傳輸能力IPU,並搭配特製的跨伺服器GPU通訊堆疊,以及支援Nvidia集結通訊程式庫(NCCL)最佳化處理,促使GPU之間資料的傳輸,可透過不經由伺服器CPU的直接I/O路徑進行,並且可在個別的網路介面遞送其他虛擬機器的網路連線與資料流量。

8月初Google Cloud發表鎖定運算最佳化用途的運算服務H3,當中繼續採用他們訂製的IPU,而這類元件包含卸載網路堆疊Andromeda、可程式化封包處理引擎,提供高人一等的網路效能、隔離設置,以及安全防護機制,更適合緊密耦合的分散式運算,以及網路密集型工作負載,可支援緊緻型設置(compact placements),並且部署在大型、密集的IT資源池,可減少延遲與網路流量抖動,改善高效能運算應用的規模擴展程度。

到了2023年8月底舉行的Next年度用戶大會,Google Cloud在介紹C3、A3、H3等第三代Compute Engine運算服務,以及新一代區塊儲存服務Hyperdisk時,特別提到這些服務之所以能產生更大的效能、廣泛支援多種工作負載,是因為底層IT架構採用他們發展的Titanium system,而上述訂製型IPU也是此系統平臺的重要元件。

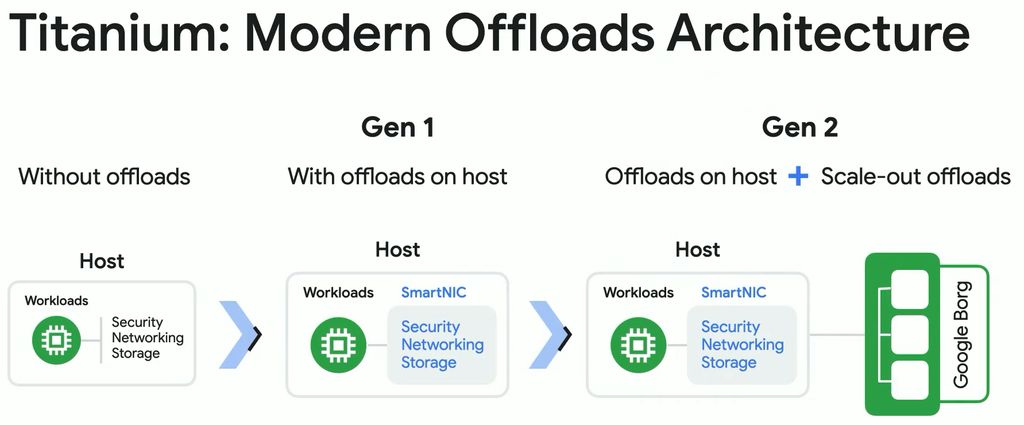

Titanium結合多種Google內部開發的多種技術,目前包含三大元件:卸載卡Titanium adaptor、卸載處理器Titanium offload processors,以及硬體信任根晶片Titan security microcontrollers,可用於擴展執行規模與效能,以及多種雲端服務環境的使用場景。

Google Cloud發展可卸載網路與儲存負擔的系統架構,命名為Titanium,在2023年8月底的全球年度用戶大會公諸於世,表明Google Cloud Compute第三代運算服務導入此架構,而他們設計的IPU是箇中關鍵。

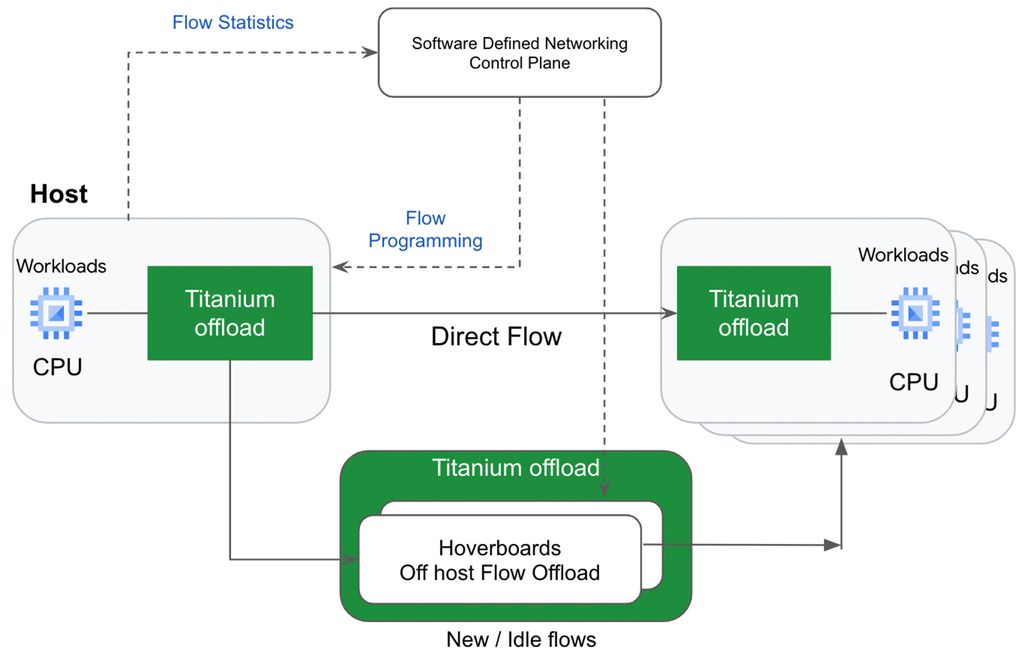

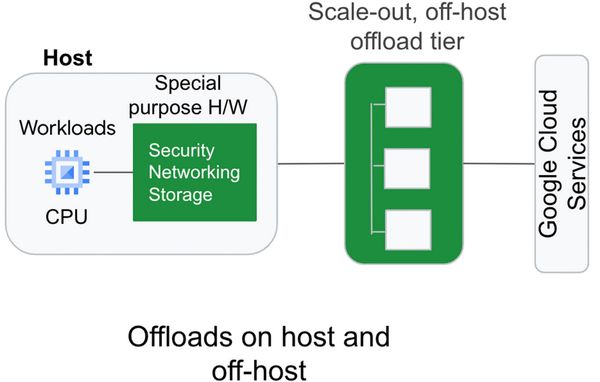

舉例來說,若要在雲端環境以橫向擴展的方式執行大規模的現代化工作負載,有了Titanium,不僅能延伸整個架構,增添伺服器內部的卸載處理,也能在伺服器外部執行、可橫向擴展執行規模的卸載層(scale-out offload tier)處理。而這樣的卸載系統架構能夠廣泛進行部署,並且對於需持續提供最佳效能的工作負載,也能進行動態調整。

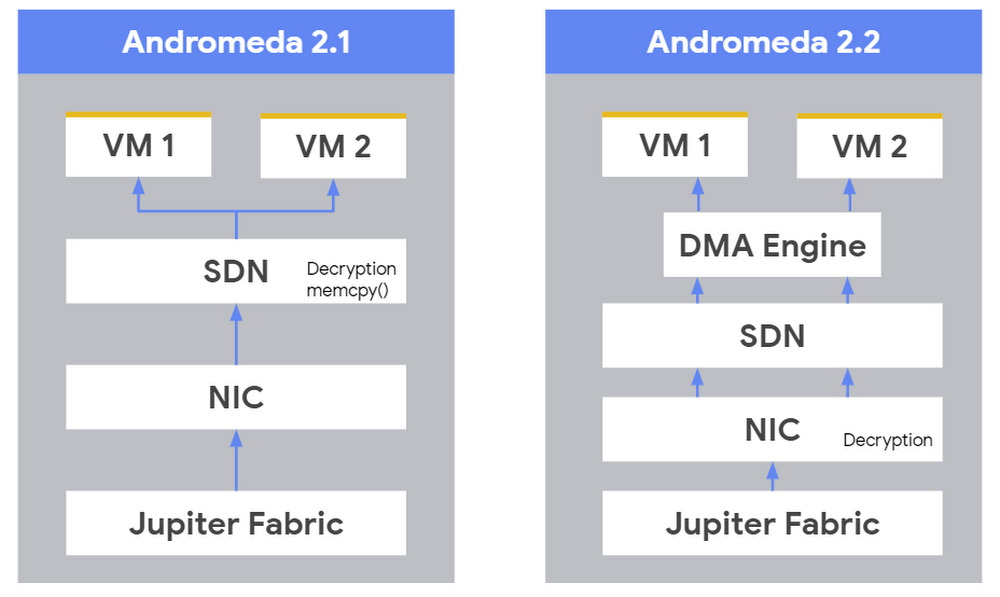

Titanium目前可用於區塊儲存與網路路由等兩種類型的IT資源調度,執行橫向擴展規模的卸載處理。以前者而言,Hyperdisk區塊儲存透過Titanium將工作交給伺服器的IPU處理,之後搭配Titanium的橫向擴展卸載層,將I/O分散到Google的大型叢集檔案系統Colossus;而在網路方面,位於IPU這種卸載裝置上面的虛擬網路堆疊Andromeda,對於未將路由設為Hoverboard閘道(本身是獨立軟體交換器,也是某些網路流向預設的路由器)的端點之間的通訊,可負責傳送所有的網路封包,因為Hoverboard閘道已掌握虛擬網路全部的封包轉送資訊。

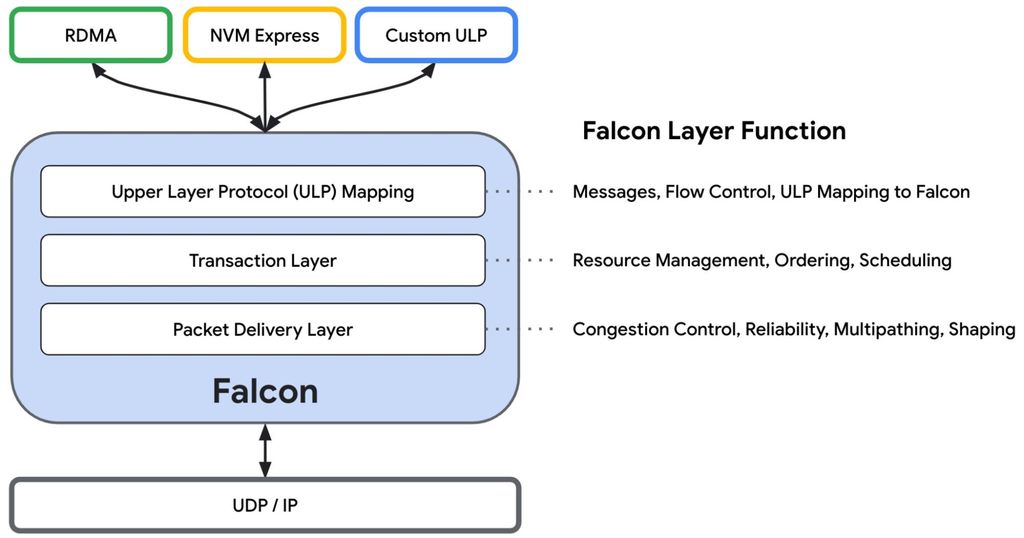

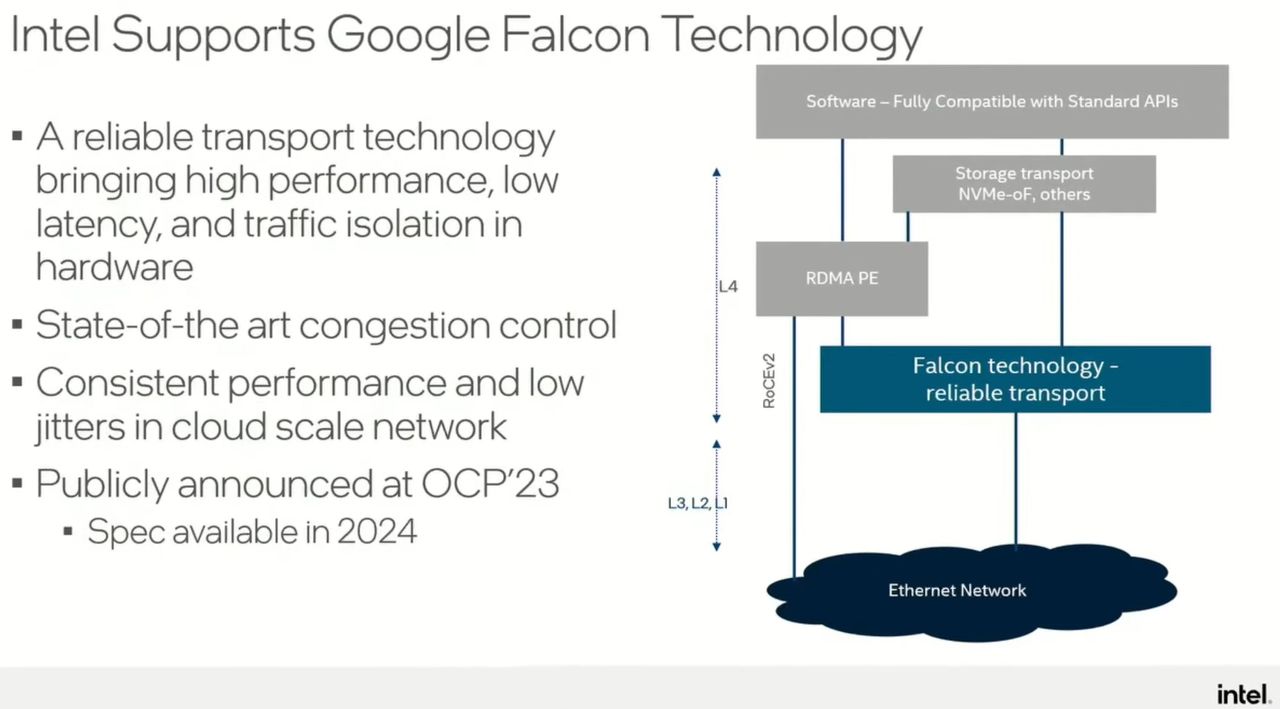

除了強化雲端服務基礎架構的效能,英特爾與Google Cloud合作發展ASIC架構IPU,也針對建置大規模AI基礎架構的交織網路環境提供解方。在2023年10月下半舉行的OCP全球高峰會,Google公開他們發展的高可靠、低延遲的硬體網路傳輸架構Falcon,並且率先用在Intel IPU E2000系列產品,並展現過去10年在效能、延遲度、流量控制等層面的進展,以及表達他們持續精進乙太網路技術的努力,使其成為可用於超大規模環境、提供高效能、低延遲的交織網路環境。

英特爾表示,這樣的搭配,可示範乙太網路傳輸也能增添低延遲與大規模的網路壅塞處理,而身為Ultra Ethernet Consortium聯盟的主要成員,他們希望將乙太網路環境提升至足以因應高效能AI工作負載的程度,並計畫將基於標準而成的各種強化機制,部署到未來的IPU與乙太網路產品。

針對網路傳輸技術持續改良,Google Cloud在2023年OCP全球高峰會,發表硬體加速技術Falcon,可配備在英特爾IPU E2000。

2024年將推出獨立IPU加速卡

除了Google Cloud陸續釋出採用Intel IPU E2000的消息,英特爾在2023年9月舉行的Innovation年度用戶大會期間,也悄悄揭露這款產品的最新效能表現與發展動向。

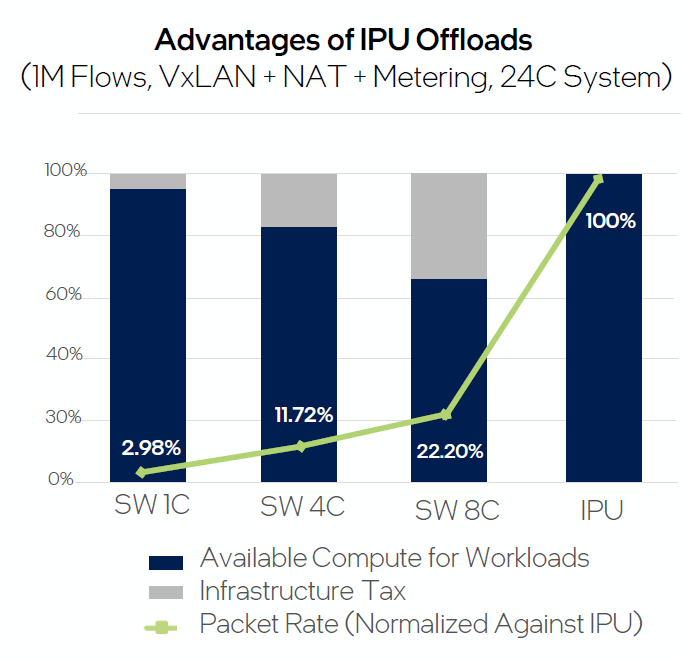

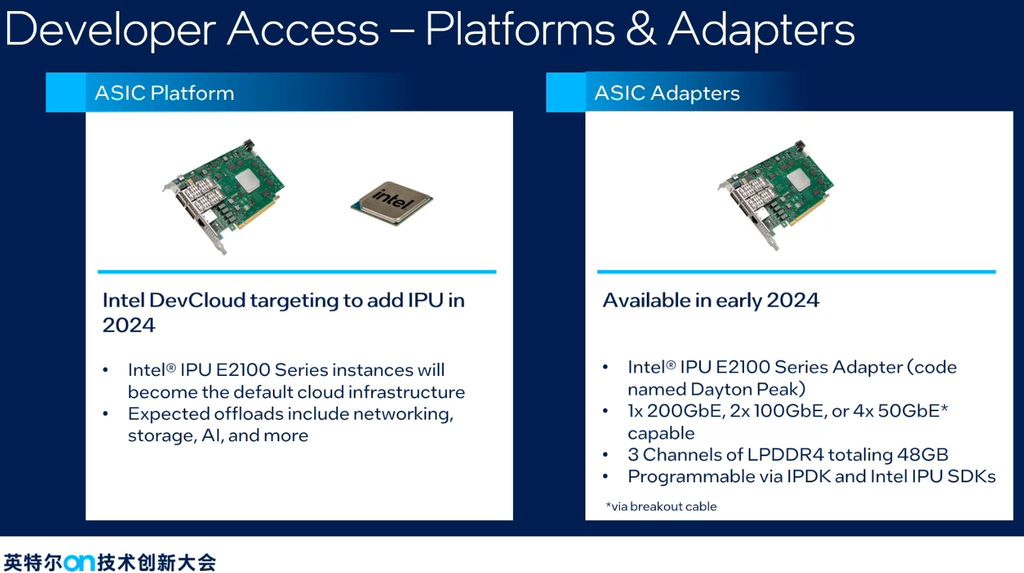

舉例來說,在英特爾彙整旗下產品效能數據的公開網站Performance Index上,特別列出Innovation大會IPU專場演講引用8月底出爐的測試結果,當中提到伺服器若是搭配IPU,實測的傳輸率為134Mpps,可用於工作負載的運算資源為100%;若是伺服器不使用IPU,用到8顆CPU核心時,網路接收到的資料量為29.75 Mpps,封包傳輸率為22%,意味著可用於工作負載的運算資源超過60%。

這裡有兩個組態值得注意,一是他們為此建置專門提供基礎架構網路功能服務的環境,當中設置VxLAN、NAT,以及網路傳輸狀態測量系統,而且搭配以P4程式語言寫成、實作VxLAN termination、NAT的軟體系統,以及結合P4-DPDK外掛的DPDK套件版本,另一是使用的IPU產品是名為IPU E2100的加速卡。

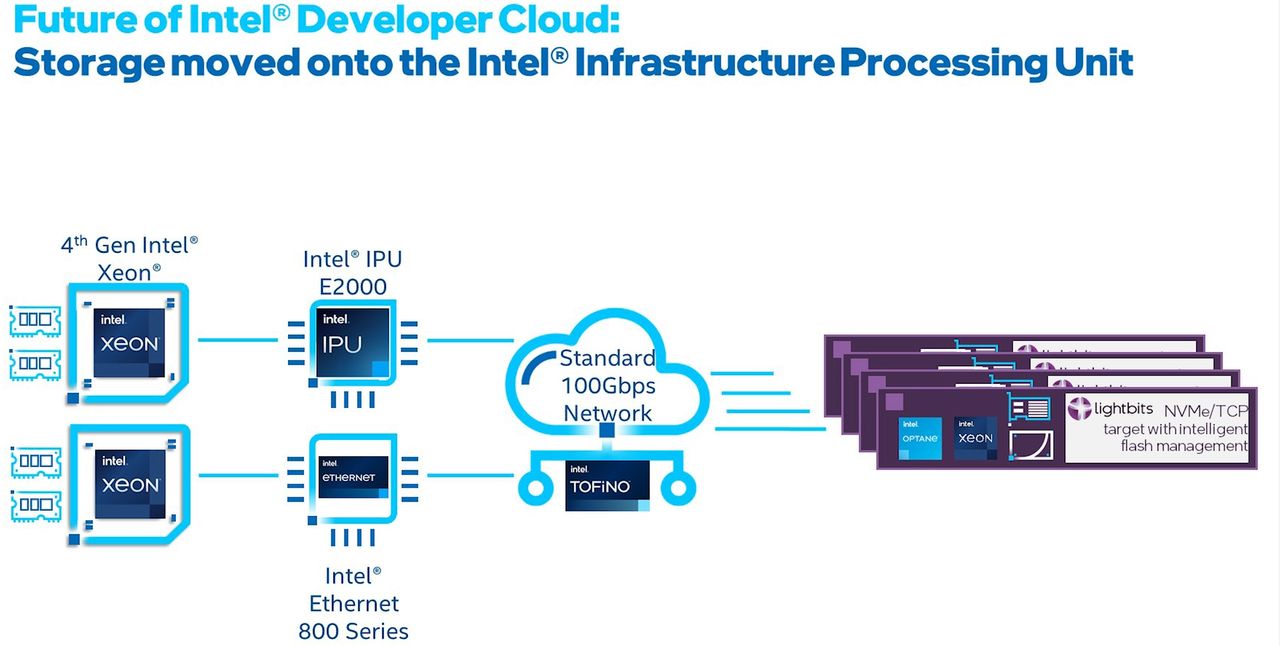

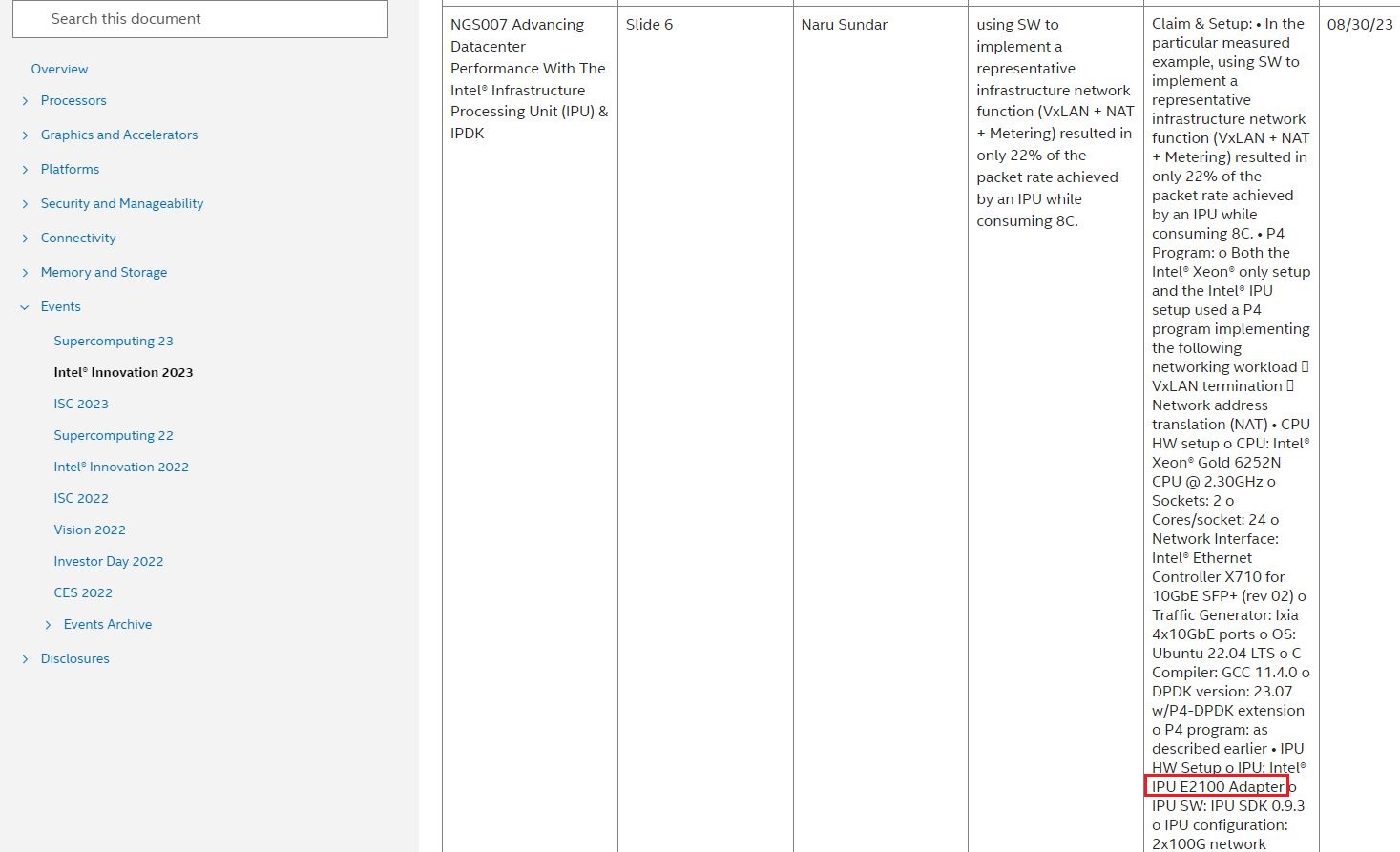

而根據我們後來向英特爾索取這場演講簡報的內容來看,2024年他們針對ASIC架構的IPU產品,會有兩種形式的提供。

一是他們營運管理的開發者雲端服務DevCloud,將會提供搭配IPU E2100的執行個體,而且會成為此服務預設的底層基礎架構;另一則是會正式推出獨立的加速卡產品IPU E2100,研發代號為Dayton Peak。而在12月19日舉行的Intel Innovation大會中國場,也重申這方面的消息。

在2024年,英特爾ASIC架構IPU即將推出介面卡形式的產品,名為IPU E2100,代號為Dayton Peak,該公司的DevCloud雲服務也將導入這款產品。

其實,Intel IPU E2100這個名字去年就已出現。我們以Intel IPU E2100作為關鍵字到網路上搜尋,發現DPDK在2022年推出的22.11版,已針對Intel IPU E210增添網路驅動程式,而針對DPU、IPU這類產品搭配的軟體開發套件IPDK,在2023年7月發布的23.07版也支援Intel IPU E2100這款產品。

針對ASIC架構IPU,英特爾幾年前已預告下一代平臺代號為Mount Morgan,根據2023年底最新公開的發展藍圖來看,目前正在開發階段,預計將提供400 Gb等級的乙太網路。

產品資訊

Intel IPU E-2000

●原廠:英特爾

●建議售價:廠商未提供

●外形:未公開規格

●晶片架構:ASIC

●網路介面:2個100GbE埠或1個200GbE埠

●I/O介面:PCIe 4.0 x16

●搭配處理器與記憶體:16顆Arm Neoverse N1核心(Armv8.2),48 GB LP-DDR4記憶體(3個通道)

●加速或卸載引擎:封包處理引擎、NVMe裝置模擬器/Optane NVMe控制器、密碼學與壓縮處理加速引擎

●支援的軟體開發套件:IPDK、DPDK、SPDK

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-06