為了防禦AI模型遭到誤導產生錯誤的判斷,研究人員需要經過不斷的模擬攻擊來確保AI模型不會受到欺騙,IBM研究團隊近日於GitHub開源了檢測模型及對抗攻擊的工具箱Adversarial Robustness Toolbox,來協助開發人員加強針對深度神經網路攻擊的防禦性,讓AI系統變得更加安全。

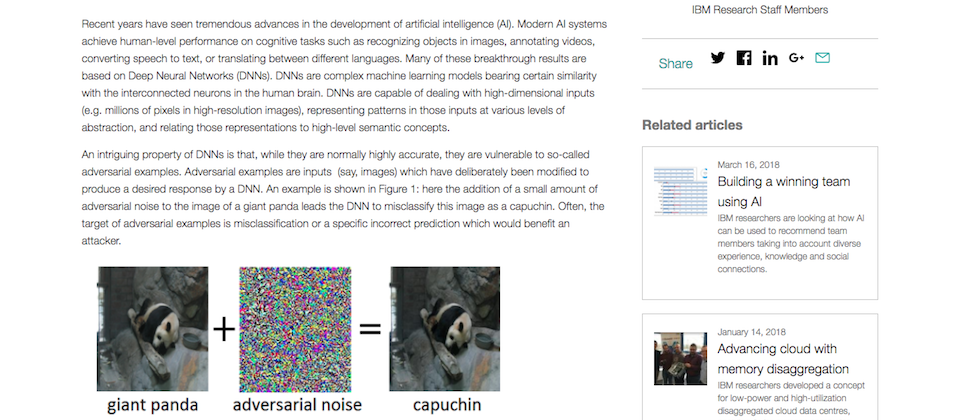

近幾年AI在許多認知任務上都有所突破,生活中許多任務也都開始加入AI技術,像是辨識圖像和影片中的物體、語音轉文字、機器翻譯等,不過,深度學習網路若受到設計過的干擾訊號影響,很容易產生錯誤的判斷,而這類型的干擾是人類難以察覺的,有心人可能會利用這樣的弱點,誤導AI模型的判斷,用於不當的意圖。

Adversarial Robustness工具箱目前主要提供增強電腦視覺辨識的防禦性,提供開發人員開發出新型防禦技術,並在實際部署AI模型時也能防禦惡意的誤導攻擊,該工具箱是用Python撰寫而成,因為Python為建立、測試和部署深度神經網路最常用的語言,包含了對抗和防禦攻擊的方法。

首先,開發人員可以用該工具箱檢測深度神經網路的穩固性,主要記錄了模型對不同干擾的輸出結果,再透過攻擊的資料集來強化AI模型,最後標註攻擊模式和訊號,防止模型因干擾訊號,產生錯誤結果。

Adversarial Robustness工具箱目前支援TensorFlow和Keras,未來預計會支援更多框架,像是PyTorch或MXNet,現階段主要是提供圖像辨識的防禦,未來將會增加更多領域的版本,像是語音辨識、文字辨識或和時間序列等。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10