為確保使用者資料在傳輸過程未被更改,Google、推特以及Apache Hadoop開源社群合作,為Apache Hadoop加入跨異構檔案系統的端到端資料驗證功能,能用於像是HDFS以及Google Cloud Storage間資料傳輸的校驗。

Google提到,在不同儲存系統間移動或是複製資料的時候,最好執行驗證以確保資料安全,雖然現在有不少機制在保護點到點傳輸資料的完整性,但是執行端到端的資料完整性驗證,則可以為典型傳輸機制增加額外的保護。當然這也可以幫忙檢測因為網路雜訊,或是伺服器以及路徑上的路由器因記憶體錯誤造成的資料毀損。

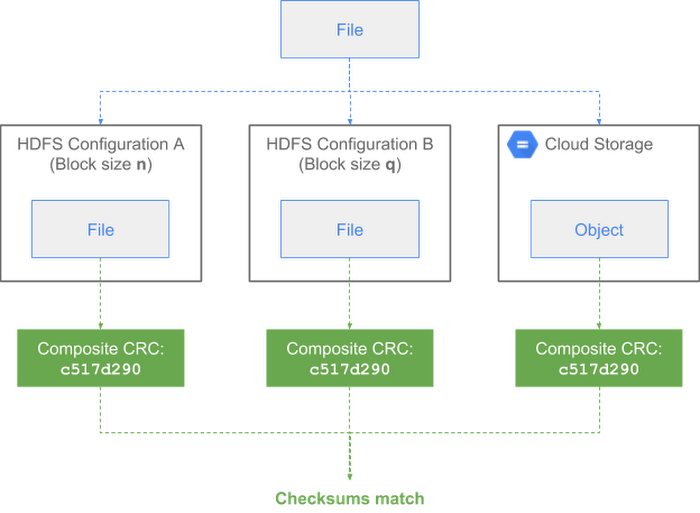

Google、推特以及Apache Hadoop開源社群三方合作,創建了新的校驗碼類型,能將複合模塊(Block)CRC以及複合檔案CRC,定義為跨儲存區塊(Chunk)CRC的數學組合CRC。這取代了使用元件CRC的MD5,以計算代表整個模塊或是檔案的單一CRC,而且與區塊CRC較低等級的精細度無關。

Apache Hadoop從3.1.1版本開始提供新的CRC校驗功能,同時也會在2.7、2.8以及2.9版本向後移植,不過使用者還必須要再等等。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06

Advertisement