Google Cloud

Google宣布釋出Explainable AI,來提高人工智慧的可解釋性,讓開發人員可以了解機器學習模型獲得預測結果的原因。Explainable AI提供了工具以及框架,供用戶部署可解釋以及包容性機器學習模型,目前這項功能已經在AutoML表格和Cloud AI平臺提供,用戶還可結合模型分析工具What-If工具更全面了解模型行為。

機器學習可用來辨識大量資料點之間的複雜關聯,儘管以這樣的方式,開發者可以讓人工智慧模型達到極高的精確度,但是當開發者檢視模型結構或是權重的時候,通常無法了解有關於模型行為的資訊,Google提到,也因爲如此,對於部分需要有高度確定性要求的產業,在學習模型無法被解釋之前,難以實際應用人工智慧機器技術。

因此Google現在宣布在雲端人工智慧服務,推出人工智慧可解釋性功能,該功能會量化每個資料因素對於機器學習模型輸出的貢獻,讓用戶能夠利用這些訊息,進一步改進模型,或是與模型的使用者共享有用的分析資訊。

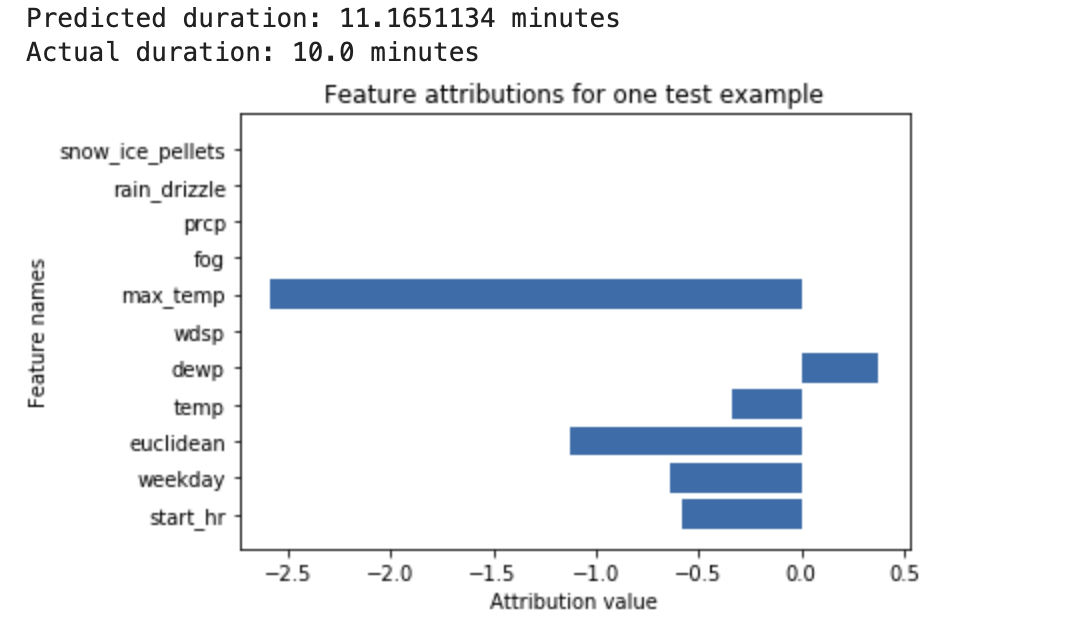

Google在人工智慧平臺加入了特徵貢獻(Feature Attribution)功能,讓開發者能夠理解用於分類(Classification)以及回歸(Regression)任務的模型輸出,特徵貢獻會顯示每個特徵對每個實例預測的貢獻多寡,可用於表格資料以及圖像資料。

以表格資料為例,當要以天氣資料和過去騎乘腳踏車資料訓練深度神經網路,當用戶要求模型預測在特定天氣騎士騎車分鐘數,則模型輸出預估自行車騎乘的持續時間,當用戶要求解釋預測結果,用戶除了會得到預測的騎車時間,還會得到每個特徵的貢獻分數(下圖),貢獻分數顯示各因素對於預測值變化的影響程度。

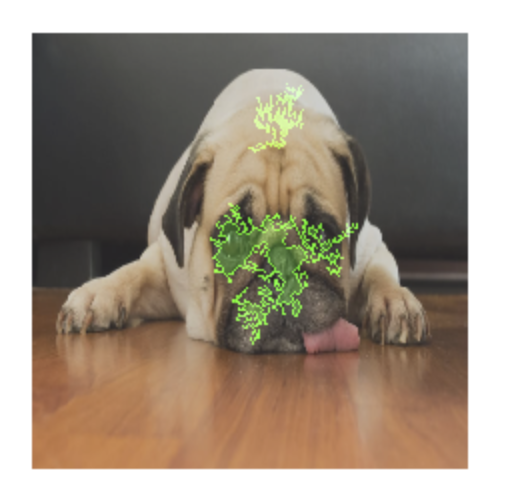

在訓練圖像方面,當開發者要訓練一個能判斷圖像內動物是貓還是狗的模型,在用戶要求解釋時,用戶會取得一個疊加的圖層(下圖),上面會顯示哪些畫素對於預測結果貢獻最大。只要用戶要求人工智慧平臺做出解釋請求時,系統便會解釋資料中每個特徵貢獻影響結果的組成,開發者可以使用這個訊息,來驗證模型是否符合預期,並辨識出模型的偏差,獲得改進模型和訓練資料的想法。

不過,Google也提到,目前所有的解釋方法都有其限制,Explainable AI能夠反映出模型從資料找出模式的方法,但是卻無法揭露資料樣本、總體和應用程式之間的基礎關係,目前Google會以維持其限制性透明的前提,提供直覺有用的解釋方法。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09