Google發布了Fairness Indicators工具,可針對二元和多類別分類(Classification)進行運算與視覺化,幫助機器學習開發團隊,評估與修正模型所存在的偏差。

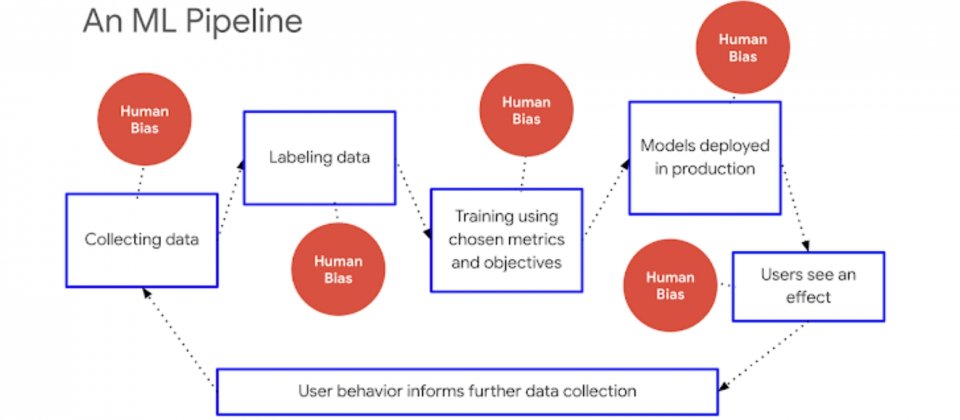

產業界與學術界大量地使用機器學習技術解決問題,但是機器學習演算法和資料集,可能同時反映且強化了偏差。Google提到,偏差有可能出現在機器學習工作管線的任何部分,從資料集到模型的表示,甚至是將結果呈現給終端使用者的方式都不例外。

而為了檢測機器學習存在的偏差,針對單一用戶或是用戶群的評估非常重要,Google強調,因為總體指標可以掩蓋某些群組不良的狀況,這些群組包括敏感的特徵群體,像是種族、性別、國籍、收入、性傾向、能力和宗教信仰。

Google的人工智慧原則其中一項,是要避免造成或是加強不公平的偏見,他們也持續在這領域耕耘,現在並於TensorFlow World大會發布了Fairness Indicators工具。Fairness Indicators可運算並視覺化像是誤報率等常用的分類模型公平性指標,還能計算信賴區間,以多個閾值進行評估。在使用者介面上,使用者可以切換基準群組並調查不同指標的效能,也可為自己的使用案例,增加自定義的視覺化指標。

.png)

Fairness Indicators可以用來產生透明性報告指標,以幫助開發人員更負責地調校模型,Google表示,公平性的顧慮與評估會因為案例而不同,因此Fairness Indicators工具還包含了一個互動式研究案例,提供Jigsaw毒性資料產生的意外偏差,說明使用Fairness Indicators檢測和修補機器學習模型偏差的方法。

Google提到,光靠指標與測量並無法讓機器學習模型實現完全的公平,這些方法僅是辨識與解決偏差的其中一環。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06