清大資工系副教授吳尚鴻指出,團隊開發的廣告文案生成AI,雖然無法產生解析度非常高的產品圖片,但能提供多元的產品廣告圖,改善GAN模型的Mode collapse問題。

攝影/王若樸

清華大學昨(8日)展示AI廣告生成技術,首先是清大資工系副教授吳尚鴻和通訊工程研究所講座教授張正尚帶領的團隊,設計一款條件式生成對抗網路(Conditional GAN)應用程式,只要輸入廣告商品和投放的目標情境(Context),就能快速產生多種廣告文案初稿,比如產品在不同場景的圖片,或是結合社群網路分析,根據使用者喜好來產生App的畫面配置。再來是清大電機系副教授劉奕汶團隊,展示了自行開發的歌曲合成技術,只要有歌詞和旋律,就能透過遞迴歸神經網路RNN來產生不同人聲的廣告歌曲,未來可望用於電臺、音樂頻道,播放風格相似的廣告歌曲。

AI廣告文案工具自動產生多元初稿,省時又省力

這款AI廣告文案生成工具,雖然無法產生解析度特別高的影像,但它的特別之處,在於能夠產出多樣性、符合實際條件的文案初稿,「貼近廣告產業需求。」吳尚鴻解釋,目前GAN研究普遍遇到的問題,就是如何突破Mode Collapse瓶頸,也就是要避免生成器(Generator)產生的內容,與輸入的資料太過相似,缺乏多樣性。進一步來說,GAN模型一邊訓練時,就會一邊產生資料,但吳尚鴻表示,GAN可能會在訓練前期,生成特定特徵的資料,然後跳過某些特徵,在後半期又生成特定特徵的資料,造成多樣性分布不均。

吳尚鴻團隊利用一套評估方法,來避免這個問題,也就是將生成器前期與後期產生的內容,映射到一個分布(Distribution)上,再利用分布上的亂度(Entrophy),來衡量輸出值的多樣性,再評估是否需要調整,以此把關多樣性。

在實際操作上,使用者只需要輸入產品圖片和目標情境,AI系統就能產出不同情境的產品圖。比如,使用者輸入床組照片後,只要將床組產品框出來,系統就會根據這個特定的產品特徵,以及目標情境,來產生不同房間和擺設的產品文案初稿(如下圖),供使用者調整。

另一個例子,則是產生模特兒廣告圖,比如使用者輸入基努李維的照片,再框出希望保留的特徵,像是額頭、眼睛等,系統就會根據這些特徵,產生不同外貌、但擁有相似特徵的人型模特兒圖片。吳尚鴻強調,這些框選的動作,有如給GAN一個指令,產生符合實際需求、而非天馬行空的圖片。

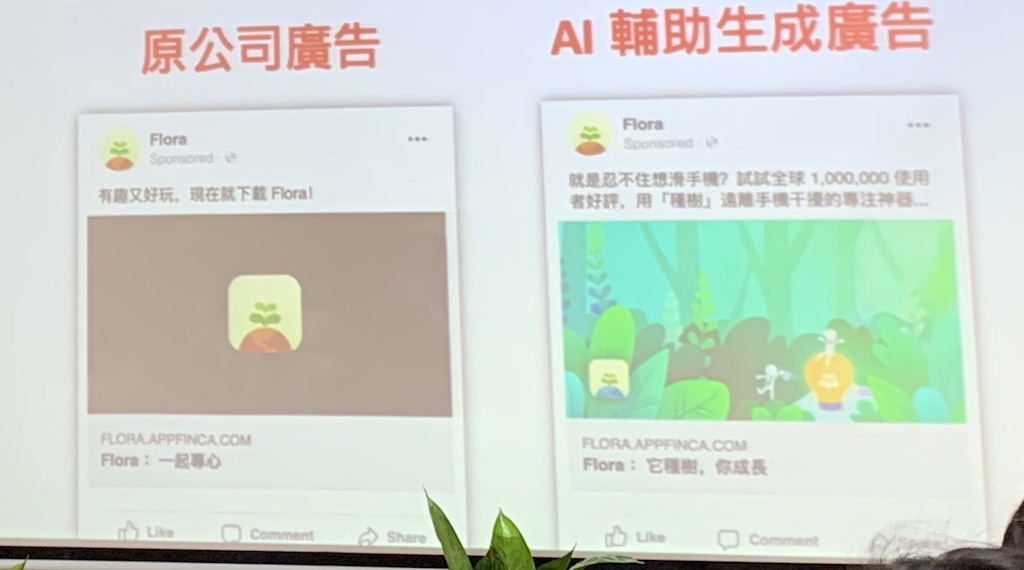

此外,這項技術還可應用於App Store的廣告設計。比如,團隊替美國一家業者的應用程式Flora,重新設計頁面配置。Flora是一款生產力工具類型的App,目標是要使用者少用手機。而Flora原本的廣告頁面,是以黑色為主,標題則是「一起專心」。

為找出改善方向,團隊首先分析使用者行為,比如使用者對Flora的描述,常出現「種樹」兩字,於是將這個特點新增至廣告標語。此外,團隊也發現,使用者在App Store上瀏覽完Flora後,接下來瀏覽的App,配色則以淺色為主。根據這些元素,系統產生以淺色為主、更生動的廣告標題初稿(如下圖),再經由人為調整。如此一來,Flora在去年Apple App Store臺灣區生產力工具排行榜,一度打敗Gmail、躍升第一名,在英國區則是第六名。

80小時歌曲訓練AI,不只能唱出逼真的流行歌,還可客製修改

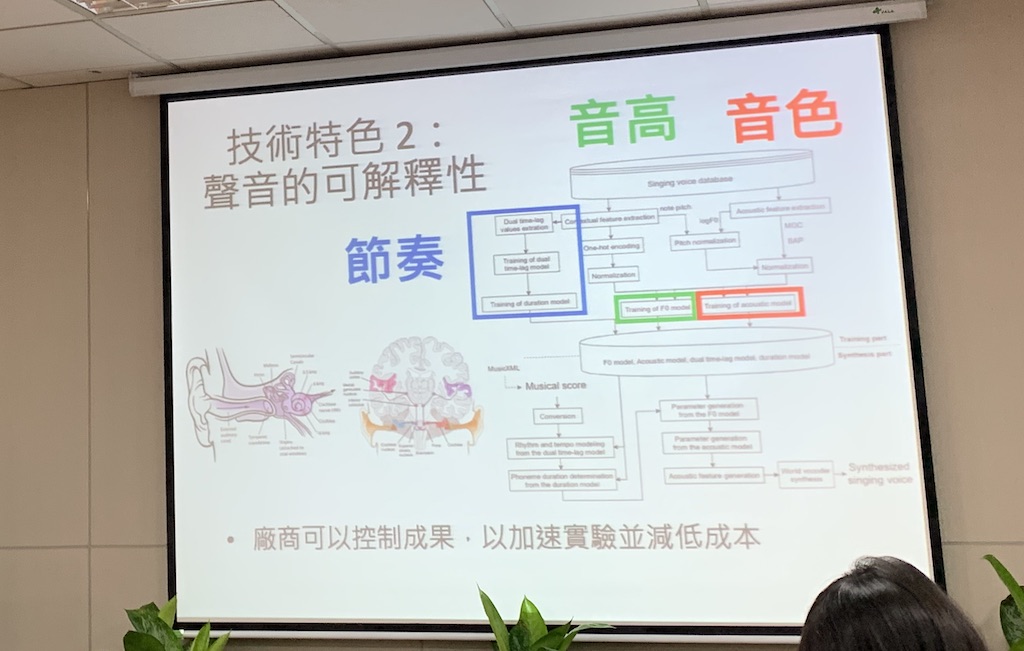

劉奕汶指出,團隊研發的歌曲生成技術,以RNN為主,收集了600小時的歌曲作為訓練資料,可根據商品歌詞和旋律,來產生不同的廣告歌曲,給使用者參考、修改。劉奕汶強調,雖然團隊的技術,沒辦法像DeepMind的語音生成模型WaveNet一樣,產生高品質的音檔,但團隊開發的歌曲生成程式,可讓使用者調整音高、音色、節奏等,「減少嘗試錯誤,」加速創作流程。(如下圖)

現場,劉奕汶團隊也播放了以馬德里不思議這首旋律為為主的AI廣告歌曲,大致上與真人歌聲相差無幾。劉奕汶指出,這首曲子是利用學生翻唱的歌曲作為訓練資料,利用其中約80小時、已標註的歌曲訓練而成。他也坦言,這套廣告歌曲生成AI,目前還無法模擬真人唱歌時的換氣、跟拍等細節,這也是團隊目前正在克服的難關。未來,團隊希望將這項技術,應用於電臺、音樂頻道等,根據頻道播放的音樂性質,來產生風格相似的歌曲,提高使用者體驗。

而清大這兩項AI廣告生成技術的論文,也發表於多個國際知名的學術會議上,比如NeurIPS、IEEE ICASSP、ICML等。接下來,團隊除了要提高生成內容的流暢度和解析度,也瞄準業界需求,與國內大型企業如聯電、KKBOX和華碩等洽談。文◎王若樸

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09