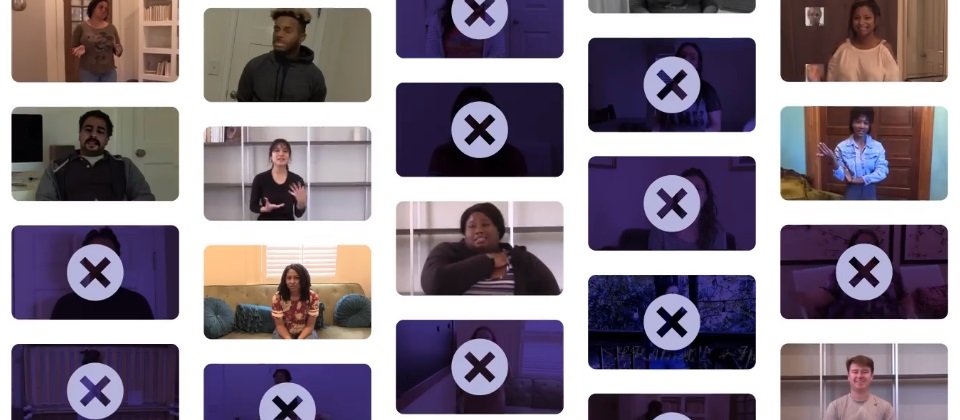

Deepfake影片辨識示意圖,圖片來源/臉書

臉書上周五(6/12)日公布Deepfake影片辨識技術創新大賽成果,顯示雖然參賽模型的辨識技術準確度還不錯,但用在全自動化人臉辨識作業則仍有待努力。

由於AI技術演進日新月異,各界擔心AI製造出的Deepfake影片煽動種族仇恨或打擊政敵。去年9月間臉書、微軟發起Deepfake 影片辨識技術挑戰賽(Deepfakes Detection Challenge)以期能號召天下好手一起來貢獻、改進辨識出這類AI假影片的演算法。

為了這個大賽,臉書聘請了超過3,500名演員,花了一個多月時間錄製一段談話影片,其中一部份影片以AI移花接木,接上別的演員的臉來造假,此外還集結網路上合法取得、總數超過10萬則影片。這些真、假混合的影片作為訓練和測試參賽模型的資料集。但參賽者的模型還必須拿來偵測10萬則「black box」資料集,即他們之前完全沒有接觸過的影片,目的是評估模型真槍實彈的辨識能力。公開和black box資料集各會根據測試產出排名。

活動從12月開始,一共吸引了2,114名參賽者上傳超過3.5萬個模型。評審團隊則集結臉書、微軟、康乃爾、牛津、馬里蘭、加州大學柏克萊分校、紐約市立大學阿巴尼分校、麻省理工學院、慕尼黑科技大學及拿坡里費德里克二世大學(University of Naples Federico II)的專家。

臉書指出,在公開資料集的測試結果方面,表現最好、由白俄羅斯機器學習專家Selim Seferbekov上傳的模型達到82.56%的平均精準度,平均精準度是電腦視覺任務的衡量指標。但如果用來測試「black box」資料集時,平均精準度就只剩下65.18%,落到第4名。但另一方面,在black box資料測試組排2到5名的模型,在公開資料組排名卻也很低(分別為37、6、10、17名)。大會同時表示,65.18%也成為AI測試的基準線。

臉書指出,deepfake偵測一直有個尚未解決的問題,即用已知資料訓練而成的模型難以推論到未知資料上。而在本次比賽中,已知、未知資料集成績不一致的結果,再次反映偵測模型難以推論的難題,也是未來必須再努力的地方。

而主辦單位也從最好的模型作品中歸納出三大特點。第一是許多使用了很聰明的資料增強(augmentation)法,如隨機或使用地標、注意力(attention)網路去除部份臉部特徵,另一些人則使用更複雜的混合式增強或WS-DAN(Weakly Supervised Data Augmentation Network)模型,顯示大家偏好以細膩的視覺分類法來判斷臉部改造的痕跡。第二是所有優勝模型都使用預先訓練的EfficientNet網路為基礎,大部份使用EfficientNet的B7變型,顯示廣受歡迎的整合學習(ensemble learning)式模型,也適合用在deepfake影片辨識上。最後,優勝隊伍沒有一個使用數位鑑識技術,如分析影像製作過程產生的感測器噪音指紋或其他特徵,顯示影片像素層次上使用未學習過的分析技術,不是不好用,就是還不普及。

臉書也會在本周的電腦視覺與樣式辨識(Computer Vision and Pattern Recognition,CVPR)大會上宣布,將原始資料集全部開放給更多研究人員,以促進偵測技術的進展。

熱門新聞

2026-02-09

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09