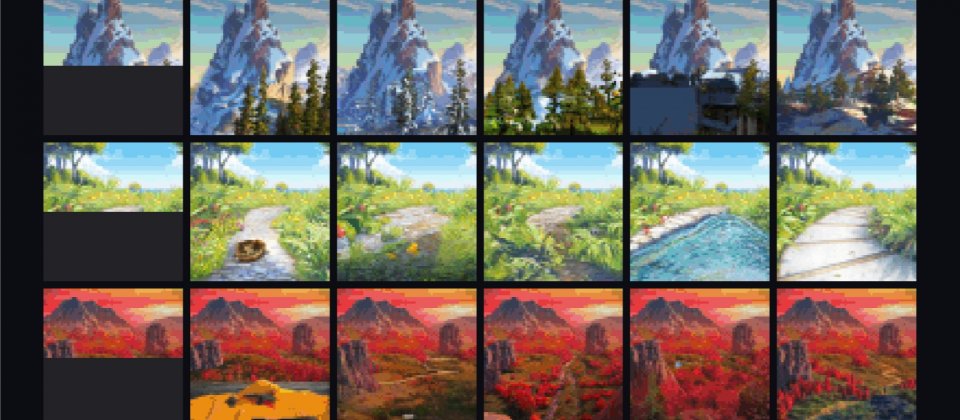

左一圖片為研究人員提供的半張圖片範例,剩下的部分則由模型預測完成

OpenAI研究人員運用人工智慧語言模型來生成圖片,他們以像素序列來訓練GPT-2語言模型,使語言模型能夠生成連續相關的圖像,研究人員提到,這項研究縮小了電腦視覺和語言理解技術間的差距,不過,因為訓練過程需要耗費大量的運算資源,且相關的演算法效能也不斷進步,影響了這項研究實際用於圖像生成的價值。

近期非監督式和自我監督學習技術,在語言處理上,都獲得極佳的成果,像是BERT、GPT-2、RoBERTa和T5等模型,在廣泛的語言任務上,都有出色的效能表現,不過,目前這些模型的應用都僅限於語言處理,在圖像分類上都還未有亮眼的成果。

研究人員提到,這些模型之所以在各種語言任務表現良好,其中一個重要原因,便是語言任務的實例,通常自然地出現在文字中,像是問題之後通常接著答案,或是有助於回答問題的文字,段落後通常會是摘要,或是有助於總結的文字,而相反地,像素序列中並不會明確包含所屬圖像的標籤。

而BERT和GPT-2這類的Transformer模型,都是無關領域的,也就是說,這些模型可以應用在任何形式的一維序列上,研究人員表示,近期也有相關的研究,證明規模足夠大的Transformer,在接受像素預測訓練,最終也可以生成可辨認的物體樣本。OpenAI研究人員在以長像素序列訓練GPT-2或稱為iGPT的模型,發現該模型似乎能夠理解二維圖像特徵,像是物體的外觀和類別,在沒有人工標籤的指引下,生成相關的圖像。

生成序列建模是一種非監督式學習演算法,由於所有資料類型都能以位元序列形式表達,因此可以直接將各種資料類型用在Transformer中,且不需要經過額外的處理工程。OpenAI研究人員便將用來訓練自然語言的GPT-2基礎架構,直接用於圖像生成上,以測試這種通用性。

不過,這需要經過大量的運算,才能在非監督的情況下,展現出良好地成果,研究人員分別以ImageNet,訓練了包含7,600萬、4億550萬與14億個參數的三個Transformer,模型分別為iGPT-S、iGPT-M以及iGPT-LM,並且還以ImageNet結合網路上的圖像,訓練了具68億參數的iGPT-XL。

由於長序列建模的計算成本非常大,因此研究人員以32x32、48x48和64x64低解析度進行訓練,雖然他們試圖使用更低的解析度,但研究顯示,在這些解析度以下,效能將會大幅降低。研究人員還創建了特殊的調色盤,不只能忠實的呈現顏色,而且序列長度能比標準的RGB調色盤短3倍。

研究顯示,圖像特徵品質會隨深度急劇增加,但在之後又會些微下降,研究人員表示,這可能是因為Transformer模型分兩階段執行而導致,在第一階段時,模型從周圍的上下文收集資訊,以建構基於上下文的圖像特徵,而在第二階段,模型會基於上下文的圖像特徵,來預測圖像中的下一個畫素。

研究人員提到,增加模型的規模和訓練的迭代次數,可以提高圖像品質,使用基準CIFAR-10、CIFAR-100和STL-10對結果進行評估,這些模型的表現比現存的所有監督式和非監督式演算法還要好。不過,這個方法仍有其限制,iGPT模型只能處理低解析度的圖像,而且會因為訓練資料而產生偏差,像是建立性別和角色關聯,產生男性科學家這樣的結果,另外,iGPT模型訓練需要非常大量的時間,使用一張Nvidia V100顯示卡來訓練iGPT-L,大約需要2,500天。

這項研究的主要目的,還是在於進行概念性驗證,研究人員表示,由於需要耗費大量的運算資源,而且現有方法的準確度也不斷進步,都是這項研究不會被實際用於電腦視覺應用中的原因,但是因為這種方法簡單且通用,在具有足夠運算能力的前提下,或許能改進其他領域學習特徵的效能。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09