Google周四(2/15)發表了最新的Gemini 1.5模型,它最多可支援長達100萬個Token的脈絡,意謂著它得以一次處理大量資訊,例如1小時的影片,11小時的音訊,超過3萬行的程式碼,或是超過70萬字的內容。最先採用Gemini 1.5模型的產品為Gemini 1.5 Pro,這是Google所推出的中型多模態模型,其標準脈絡長度為12.8萬個Token,但Google允許少數的開發者與企業客戶可透過AI Studio及Vertex AI預覽其100萬個Token的能力。

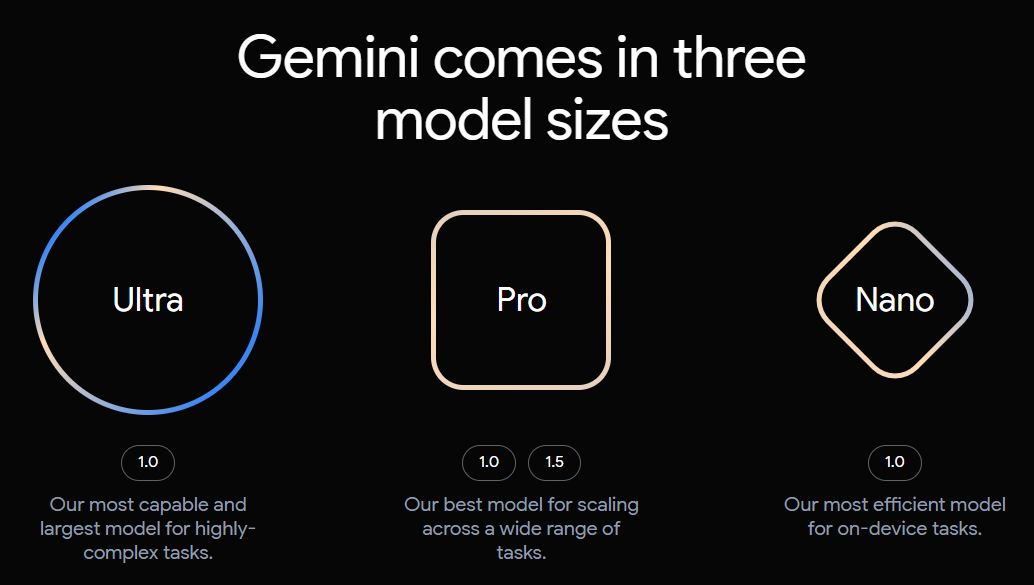

Google Gemini是Google用來挑戰OpenAI GPT的作品,不過,它是個多模態模型,可同時支援文字、圖片及聲音的輸入。Google將Gemini規畫成3種版本,分別是可於手機上運作的Gemini Nano、通用版的Gemini Pro,以及最強大的Gemini Ultra。目前Gemini Nano已被應用在Google Pixel 8及三星Galaxy S24系列手機上,並已開放開發者與企業測試Gemini Pro。

而Google在去年3月發表的AI聊天機器人Bard最初使用的是LaMDA模型,之後改用PaLM模型,再於去年12月升級至Gemini Pro模型,因而在日前直接將Google Bard更名為Gemini,並推出基於Gemini Ultra 1.0的付費機器人服務,而這也是Gemini Ultra 1.0的首個商品化應用。

在Google正努力推動Gemini 1.0之際,還不忘發表最新的Gemini 1.5,緊湊的時程顯現了Google在AI領域積極追趕的強烈企圖。

根據Google的說法,Gemini 1.5提供了明顯強化的表現,它奠基於Google基礎模型開發與架構的每一個研究及工程創新之上,以及方法的改變,包括採用新的專家混合(Mixture-of-Experts,MoE)架構,而讓Gemini 1.5的訓練與服務更有效率。Gemini 1.5主要採用Transformer與MoE架構,前者為一大型神經網路,後者則由眾多小型的專家神經網路所組成。

Google解釋,MoE模型可根據使用者所輸入的類型,選擇性地於其神經網路上啟動最相關的專家路徑,以大幅提高模型的效能。

首個基於Gemini 1.5早期測試版為中型的多模態模型Gemini 1.5 Pro,其效能類似於Gemini Ultra 1.0大型模型,並使用更少的運算。它具備標準的12.8萬個Token的脈絡,同時允許少數的開發者與企業客戶透過AI Studio和Vertex AI於預覽版中測試100萬個Token的脈絡。

支援100萬個Token的脈絡代表Gemini 1.5 Pro能夠無縫分析、分類及整理大量內容,例如當提供了阿波羅11號登月任務的402頁紀錄時,它能夠理解、識別與判斷文件中的對話、事件與細節;若是提供一部44分鐘的Buster Keaton無聲電影時,Gemini 1.5 Pro則可準確分析各種情節點與事件,並推論出電影中容易被遺漏的小細節;也能針對10萬行的程式碼給出有用的解決方案、修改或解釋。

隨著Gemini 1.5擴大對脈絡長度的支援,Google也正努力優化該模型,以改善延遲,減少運算要求,同時強化使用者體驗。根據Google的規畫,Gemini 1.5 Pro的基本版將支援12.8萬個Token,將隨著模型的改善而擴大到100萬個Token,此外,其實Google內部也已成功測試了使用1,000萬個Token的脈絡。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10