蘋果藉由於旗下macOS Sequoia、iOS 18與iPadOS 18作業系統中整合Apple Intelligence,加入了全球的人工智慧(AI)陣營,Apple Intelligence是由許多高效能生成式模型所組織,本周蘋果揭露了其中的兩個,一個是裝置上的小型語言模型,另一個是伺服器上的較大型語言模型。

其中,在裝置運作的語言模型不到30億個參數,另一個較大的語言模型則是透過Private Cloud Compute於基於蘋果晶片的伺服器上執行。蘋果利用取得授權的資料,以及透過AppleBot搜集的公開資料來訓練基礎模型,某些授權資料可用來強化特定功能,此外,蘋果亦強調不使用個人資料進行訓練,也會過濾低品質的內容。

裝置與伺服器上的模型皆使用分組查詢注意(grouped-query-attention)機制,以優化注意力機制並提高模型效率,並有共享的輸入與輸出詞彙嵌入表,以降低記憶體需求及推論成本。裝置端模型的Token數量為49K,伺服器端模型的Token數量則是100K。

蘋果藉由low-bit palletization與Low-Rank Adaptation(LoRA)微調技術,來減少裝置模型在推論時所需的資源,同時維持其準確性,也透過Talaria工具、激化量化、嵌入量化,以及關鍵值快取更新等方法來提升模型運作效率,因此,在 iPhone 15 Pro上,模型收到提示後生成第一個Token的時間只要0.6毫秒,平均每秒可生成30個Token。

在預訓練的模型上,蘋果利用微調層來迎合使用者的日常活動,將小型神經模組(微調器)插入模型中,以改善模型對特定任務的執行能力。蘋果比較了自家裝置模型+微調器、與微軟Phi-3-mini在摘錄上的能力,發現不管是在電子郵件或是通知的摘錄上,人類對蘋果模型的摘錄結果都更為滿意。

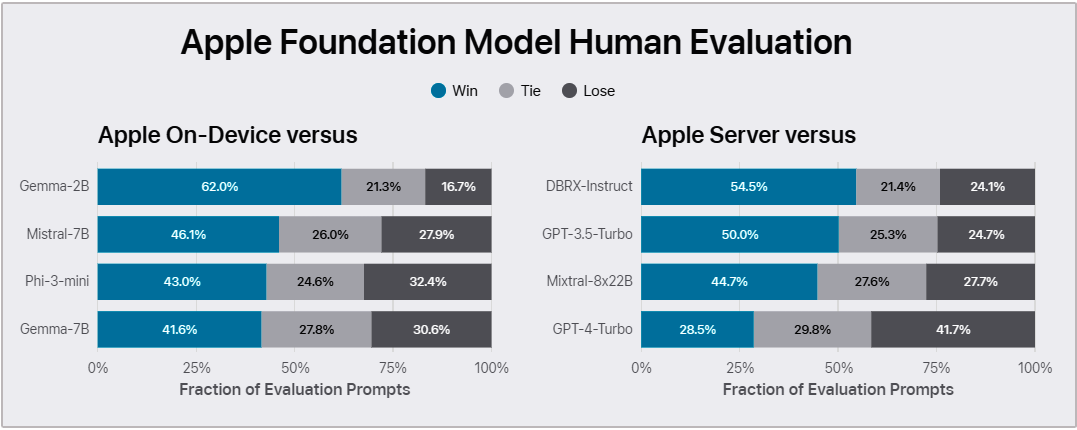

另外蘋果也比較這兩個模型與開源的Phi-3、Gemma、Mistral、DBRX及商用的GPT-3.5-Turbo及GPT-4-Turbo,顯示不管是在裝置模型或伺服器模型上,蘋果多半更受到人類評估人員的青睞,只有伺服器模型明顯落後GPT-4-Turbo。且不管是在輸出危害、安全提示、指令追蹤能力或是寫作能力上,兩個蘋果模型也都有不亞於其它競爭對手的表現。

除了這兩個分別位於裝置及伺服器上的基礎模型之外,之後蘋果亦會陸續揭露該公司所使用的其它生成式模型,包括語言、擴散與程式碼模型等。

圖片來源/蘋果

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06

.png)