攝影/王若樸

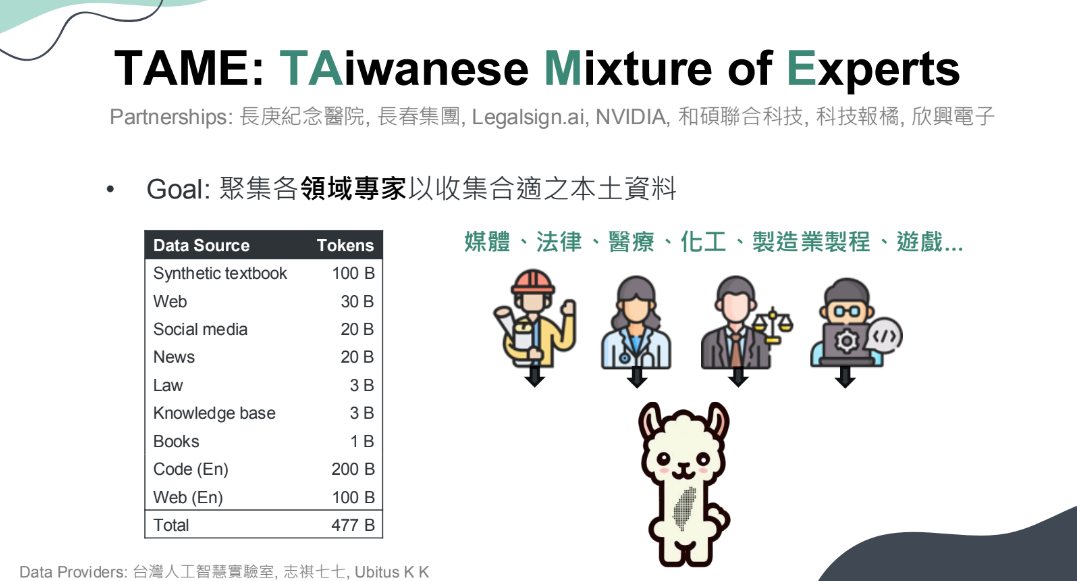

今日(7/1),長春集團、和碩聯合科技、長庚醫院、欣興電子、科技報橘和專攻法律AI的律果科技,與臺大資工系、臺大資管系就聯手揭露臺灣繁中大型語言模型(LLM)計畫TAiwan Mixture of Experts(簡稱Project TAME)成果,其同名模型以70億參數的開源模型Llama-3 70B為基礎,使用5,000億個Token和Nvidia開發者計畫技術訓練而成,具備石化、電子製造、醫療、媒體內容和法律等在地專業知識。Project TAME目前於GitHub上開源,團隊希望藉此拋磚引玉、吸引更多產業夥伴加入,來形塑臺灣產業專用AI應用生態系。

今年初發起計畫,3階段打造這款繁中LLM

早在今年1月,這些參與者就發起Project TAME,要打造繁中LLM。目前坊間雖有不少強大的LLM,如GPT系列、Claude系列、Llama系列模型等,但Project TAME主要開發者臺大資工系博士班候選人林彥廷表示,對本土企業和組織而言,仍需要表現穩定的繁中LLM才行。

於是,這些本土企業聯手臺大,要打造這個繁中優化的模型TAME。該模型經3大階段訓練而成,包括利用臺灣本土資料進行連續預訓練,再來是生成多輪AI對話資料、進行微調,最後是模型與使用者真實互動,透過使用者回饋來微調模型。

但光是第一階段,團隊就面臨2大難題:本土訓練資料來源,以及各領域專家確認資料來源與品質。為解決這個問題,他們採用聚集各領域專家、提供相關資料的模式,來因應資料不足的挑戰。而這些資料來源,包括了占所有訓練資料三分之一的合成資料(如合成教科書內容等),約1,000億Token左右,以及其他來自媒體、石化、法律、醫療、化工、製造業製程、遊戲等資料,包括來自網頁、社群平臺、資料庫、書籍、程式碼等。(如下圖)

接著,在技術部分,團隊訓練的基礎模型有兩種,包括Meta的80億參數模型Llama-3 8B和700億參數Llama-3 70B,採用Nvidia NeMo、Nvidia NeMo Megatron兩種訓練框架,以及3D平行化、DeepSpeed Zero網路通訊優化器和Flash Attention等加速方法與工具,來訓練TAME模型。在推論部分,他們採用Nvidia TensorRT-LLM框架執行,另使用Nvidia建置的Taipei-1超級電腦(搭載DGX H100)算力來驅動模型訓練與推論。

讓模型飽讀詩書、具備繁中基礎知識後,接下來就進入第二階段:監督式微調。在這階段,首先會從資料中取出提示,模型會根據提示來自我對話、生成多輪對話,最後根據這些對話資料來進行監督式微調。這些對話資料涵蓋了通用型和知識密集型資料。

完成對話微調後,再來就是最後一階段,也就是透過模型與真人互動,來根據人類回饋微調模型,確保模型產出與人類偏好一致。為此,團隊也繁中LLM競技場添加TAME,讓民眾在平臺上提問,並根據2個模型給出的回答,來評估模型表現。透過這種方式,就能進一步改善TAME模型的不足之處。

.png)

在地文化理解力、專業知識能力實測皆第一

完成3階段的訓練後,接著,團隊利用標準化測試題目,來評估Project TAME模型表現。

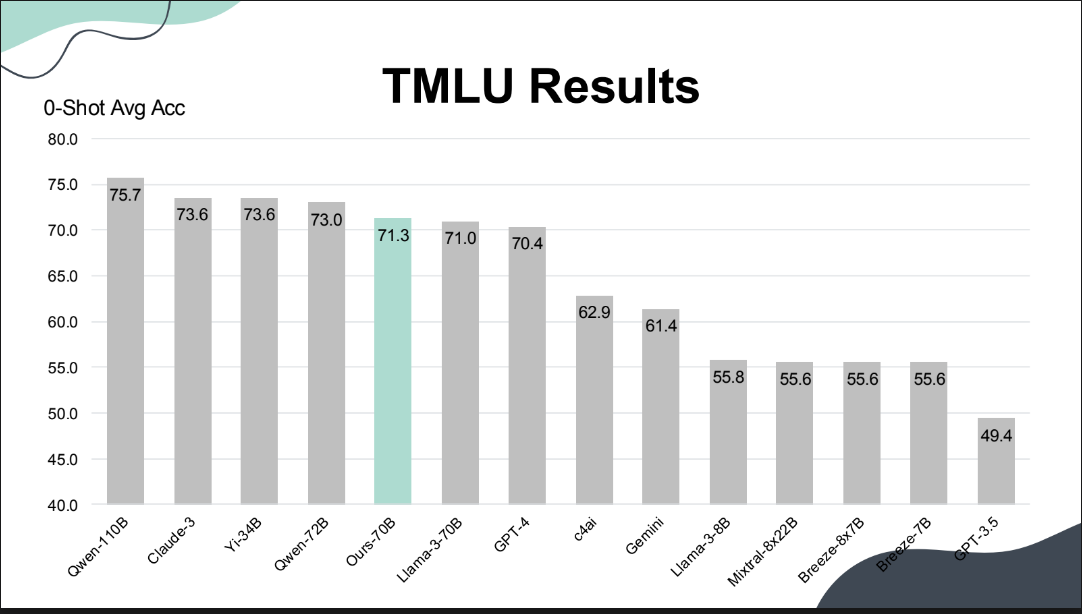

首先是包含各種本土考試科目的語義理解基準測試TMLU,不只有國高中文科、數理化等考題,還有教師資格、領隊、駕駛等考題。經測試,Project TAME的平均分數為71.3%,與Claude 3的73.6相差無幾,還勝過GPT-4、Gemini、Llama 3等模型。(如下圖)

再來,Project TAME模型還具備在地文化知識,能根據在地文化提示(如網友戲稱哪一項早餐店的產品有通腸效果)給出正確回答,正確率是所有評測模型中的最高的,達79.4。

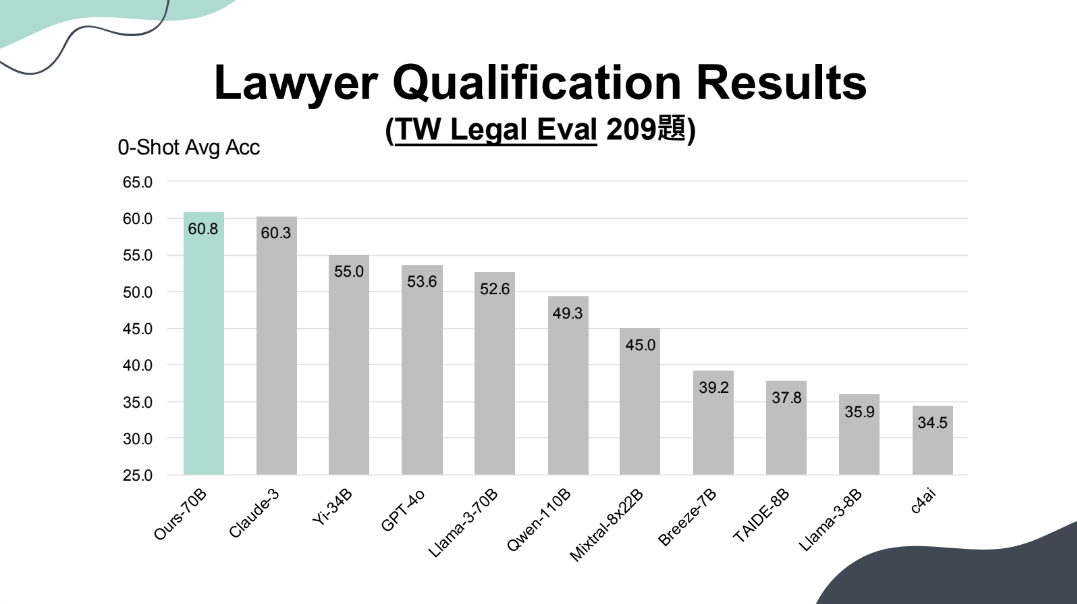

特別的是,Project TAME還在臺灣律師考試的選擇題部分拿下好成績,總共209題中拿下60.8分,一樣是所有測試模型中的最高分(如下圖),意味著TAME具備臺灣法律知識,比Claude-3(60.3)、GPT-4o(53.6)、TAIDE 8B(37.8)等模型還要厲害。

Project TAME正式對外開源,不少領域已有初步應用

目前,Project TAME已正式開源,企業可免費下載使用,民眾也能至模型聊天頁面測試。另有亞太智能機器(APMIC)整合Project TAME,提供聊天機器人測試頁供使用者測試。

林彥廷表示,為降低企業部署門檻,未來Project TAME可能朝混合專家模型(MoE)形式發展。因為,MoE由好幾個專家模型組成,可想像為各有各的擅長領域,因此相較於同參數量的傳統LLM,MoE可以其中一個或多個專家來回答問題,以較經濟的方式使用運算資源,進而降低模型推論成本。

另一方面,根據團隊說明,Project TAME 700億參數模型符合企業導入的低成本需求,估算只需1,600萬臺幣、短短3.5小時(模型迭代一次)就能利用企業內部資料訓練模型,大幅降低導入成本和時間,可優化企業在運營管理、人員訓練、產品服務、客服等AI應用。

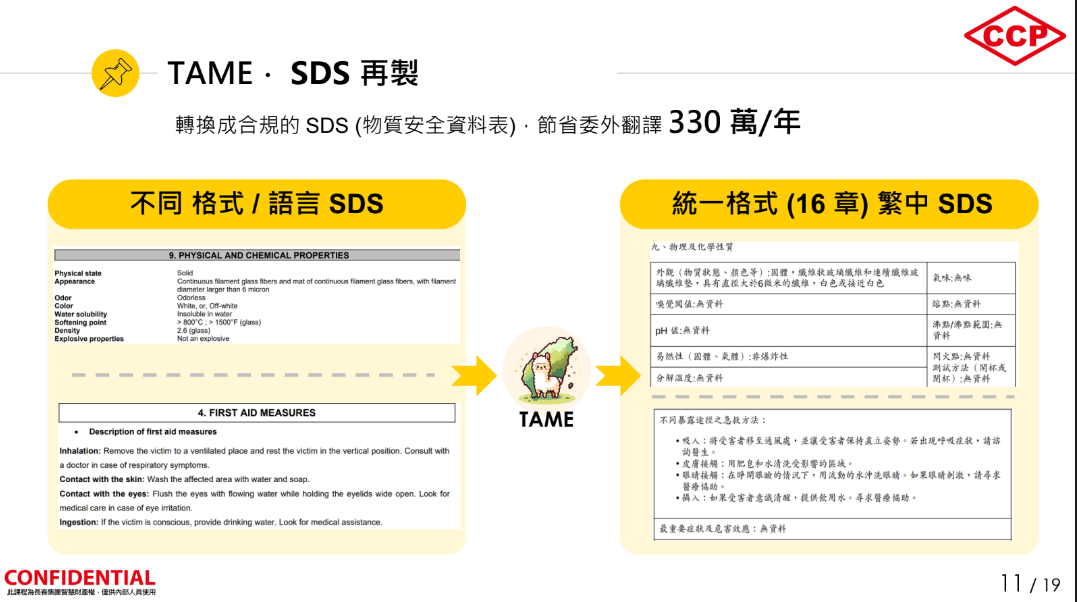

在實際應用上,則涵蓋了電子製造、石化、醫療、法律和媒體等領域。以長春集團為例,他們就應用TAME於自家助理iGenie,搭配RAG資料庫,可正確使用繁體字回答公安問題,還能將不同語言、格式的物質安全資料表(SDS),正確轉換為中文版本,預計每年可節省330萬元的委外翻譯費用。(如下圖)

此外,長春集團也將TAME用於自家Email服務,如新建摘要、內容提示等,也用於會議逐字稿與摘要生成。

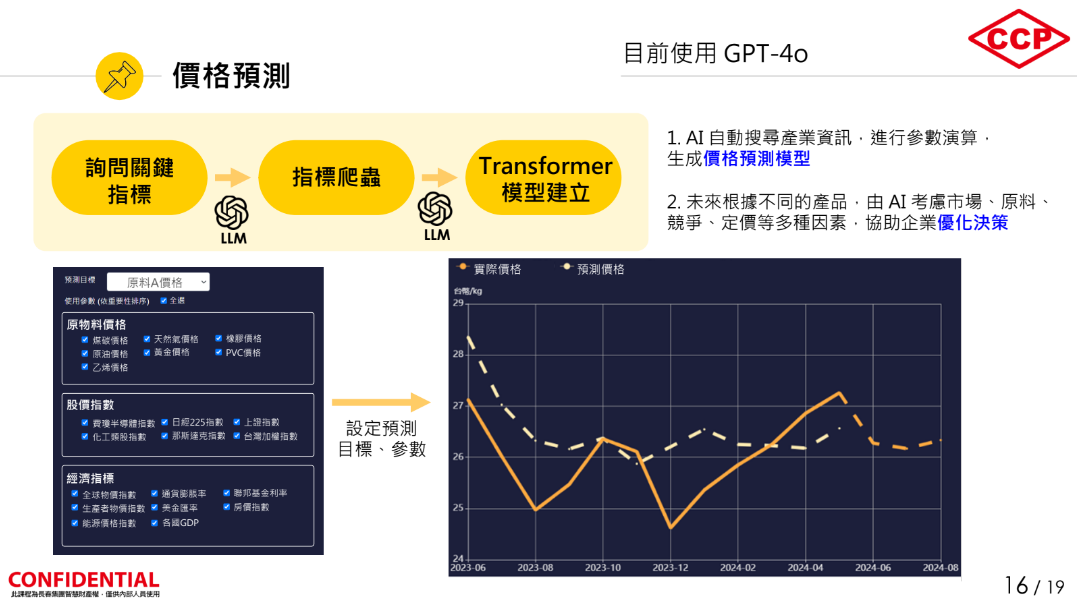

長春集團資訊中心資深協理黃至善表示,希望TAME更精進,未來可用於原物料價格預測、企業戰情中心資訊分析和機器人大腦等3大領域。進一步來說,就價格預測而言,長春集團起初以回歸或時間序列模型測試,發現效果不好。

後來ChatGPT這類LLM興起,他們開始投入研究,其做法是先向LLM(使用GPT-4o)詢問價格預測的指標,接著再詢問LLM,這些指標出現在哪些網頁、能否寫支爬蟲程式,來協助抓取指標資料。有了資料,最後再詢問LLM可用哪種模型來執行預測並寫一支預測程式,在得到LLM給出的Transformer程式後,團隊將指標資料輸入模型,得出的價格預測準確度可達7成,比過往方法有效。不過,他們也分析預測不準確之處,考慮多添加重要新聞,來強化模型表現。(如下圖)

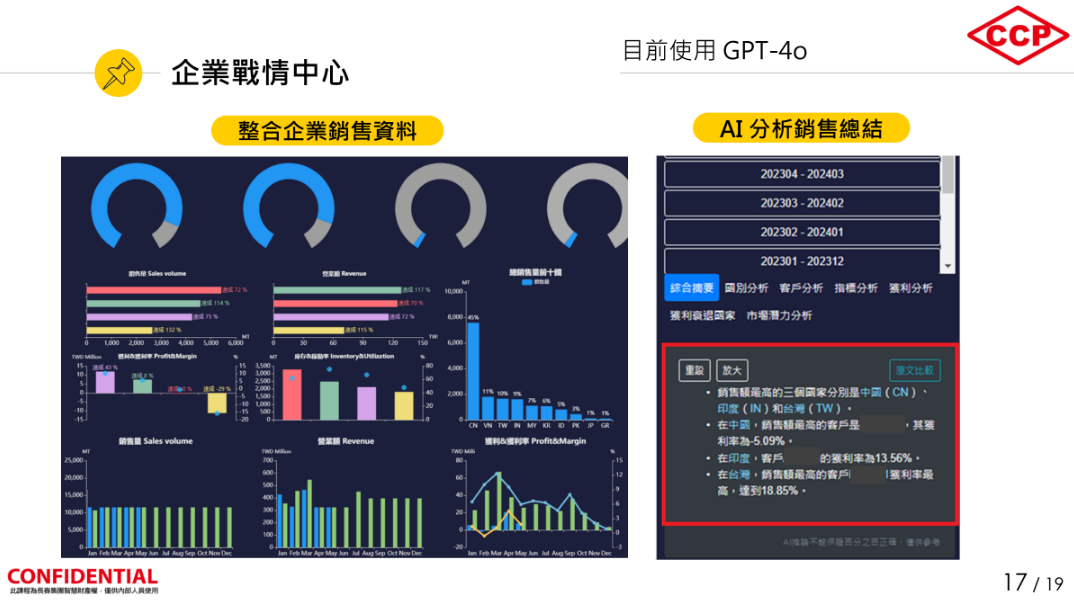

就戰情中心來說,長春集團資訊中心將過去2年、去識別化的內部銷售資料與財務資料,再加上外部的關鍵經濟指標,來讓ChatGPT分析。他們很驚訝地發現,LLM可給出人類分析師沒注意的洞見,因此可呈現在戰情中心儀表板,結合其他資訊和互動式設計,來提供另一種資訊分析服務。(如下圖)

在機器人部分,長春集團希望打造通用的實體機器人,可在石化業危險場域代替真人作業。他們也與臺大合作,以LLM作為機器人大腦,透過自然語言指令來執行任務,如巡檢、倉儲物流等,預計明年會有進一步成果。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-25

2026-02-23