想要發展技術自主程度相對較高的AI應用系統,大家一開始面臨的最大困難,往往是不知該從何處著手,從軟體開發平臺、雲端服務、硬體設備,都有許多搭配方式可選,尤其是軟體相關工具,有各式各樣的應用程式開發框架(framework)、程式庫(library)、軟體開發套件(SDK)、容器(container)、模型(model)、資料集(dataset)。

單就強調高度整合的開發環境而言,三大雲端服務業者都提供相關的工具,像是AWS的SageMaker Studio、微軟的Azure AI Studio、Google Cloud的Vertex AI Studio,有些硬體運算廠商也提供這類工具,例如,英特爾目前有OpenVINO Toolkit、oneAPI Toolkits,以及前身為cnvrg.io的Intel Tiber AI Studio,Nvidia在去年8月舉行的SIGGRAPH 2023大會發表Nvidia AI Workbench,今年3月的GTC 2024大會正式推出,到了6月,他們釋出囊括這套工具的Nvidia RTX AI Toolkit。

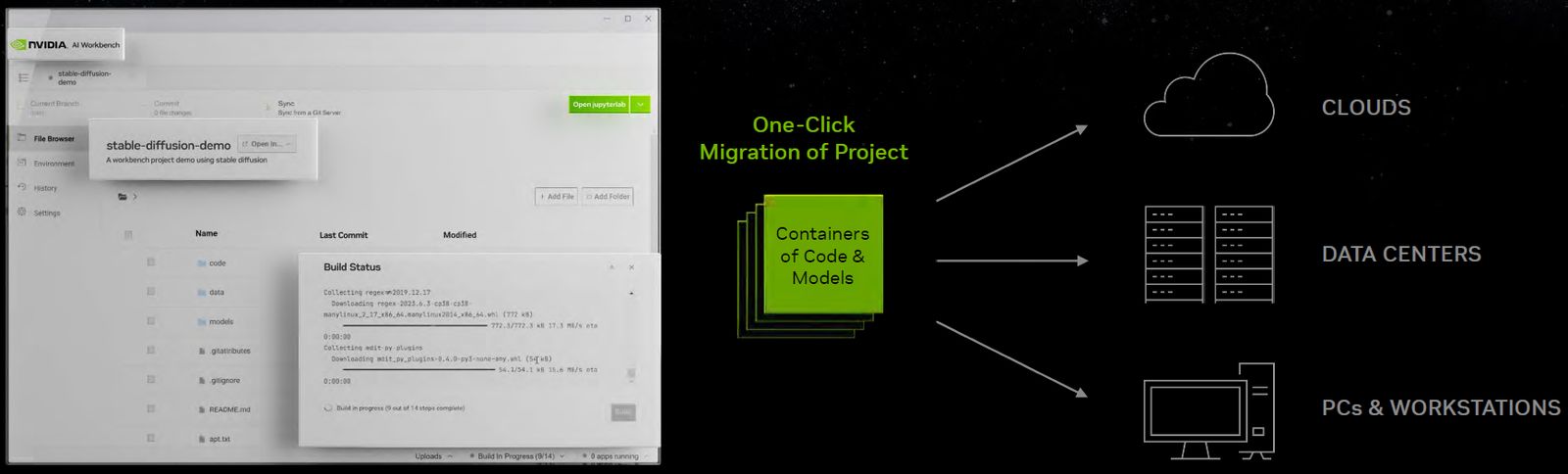

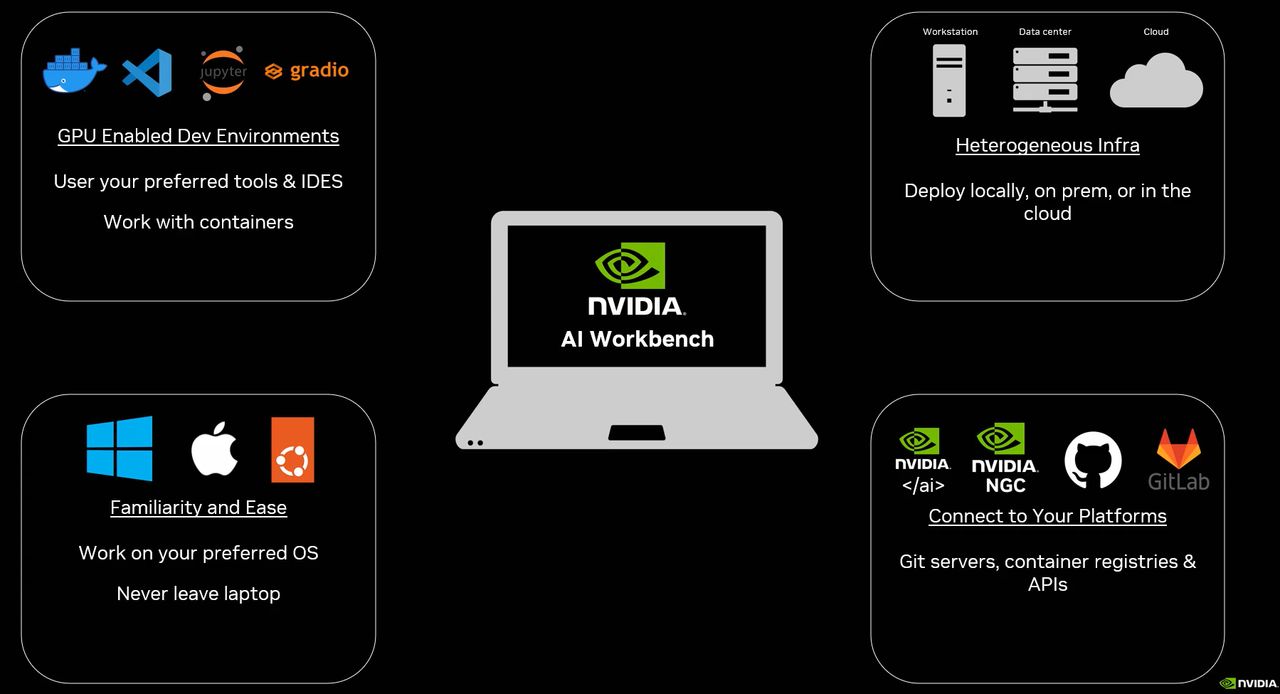

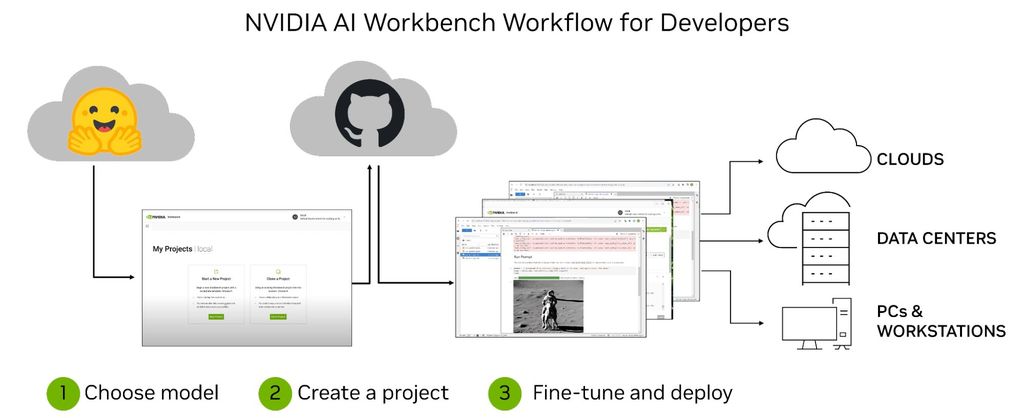

而對於Nvidia而言,他們想透過Nvidia AI Workbench,提供統一、易用的工具套件,協助開發者能夠運用個人電腦、工作站,以及遠端資料中心、公有雲、Nvidia DGX Cloud的GPU資源,快速建立預先完成訓練(pretrained)的生成式AI模型,並且進行測試與內容組成的自定,而且能在此集中管理資料、模型、資源、運算的需求,以及更順暢的協同作業與部署。

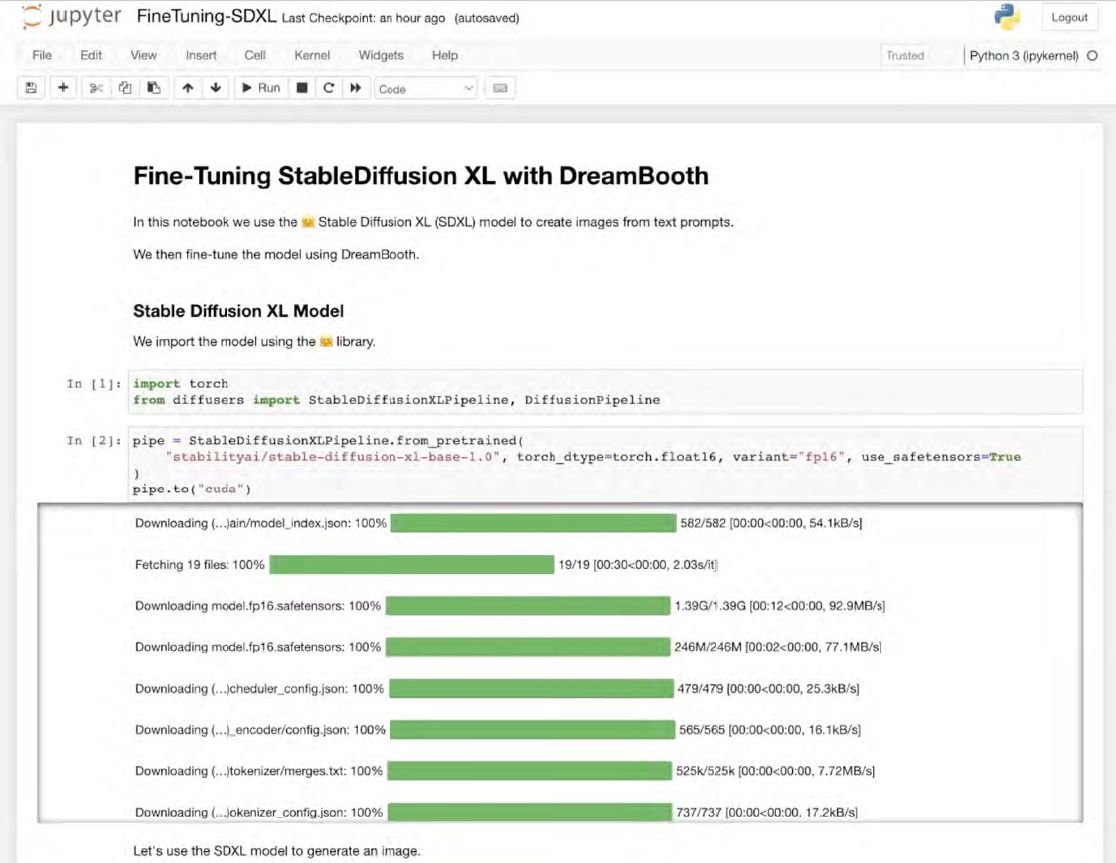

Nvidia希望藉此降低大家著手進行企業AI專案的複雜度,提供能在本機電腦執行的簡化操作介面,開發者能運用自定的資料,針對源於開放原始碼AI軟體與模型資源庫Hugging Face、程式碼共享平臺GitHub、Nvidia GPU雲端軟體開發型錄服務NGC的模型,並且可以根據本身的需求、經過幾個點選動作,在此進行修改與執行,之後可橫跨多種平臺,輕鬆共享這些已完成調整的模型。

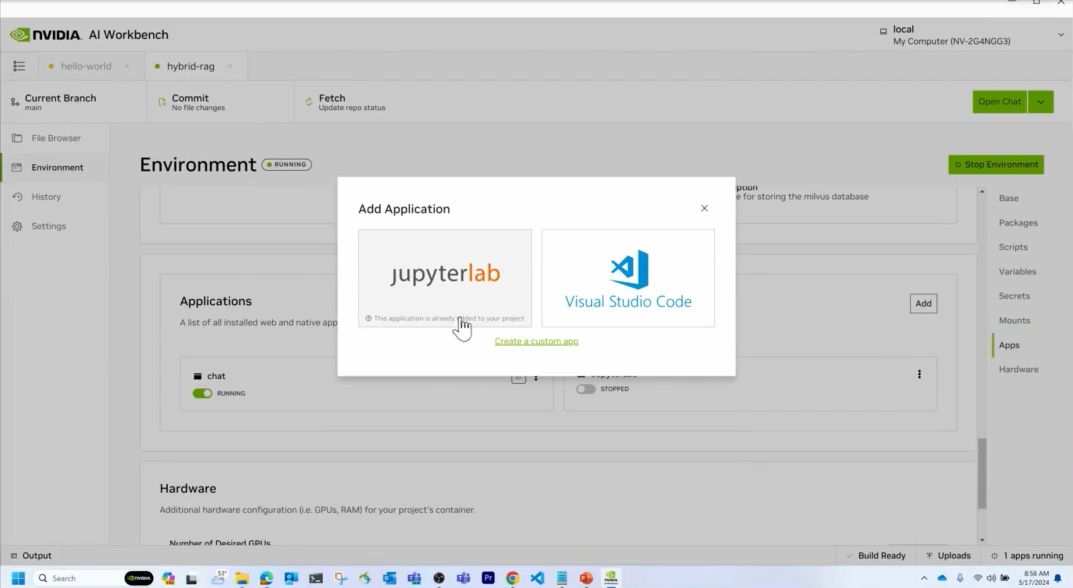

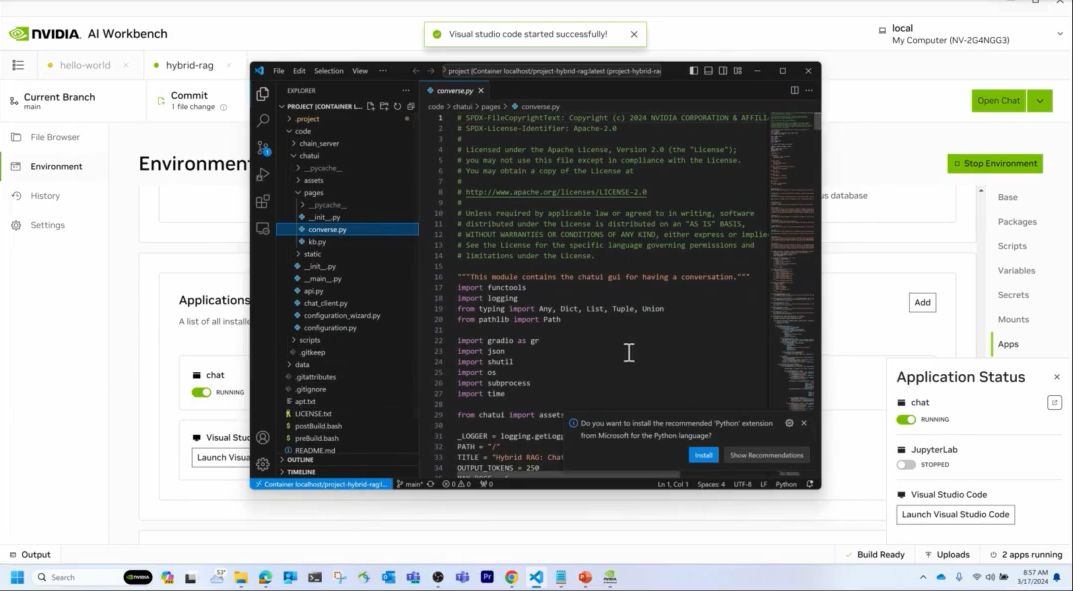

相對地,開發者也能透過這套高度整合的AI輔助開發工具,在JupyterLab、VS Code這兩種整合式開發環境,以原生操作、高度共通與透明的方式,管理多臺硬體設備執行的工作,從多個開放原始碼軟體儲存庫與Nvidia提供的AI/ML軟體平臺,拉取所有必備的企業級AI模型、框架、軟體開發套件、程式庫。

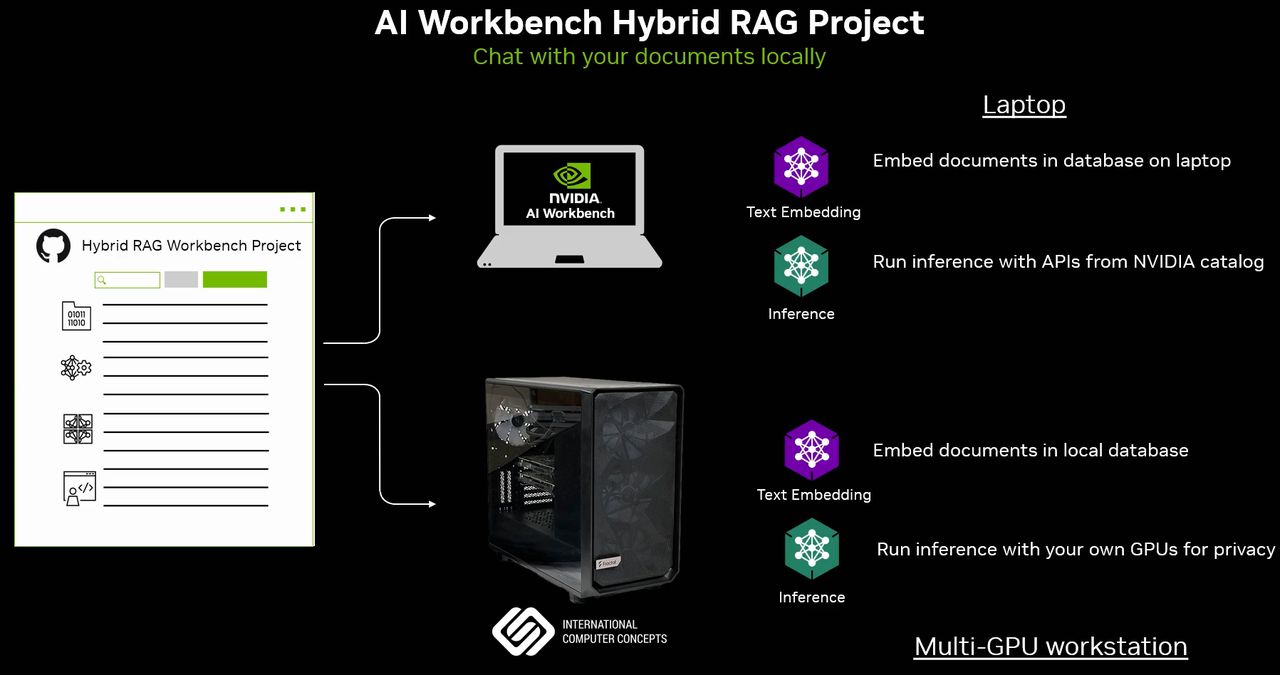

為何Nvidia AI Workbench能同時支援本機與遠端執行?事實上,在個人電腦安裝這套AI工具時,採用主從式(client-server)的架構進行部署,使用者操作介面是執行在搭配Nvidia RTX GPU的桌上型電腦、筆電、工作站,作為工具的基本資源,而且能經由SSH安全加密連線協定,與同臺電腦與遠端伺服器安裝的Workbench Service服務溝通,如此一來,能在多個團隊人員個別的工作站本機進行初期開發,後續等到AI訓練工作規模變大時,可轉移到資料中心或雲端服務、用性能更強大的運算資源完成工作。

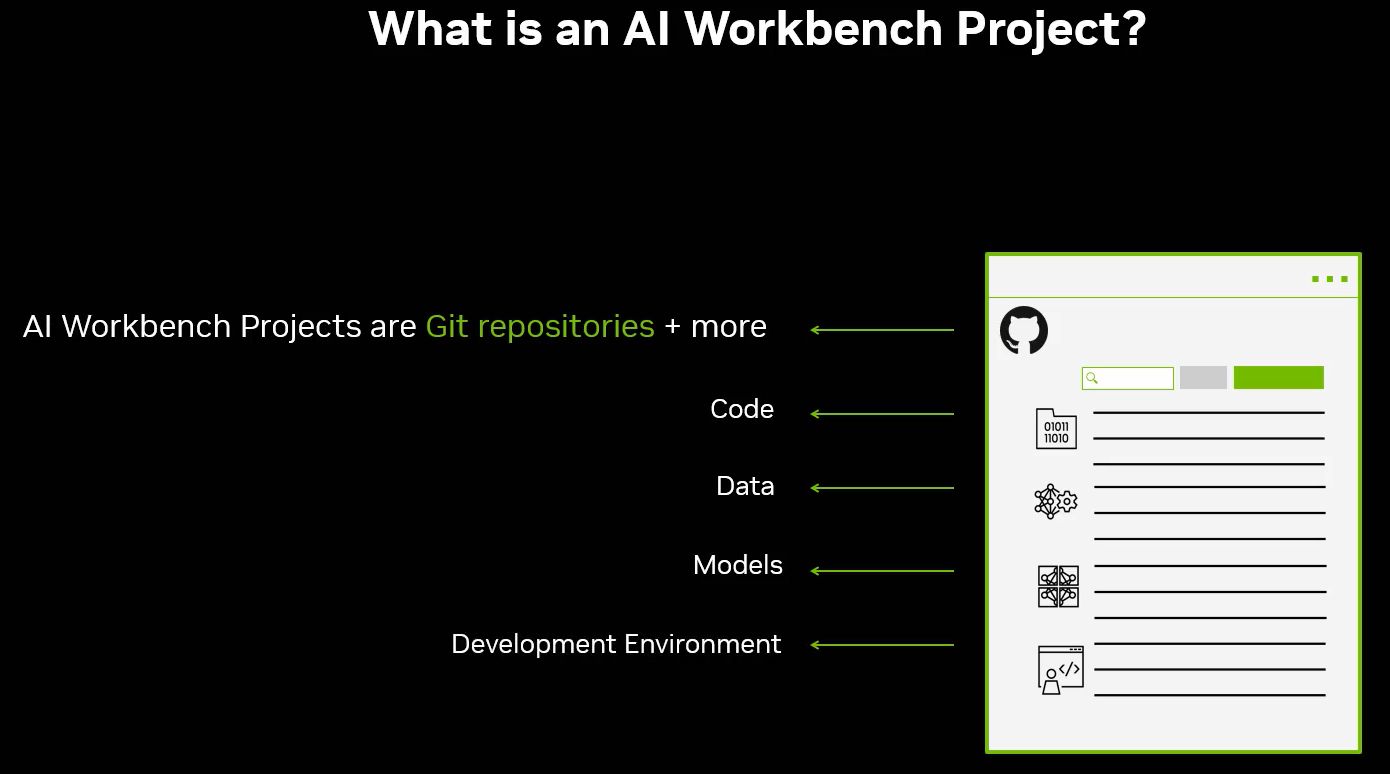

至於Nvidia AI Workbench整合的軟體開發協作機制,也支援用戶內部自建自管的容器登錄服務(registry),以及Git伺服器。基本上,這套軟體開發平臺採用聚焦在個別專案(project)的基礎架構,裡面有一套Git儲存庫,蘊含多個可描述內容與彼此關係、組態設定的指令、執行方式的中繼資料檔案(metadata files)。同時,Nvidia AI Workbench處理的存放位置或相依於使用者的資料,都會清清楚楚地呈現,並且注入執行階段環境(runtime),以便這些資訊不會寫死在專案當中。而這樣的專案架構,有助於自動執行版本管理、容器管理、機密資訊處理等複雜的工作,也能適用於多個團隊的協同合作。

而在去年8月Nvidia AI Workbench最初發表之際,有多家工作站與伺服器大廠商表態支援,像是Dell、HPE、HP、Lambda Labs、聯想、Supermicro,能以此突顯他們提供的實體(本機)與虛擬型態(遠端)GPU工作站,開發者不僅可以運用搭配Nvidia RTX世代GPU的Windows或Linux系統電腦或工作站,進行企業級生成式AI專案的初始建立、測試驗證,以及精密微調,也能以簡單的方式存取位於資料中心與雲端服務業者的GPU運算個體,而在AI系統需要更大的執行規模時,得以順利擴展硬體資源。

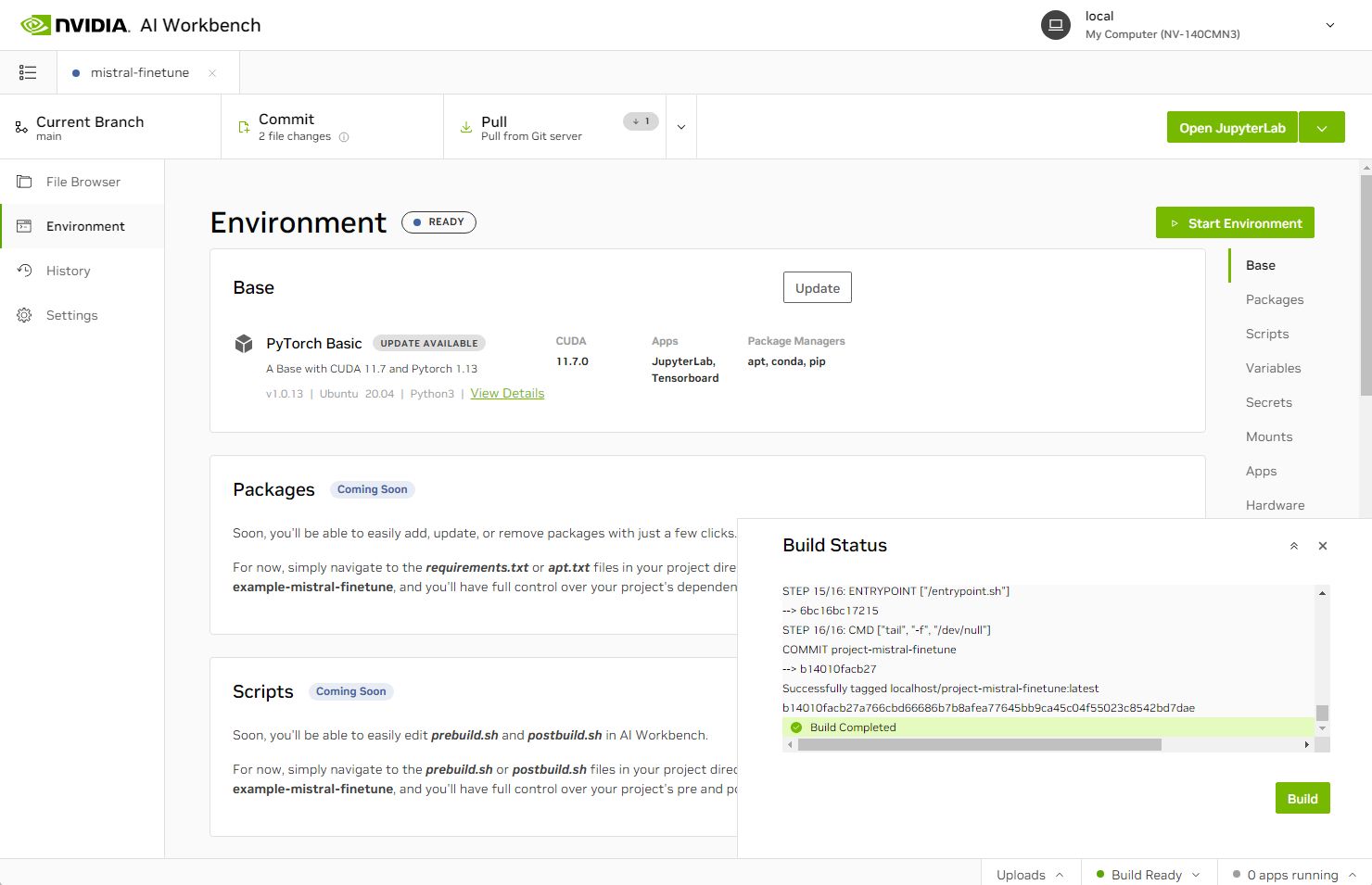

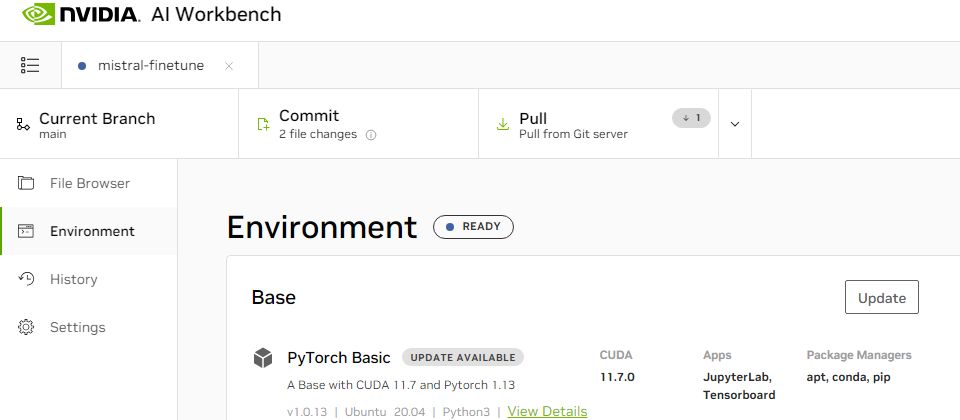

今年1月,Nvidia AI Workbench釋出Beta版,Nvidia揭露可安裝在3種作業系統,分別是Windows 11、Ubuntu 22.04、macOS 11與後續版本;在軟體開發環境的支援上,用戶可透過這套工具的桌面App與命令列介面,存取相容於Git的版本控制系統,執行拉取、推送、餵補;容器執行階段的引擎,可選擇Docker或Podman;在預設搭配的應用程式框架的系統基礎映像,原本只有NGC型錄提供的Python Basic、PyTorch Basic,此時增添3個:CUDA 11.0、CUDA 12.0、CUDA 12.2;關於協助開發者上手的參考範例專案,Nvidia在此提供Mistral(採用QLoRA PEFT微調Mistral 7B模型)、檢索增強生成(RAG)、NeMotron-3(採用Nvidia NeMo微調Nemotron-3 8B模型)等3種。

3月GTC 2024大會期間,Nvidia AI Workbench 1.0版正式推出,開放免費下載,用戶可藉此從Nvidia API型錄或直接在本機電腦的AI推論微服務(NIM),結合雲服務端點(cloud endpoints)來部署生成式AI模型,而在整合開發環境的部分,這一版開始支援VS Code,開發者可在此調度指揮GPU環境當中的容器化專案,關於專案搭配的基礎系統映像,開發者也能在建立專案時,選擇自己的容器映像作為基礎系統映像,但條件是這個映像必須使用遵循基礎映像規格的映像標籤。

1.0版也改善套件管理與安裝方式。開發者可透過Workbench的使用者操作介面,直接進行管理,並且將所需的套件增添到容器當中;對於Windows與macOS的用戶而言,可以更容易安裝Nvidia AI Workbench,同時,在Docker容器執行階段的運用上,也提供更好的支援。

截至7月初為止,Nvidia AI Workbench後續又經歷幾個小改版,例如,5月底釋出的1.1版,作業系統增加支援更多人使用的Windows 10,7月1.2版登場,作業系統增加支援今年4月最新推出的Ubuntu 24.04。

產品資訊

Nvidia AI Workbench

●原廠:Nvidia

●建議售價:免費

●作業系統需求:Windows 10(21H2 19044版以後)與Windows 11(21H2 22000版以後)、Ubuntu 22.04與Ubuntu 24.04、macOS 12

●硬體需求:本機或遠端電腦,16GB記憶體、硬碟空間41 GB、搭配RTX GPU的本機或遠端電腦

●容器執行環境:Docker或Podman

●預設提供容器:PyTorch for AI Workbench、Python Basic for AI Workbench、Python with CUDA 11.7/12.0/12.2、RAPIDS with CUDA 12.0

●程式碼撰寫與執行環境:JupyterLab、VS Code、純文字編輯器

●協同工作環境:GitHub、GitLab

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-06

2026-02-09