7月底Meta釋出Llama 3.1,針對這項眾所矚目的生成式AI模型,我們解讀Meta公司發布的技術文件,整理當中的硬體基礎架構組成,憑藉我們對企業級IT基礎架構相關技術的了解,一起讓更多人認識用來訓練生成式AI模型的超大規模運算環境

2024-08-16

| IT周報 | Mamba | 程式碼生成 | Meta | Llama 3.1 | 蘋果 | Transformer | Nvidia

AI趨勢周報第257期: Mistral AI用Mamba架構打造程式碼生成模型

Mistral AI用Mamba 2架構打造程式碼生成模型,表現比同規模的Transformer模型好;Hugging Face釋出小又強健的語言模型SmolLM;Meta開源Llama 3.1 405B;有效加速Transformer生成時間,蘋果推LazyLLM;Nvidia推出企業級模型客製化平臺AI Foundry

2024-07-26

Meta開源Llama 3.1 405B,強調開源才是AI的未來

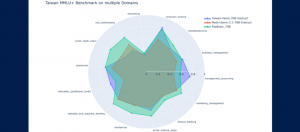

Meta強調相較於GPT-4o與Claude Sonnet等封閉性模型,規模涵括80億到4千億個參數的Llama 3.1家族除了具備更好的成本與性能,模型的開放性也成為外界微調出小模型的最好選擇

2024-07-24