| 開源模型 | Mixtral 8x22B | Mistral AI | Mixtral

Mistral AI以Apache 2.0授權釋出Mixtral 8x22B模型,Mixtral 8x22B支援1,760億個參數,以及6.5萬個Token的脈絡長度,成為目前最大的開源模型之一

2024-04-11

| Mistral | LLM | Llama 2 | SMoE | GPT | Mistral AI | Mixtral

Mistral AI開源採用SMoE架構的Mixtral 8x7B模型,整體效能超越Llama 2 70B與GPT-3.5

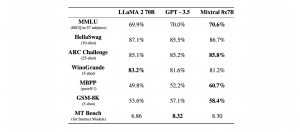

Mistral AI開源最新模型Mixtral 8x7B,透過採用稀疏混合專家(SMoE)模型架構,在處理大量參數和資料的同時,也維持一定的計算效率,在多數基準測試上超越Llama 2 70B(700億參數)和GPT 3.5模型

2023-12-13