| Mistral AI | AI Studio | AI治理

Mistral推出AI Studio平臺,協助AI系統從原型走向生產環境

Mistral推出AI Studio,整合可觀測性、代理執行環境與資產登錄庫3大支柱,協助企業建立從提示設計到上線營運的完整流程,強化人工智慧專案的監控、重現與治理能力

2025-10-27

| Mistral AI | ASML | 半導體 | AI新創

Mistral AI完成17億歐元C輪融資,投後估值117億歐元

法國人工智慧新創Mistral AI完成17億歐元C輪募資,由ASML領投13億歐元並取得11%股權,投後估值達117億歐元

2025-09-10

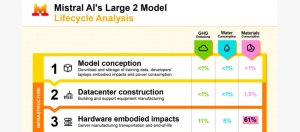

| Mistral AI | 大型語言模型 | LLM | 模型生命周期 | 碳排放 | 水資源消耗 | 永續

Mistral AI發布全球首份AI模型的生命周期環境影響報告,揭露碳、水、資源消耗影響

隨著生成式AI快速擴張,Mistral強調業界亟需建立統一的環境評估框架,讓使用者、企業與政府能更清楚掌握AI模型從開發、部署到使用階段產生的碳排放,以及消耗的水資源與金屬資源

2025-07-23

| Le Chat | 聊天機器人 | Mistral AI

Mistral AI聊天機器人加入Deep Research、Think Mode等功能

Mistral AI強化聊天機器人le Chat,加入深度研究、推理模式、語音模式以及圖像生成編輯功能

2025-07-18

| Mistral AI | 語音模型 | Voxtral | 開源模型 | 開源語音模型

Mistral AI強調語音模型Voxtral以開放形式提供最先進的準確性及原生語義理解,但價格不到競爭對手的一半

2025-07-16

| Mistral AI | Mistral Compute

Mistral跨足AI雲端平臺業務 推出Mistral Compute

Mistral Compute是Mistral和Nvidia合作的完整AI基礎架構平臺,以Mistral AI的訓練套件為核心,提供私有、整合式AI技術堆疊

2025-06-13

| Mistral AI | 推理模型 | Magistral | Magistral Small | Magistral Medium

Mistral AI發表推理模型Magistral,包括開源的Magistral Small以及商用Magistral Medium二種版本

2025-06-11

| Mistral OCR | Mistral AI | 光學字元辨識 | 文件數位化

Mistral發表文件OCR API 支援PDF、圖片、影音也看得懂數學

Mistral AI公布光學字元辨識API「Mistral OCR」,可自PDF以及圖文交錯文件擷取出內容,協助用戶加速文件數位化作業

2025-03-11

| Mistral AI | LLM | 中東 | 印度 | 本地部署

Mistral推出高效能、小型化區域語言模型Saba,專為中東與南亞市場設計

Mistral AI推出具240億參數的Mistral Saba語言模型,專為中東與南亞市場設計,透過高品質資料集提升語言理解,經效能最佳化並支援本地部署,以兼顧推理速度與資料隱私

2025-02-19

| Mistral AI | Le Chat

Mistral AI推出聊天機器人Le Chat手機版App,1秒可輸出1,000字

Mistral AI公布Le Chat服務重要更新,強調推理、思考和回應能力速度比其他聊天機器人更快,也推出行動應用程式版本以及功能更強大的進階訂閱方案

2025-02-08

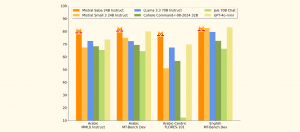

| Mistral AI | Mistral Small 3

Mistral開源Mistral Small 3 24B,稱效能超越3倍大的Llama 3.3

Mistral AI強調Mistral Small 3是為了能完成80%生成式AI任務而以指令預訓練的模型,參數量240億,以便在本地部署且仍能提供強大效能

2025-02-03