圖為廣達與Nvidia合作推出的EGX伺服器。

攝影/翁芊儒

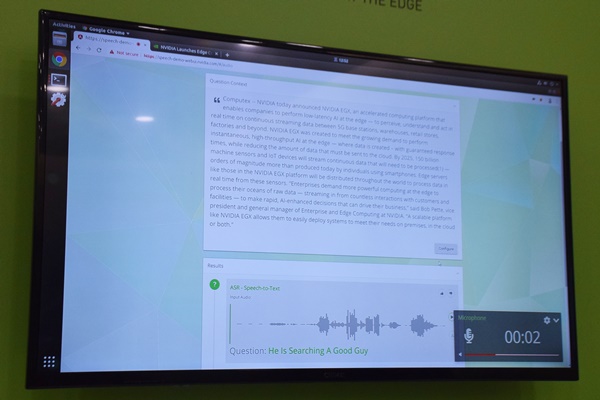

Nvidia在COMPUTEX期間,展示了新推出的邊緣運算平臺EGX在不同場景中的應用,包括監測路況的即時影像分析與對話式AI客服等。EGX平臺也能與Azure、AWS的雲端運算服務相容,企業可先在雲端AI模型,再部署到本地端來應用。

現場展示的對話式AI客服,是在顧客說話提問後,透過語音辨識(Automatic Speech Recognition,ASR)將語言轉化為文字,再經由自然語言處理(Natural Language Processing,NLP)到文本內容中尋找答案,最後運用文字轉語音(Text To Speech,TTS)的技術回答顧客問題。而這整個流程,都是透過邊緣運算完成。

Nvidia表示,Chatbot常用三種AI技術中,訓練ASR模型和TTS模型,適合在本地端,前者不用上傳大量聲音檔案,後者則可避免網路的延遲性導致聲音斷斷續續、或發音不完整,不過,要訓練NLP模型則因運算量較大,可先在雲端訓練。

Nvidia也示範用只一篇新聞稿來展示用EGX平檯訓練這三種Chatbot所需模型的情況,首先讓NLP模型來分析新聞稿文字。

示範人員實際提問:Who is Bob Pette?

這個示範系統會將從NLP模型找出來的答案,透過TTS模型生成語音來回答顧客;若無法在資料文本中找到答案,則會提供制式回答「Empty、No answer。」

Nvidia表示,未來提供企業的EGX平臺,會包括執行邊緣運算的硬體以及AI模型的參考框架。硬體的部分,EGX平臺有強大的擴充性,可以支援體積極小、運算可達5 TOPS的Nvidia Jetson Nano,同時也能支援一整櫃的Nvidia T4伺服器,提供超過10,000 TOPS的效能。

除了硬體之外,Nvidia也會釋出的AI模型的參考框架,如應用案例中的NLP模型,是用目前最新、準確率最高、由google開源釋出的NLP模型BERT來做,未來釋出參考框架(Example model)後,可以讓客戶在平臺上用自家數據來訓練,也可以直接將訓練好的模型替換到平臺上。但參考框架會如何做、EGX平臺未來會支援哪些深度學習框架,Nvidia並無透露。

EGX平臺的軟體架構(Nvidia Edge Stack)與AWS、Azure的IoT雲端服務相連,讓企業能自行在雲端建立AI模型,再部署到平臺來應用,而在平臺上建立的模型也能連結到雲端使用,Nvidia產品行銷部經理Paresh Kharya也表示,企業可以透過AWS IoT Greengrass和微軟Azure IoT Edge來管理這些服務。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10