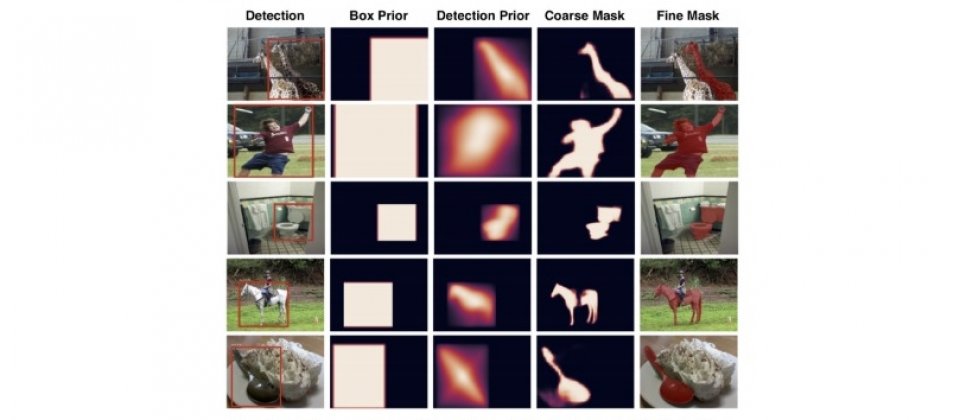

Google開發了一種稱為ShapeMask的實例切割演算法,能辨識圖像中的物體實例,並且產生高精確度的遮罩,現在Google開源ShapeMask模型,讓社群有辦法以兼具速度和精確度的方法產生圖像物件遮罩。

要以程式辨識各種形狀、顏色和大小並非簡單的工作,但這些工作對於醫學圖像分析,和照片編輯等應用來說十分重要,因此Google開發出了新圖像分割模型ShapeMask。ShapeMask可辨識並追蹤特定物件實例的邊界,像是城市街道上有多輛汽車的圖像,ShapeMask可以突出顯示圖像中每輛不同顏色大小的汽車,而突出顯示的區域就稱為遮罩。

ShapeMask是利用著名的物件偵測模型RetinaNet,來偵測圖像中各種物件的位置和大小,但是RetinaNet模型並無法產生物件的遮罩,因此Google在以RetinaNet定位物件之後,會將相似外觀的畫素進行分組,逐步完善偵測到的物件形狀,最終產生精確的遮罩。

Google提到,對於依賴自動化圖像分割的應用程式,開發者通常需要使用大型資料集,且又需要頻繁的變更資料集,為了快速迭代大型逼真的資料集,企業需要擴展圖像分割模型訓練的規模。

而ShapeMask在大批次的訓練,比其他圖像分割模型還要有效率得多,因為ShapeMask可以在大數量的機器學習加速器上,進行分散式的ShapeMask訓練。Google以256核心的Cloud TPU v3分片,在40分鐘內就可以完成以COCO圖像分割資料集訓練ShapeMask模型,這比起8核心的單一Cloud TPU裝置所花費的數小時,還要快上許多,而且無論以哪一種規模的Cloud TPU Pod來運算ShapeMask模型,都不需要修改任何程式碼。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13