Google發布了Open Images V6,這擴充了Open Images資料集註解,加入像是狗接飛盤這樣的視覺關係,以及女人跳躍等人類動作註解,還新增了大量的影像等級(Image-Level)的註解,影像等級註解為整張圖像提供整體的註解。特別的是,這個補充資料集還多了局部化敘事(Localized Narrative)註解,這是一種全新的多模式註解方式,可以在物件描述上同步語音、文字和滑鼠軌跡。

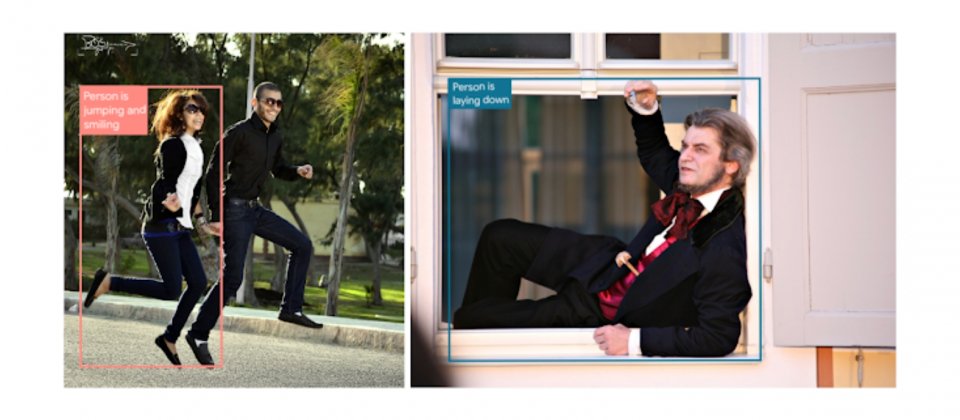

Google提到,局部化敘事的目的之一,便是研究以及利用視覺和語言之間的關聯,配對圖像以及人類撰寫的描述,也就是為圖像加上圖說。而圖像加圖說的限制,則是缺乏視覺基礎,也就是無法將圖像內容對應到文字描述中,(下圖中)過去的方式是將文字描述中的名詞,在圖像中以各種顏色繪製出最小邊界框(Bounding Box)。

.png)

而在Google的局部化敘事中(上圖右),每個在文字描述中的單詞都是基礎,局部化敘事由註解者產生,註解者提供圖像的語音描述,並同時將游標移到描述的圖像區域上,Google表示,語音註解是方法的核心,因為可以將描述和參照的圖像區域關聯起來。而為了使描述更容易存取,註解者會手動轉錄他們的描述,並與自動轉錄的結果進行比對,以恢復描述的時間戳記,確保語音、文字和游標軌跡正確且同步。

由於同步語音和游標指示很直觀,所以Google並沒有給註解者很明確的任務說明,因此註解者可能會以螺旋或是畫下底線的方式在圖上註記,而這可能為Google未來的用戶介面設計研究,帶來新的想法。新加入的局部化敘事註解資料集非常豐富,滑鼠軌跡總長有6,400公里,不停播放所有的描述語音,則需要花費1.5年的時間。

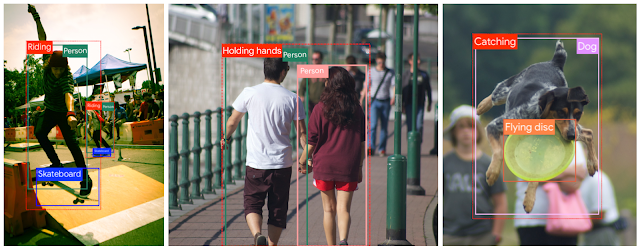

在Open Images V6中,Google還增加視覺關係類型註解,新增像是男人踩著滑板、男人女人牽著手,以及狗接住飛盤等範例(下圖)。Google提到,在電腦視覺中,圖像中的人是電腦視覺感興趣的重點,而對於許多應用程式來說,了解圖像中人們的行為則至關重要。Open Images V6還包含了跳躍、微笑和躺下等獨立動作。另外,Google也增加了2,350萬個經人工驗證的圖像等級標籤,因此現在於2萬類別中,已經有接近6,000萬個標籤。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06