Google擴展自然語言處理技術BERT,發展出能夠處理表格資料結構,回答表格內容查詢的新方法TAPAS;Google強調,TAPAS能夠處理的對象不僅限於單一表格類型,而是可應用到廣泛領域的表格。

許多資訊以表格的形式儲存,從網路上的資料庫和文件裡,都能找到儲存豐富資訊的表格,內容可能包含產品的技術規格、國家發展統計資料或是賽事結果等資料,而目前處理這些表格,不是需要人工查詢,就是要使用針對特定問題的服務來查詢。

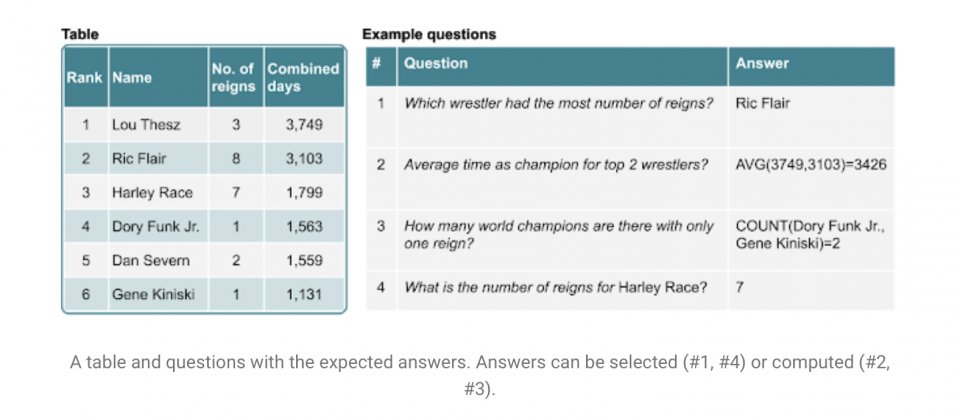

當這些表格能夠應用自然語言查詢,則裡面的資訊就更加容易被取得,使其更具價值,Google提到,現在有一些新的研究在處理這類問題,把自然語言問題轉換成SQL查詢,以查詢資料庫的方式查詢表格,但是這種方法通常需要進行大量電腦工程的工作,以產生特定語句結構和語意查詢,且只能處理非常特定的表格,難以擴展處理任意的問題。

因此Google希望以自然語言處理來解決這個問題,因而發展出TAPAS。Google第一個要解決的部分,就是處理查詢問題的方法,Google使用BERT開發出可將問題和表格內容逐行編碼的模型,Google解釋,他們以特殊的嵌入擴展BERT模型,因此讓模型能夠編碼表格結構。

這個模型會有兩個輸出,其一是為每個表格單元計算一個分數,用來表達成為答案的機率,另一個則是生成聚合操作,指示產生最終答案所需要進行的動作,像是平均、加總或是計數等。為了對這個模型進行預訓練,研究人員從英文維基百科中,擷取了620萬個表格文字配對,以作為訓練資料集,讓模型學習恢復表格或是文字中,遭到移除的單詞。預訓練之後,研究團隊利用弱監督方法微調模型,以有限的來源提供標記訓練資料的訊號。

研究人員將他們的模型應用在SQA、WTQ(WikiTableQuestions)和WikiSQL三個資料集,並與這3個資料集當前的先進模型(SOTA,State-Of-The-Art),進行解析表格比較,分別是原研究團隊先前運用SQA資料集的模型,還有應用WTQ的Wang et al.(2019)以及使用WikiSQL的Min et al(2019)方法。

.png)

實驗結果顯示,Google的新模型比SQA的SOTA的表現高了12.1分,也比WTQ來自史丹佛大學的SOTA高了4.3分,並與WikiSQL的Min et al(2019)打成平手,略輸0.3分。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09