繼OpenAI共同創辦人Ilya Sutskever離職之後,另一名OpenAI研究人員Jan Leike也在上周五(5/17)宣布開該公司。Leike是OpenAI超級對齊(Superalignment)團隊的共同主管,宣稱在最近這幾年,OpenAI推出絢爛產品的重要性已經超越了安全的文化與程序。同一天,OpenAI的兩名共同創辦人Greg Brockman與Sam Altman便對此作出回應。而根據《彭博社》(Bloomberg)的報導,OpenAI實際上已經解散了成立不到一年的Superalignment團隊。

OpenAI是在2023年7月設立超級對齊團隊,該團隊的任務是「確保那些具備超級智慧、比人類還聰明的AI系統得以遵循人類的意圖」,當時OpenAI亦承諾要在未來的4年將投入20%的運算能力,來解決超級智慧的對齊問題,而該團隊的兩名共同主管即是相繼於上周離職的Sutskever與Leike。

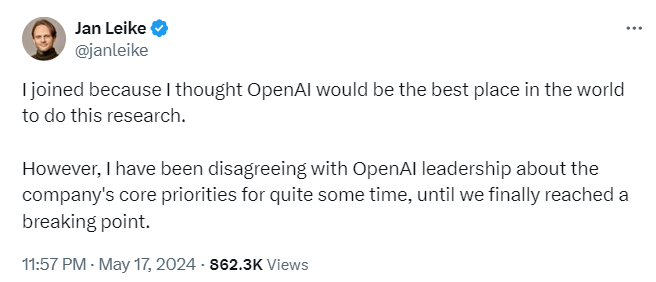

Leike表示,離開該工作是他做過最困難的事情之一,因為他們迫切需要弄清楚如何引導與控制AI系統,當初加入的原因即是因為他認為OpenAI是世上最適合執行此一研究的最佳場所,然而,很長一段時間以來,他一直不同意OpenAI領導階層關於公司核心優先事項的看法,最終達到了臨界點。

他認為應該要把更多的資源用在下一代模型的安全性、監控、對抗魯棒性、超級對齊、機密性及社會影響等相關議題,但過去幾個月該團隊一直在逆勢中掙扎以獲取運算資源。Leike指出,打造比人類更聰明的機器於本質上就是一項危險的工作,代表全人類的OpenAI肩負著巨大責任,OpenAI必須成為一家以安全為優先的通用人工智慧(AGI)公司。

Brockman及Altman也聯名對Leike的看法作出了回應,表示已經提高了對AGI所帶來風險與機會的認識,號召AGI的國際治理,並協助創立了評估AI系統災難性風險的科學;同時也替日益強大之AI系統的安全部署奠定了基礎;未來還會不斷提升安全工作以應對每個新模型的利害關係。

不過,這兩位OpenAI的共同創辦人也坦承,第一次就要確保新技術的安全性並不容易,也沒有可用來引導AGI路徑的劇本,相信實證可以幫助指引前進的方向,他們非常重視自己的角色也會謹慎看待對OpenAI行動的回饋意見。

今年才成立的AI問責聯盟(Coalition for AI Accountability)則發動了一項連署行動,指出OpenAI從一非營利機構轉向至快速擴展AI模型,其高階管理團隊在監督與問責上一再出現失敗,對於像AI這類重要及危險的技術來說,並不適用於某些科技公司受到讚揚的「打破常規及快速行動」態度。要求OpenAI成立一個由AI安全及公民領導者組成的非營利董事會;確保其非營利組織不受營利子公司的財務影響;向非營利組織、監管機構及學術界建立早期存取模式;擴大專注於安全及道德的內部團隊並賦予否決權;以及對OpenAI的產品承擔明確的法律責任。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09