| 開源模型 | Mixtral 8x22B | Mistral AI | Mixtral

Mistral AI以Apache 2.0授權釋出Mixtral 8x22B模型,Mixtral 8x22B支援1,760億個參數,以及6.5萬個Token的脈絡長度,成為目前最大的開源模型之一

2024-04-11

| Databricks | Mistral AI | Mistral 7B | Mixtral 8x7B

Databricks投資Mistral AI並整合模型到平臺

Databricks除了參與Mistral AI的A輪募資,也將Mistral 7B及Mixtral 8x7B模型整合到Databricks AI分析平臺Data Intelligence Platform

2024-03-19

| OpenAI | GPT-4 | google | Gemini 1.5 | Mistral AI | Mistral Large | Anthropic | Claude 3 | Inflection AI | Inflection-2.5 | 大型語言模型

GPT-4競爭者報到:Gemini 1.5、Mistral Large、Claude 3 Opus與Inflection-2.5

在幾周前尚無對手的OpenAI GPT-4,最近忽然冒出4個與之競爭的大型語言模型,這些新模型皆宣稱足以比美GPT-4,其中研究人員覺得最有實力的則是Anthropic發表的Claude 3家族頂級模型Opus

2024-03-11

| Mistral AI | 大型語言模型 | Mistral Large | 聊天機器人 | Le Chat

Mistral AI發表Mistral Large模型及Le Chat聊天機器人,企圖與OpenAI較勁

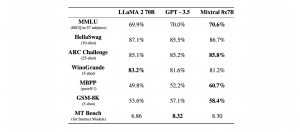

Mistral AI聲稱Mistral Large模型提供一流的推論能力,可支援複雜且多語言的推論任務,在許多常用基準測試的表現上,贏過Gemini Pro 1.0、Meta LLaMA 2 70B等模型,僅次於OpenAI的GPT 4

2024-02-27

| AWS | Mistral AI | LLM

Amazon Bedrock將上架Mistral 7B和Mixtral 8x7B兩開源語言模型

AWS將在雲端人工智慧模型平臺Amazon Bedrock提供兩個Mistral AI模型,分別是輕巧的Mistral 7B,以及可高效處理大量參數和資料的Mixtral 8x7B

2024-02-27

| Mistral | LLM | Llama 2 | SMoE | GPT | Mistral AI | Mixtral

Mistral AI開源採用SMoE架構的Mixtral 8x7B模型,整體效能超越Llama 2 70B與GPT-3.5

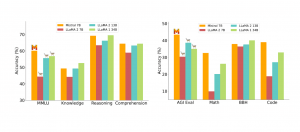

Mistral AI開源最新模型Mixtral 8x7B,透過採用稀疏混合專家(SMoE)模型架構,在處理大量參數和資料的同時,也維持一定的計算效率,在多數基準測試上超越Llama 2 70B(700億參數)和GPT 3.5模型

2023-12-13

| Mistral AI | LLM | Llama 2

Mistral AI開源輕巧高效能語言模型Mistral 7B

Mistral AI推出的開源語言模型Mistral 7B,雖只有73億參數,但在各項基準測試上表現優於Llama 2 13B模型,提供開發者另一個高效且具可擴展性的選擇

2023-09-28