歷經了十多年的軟體定義儲存潮流後,當前的企業儲存設備硬體核心架構,又開始走向結合專用硬體的發展路線。

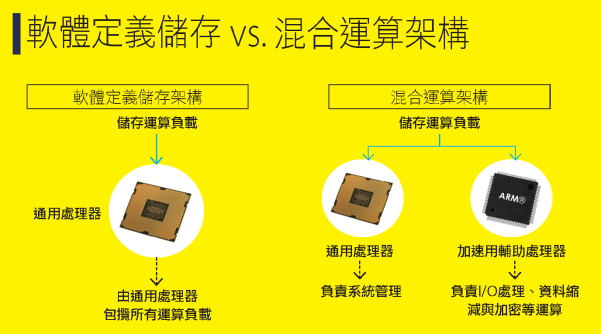

回顧過去十多年,除了極少數廠商外,企業儲存設備幾乎全面倒向軟體定義架構,以通用伺服器構成硬體,藉由運行專屬儲存軟體來提供儲存服務。原本儲存陣列中各式各樣的專屬I/O處理器、ASIC晶片等輔助處理器,也不復存在,改為完全依靠通用處理器來包攬所有運算工作。

然而,隨著應用環境的變化,純粹的軟體定義儲存架構,已遭遇了瓶頸,單憑通用處理器,已越來越難以應付持續增加的新興資料服務運算需求,這也帶來了輔助處理器重回儲存設備核心架構的契機。

作為主流的軟體定義儲存架構

2000年代早期的儲存陣列,控制器核心幾乎都是由通用處理器搭配ASIC晶片構成的混合架構,通用處理器負責一般管理,ASIC則承擔I/O處理作業。但由於ASIC晶片開發成本高昂,給廠商帶來很大負擔,於是當通用處理器的功能與效能逐漸提高後,便開始流行通用處理器架構結合軟體功能,取代過去ASIC的角色。

隨著儲存陣列控制器核心架構逐漸轉往「通用處理器化」,儲存陣列接著便朝向徹底的「通用硬體化」發展,不僅止於控制器核心走向通用硬體架構,連同整個儲存陣列系統,都以標準的通用伺服器硬體構成,從而抹除了儲存陣列與伺服器在硬體方面的界線,形成了儲存設備的「軟體定義化(Software defined)」。在這種架構下,儲存設備與一般伺服器之間,唯一的不同,只剩下儲存設備系統運行的,是專供儲存服務的儲存作業系統軟體,一般伺服器則是運行通用作業系統。

基於通用硬體的軟體定義儲存,最大優勢便是硬體成本低,且便於迅速更新。由於所有硬體元件都來自標準的通用伺服器,元件的取得與後勤管理相對容易,也能跟隨Intel更新處理器而同步升級,儲存廠商不僅能省下自行開發晶片的龐大開支與時間,也能大幅加快硬體核心的更新速度。

而對用戶來說,當儲存設備改用通用硬體之後,也避免了被特定廠商專屬硬體規格綁定的困擾。

職是之故,軟體定義儲存架構風潮在過去十多年來,橫掃了整個儲存業界,同時受到儲存廠商與用戶兩方面的歡迎,即使是Dell EMC、HPE等一線大廠,旗下主力產品線的硬體核心,其實也都是由通用伺服器硬體元件構成,甚至是直接取用自標準的通用伺服器。

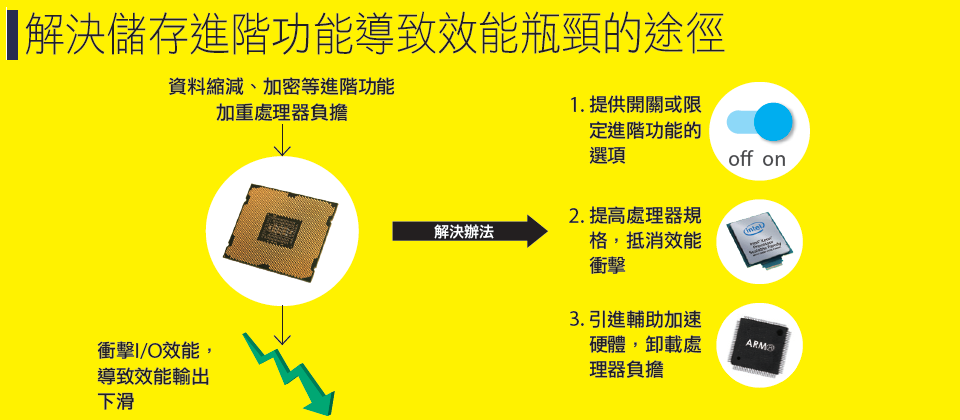

面對資料縮減、加密等進階應用功能,給儲存I/O效能帶來的衝擊,可採取3種因應方式,但其中的關閉功能或限定資源耗用的方式。只是迴避問題,至於提高處理器規格,又有顯著提高硬體成本的副作用,所以,最合理的解決辦法,是透過輔助加速硬體,來卸載處理器的負擔。資料來源:iThome整理,2021年3月

軟體定義儲存架構遭遇瓶頸

然而隨著應用環境的變化,一系列極耗處理器資源的新興儲存功能,開始進入主流應用,這也讓已經風行了10多年的軟體定義儲存架構,開始暴露出效能瓶頸的問題。

為了減緩資料增長帶來的儲存空間消耗,用於減少資料占用容量的重複資料刪除(Data Deduplication)、即時壓縮等資料縮減技術,現在已走出備份、歸檔等二線儲存領域,成為第一線儲存陣列必備的基本資料服務功能;另一方面,在日趨升高的資安威脅下,對於保存敏感資料的關鍵儲存設備來說,即時加、解密功能亦是不可或缺。

然而,資料縮減與加密等功能,也大幅增加了儲存設備的運算負荷,完全依靠通用處理器來包攬所有運算作業的純軟體定義架構,已越來越無法負擔這種複雜環境的運算要求。

以資料縮減技術為例,無論壓縮還是重複資料刪除,都會耗用相當多的控制器資源,包括處理器使用率、記憶體空間與I/O頻寬等,如重複資料刪除的特徵值比對作業,便會耗用許多CPU運算週期,而作為比對基準的Hash Table也會占用相當大的記憶體空間。實際經驗顯示,啟用即時壓縮與重複資料刪除後,往往會給儲存陣列的I/O效能,帶來20~30%以上,甚至更多的減損。

無論從什麼標準來看,啟用某項進階功能後,導致這樣大的I/O效能減損,都是不能接受的,對儲存應用來說是本末倒置。這也讓儲存廠商面臨了二擇一的困境——不是必須限制資料縮減或加密等功能的使用,就是要設法變革硬體架構,以承擔這些新興進階功能的運算負荷。

標準的軟體定義儲存架構下,所有運算負載都是由通用處理器承擔,一旦啟用極耗處理器資源的功能(如壓縮與重複資料刪除),便會嚴重衝擊整個系統的效能。而在混合架構下,則是將運算負載分流給通用處理器與輔助處理器承擔,後者專門處理I/O、資料縮減與加密等進階功能的運算負載,因此啟用這些進階功能,不致造成整體效能的降低。資料來源:iThome整理,2021年3月

克服效能瓶頸的出路——硬體加速

面對進階資料服務功能,導致的儲存效能瓶頸問題,儲存廠商通常可以採取這3種解決辦法:

第1種:為資料縮減與加密等功能,提供可開關的選項,或是提供占用資源上限的設定,由用戶視個別環境的儲存I/O負荷,自行決定是否啟用這些功能,或是設定這些功能可以使用的硬體資源上限。

然而這類做法只是緩解或迴避問題而已,並沒有真正解決效能瓶頸。

第2種:採用更高規格的處理器,來抵消資料縮減與加密技術耗用的處理器運算資源。這種做法確實能解決效能瓶頸,問題在於,也會帶來顯著拉高硬體成本的副作用。

第3種:是引進專用加速硬體,將資料縮減技術與加解密等運算工作,卸載給專用硬體來執行,如專用的壓縮晶片或加密晶片。比起前兩種辦法,專用加速硬體顯然更為有利,除了能解決效能瓶頸問題外,近年來隨著FPGA與新式嵌入式處理器的發展,也大幅降低了儲存廠商導入加速硬體的難度與成本,儲存廠商可以相對容易地為儲存設備引進加速晶片,但又不致大幅增加整個控制器的成本,就成本效益來說更為有利,顯然是最合理的做法,因而也成為近來開始普及的發展路線。

而結合了輔助的加速用硬體之後,也讓儲存陣列走出純粹的軟體定義儲存架構,回歸通用處理器+輔助加速硬體的混合架構。

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05