深度神經網路可以解決不少大範圍具有挑戰的任務,但是深度神經網路由許多獨立的神經元組成,因此計算的過程相當複雜,也常常被稱為黑盒子,DeepMind近日發表一篇論文,透過神經元的刪除法(Neuron deletion),了解個別神經元對神經網路的重要性,試圖瞭解深度學習的運作過程。

DeepMind認為,了解深度學習網路如何運作是很重要的,若能解釋神經網路如何制定決策將有助於日後建立更精準的模型,這就像是,在不了解每個機械零件如何運作,就要打造出一個時鐘是非常困難的。其中一個可以解開深度學習黑盒子的方法是,針對較容易解釋的神經元,來理解每個獨立的神經元在神經網路終所扮演的角色。

DeepMind的神經元刪除法是受到存在數十年的神經學研究啟發,這項研究主要是藉由刪除一小部分的神經元,來探討一小群神經元對整個神經網路的重要性,研究了較容易解釋的神經元是否對神經網路的計算較為重要,DeepMind的研究團隊利用刪除部分的神經元來觀察神經網路的表現,而這項實驗發現了兩個出乎意料的結果。

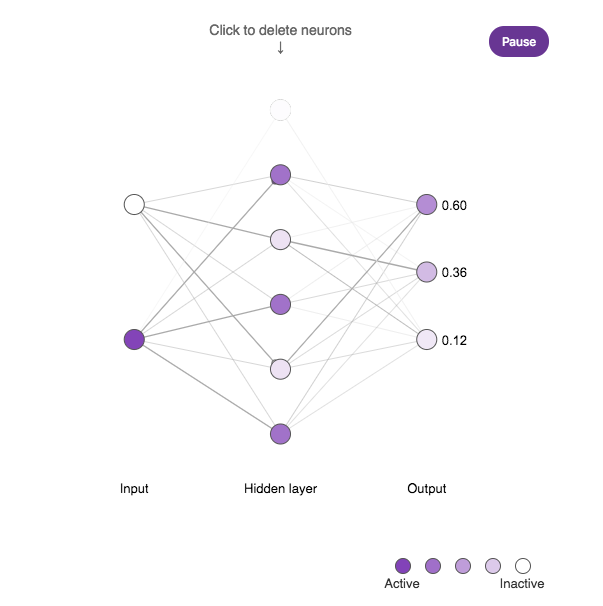

第一,過去許多研究聚焦於理解較易解釋的神經元,這類的神經元稱為選擇型神經元,像是分類貓的神經元,或是在深度神經網路的隱藏層中,只對貓的圖片有反應 (Active)的神經元,但是,DeepMind的研究團隊發現,這些神經元都沒有不容易解釋的神經元來得重要。

DeepMind表示,雖然分類貓的神經元比較容易理解,但是它並不是非常重要,在神經學和深度神經網路的研究中,都已經分析了只對單一匯入的圖像類別(例如:狗)反應的神經元。

也因此,像是貓神經元、情感神經元都被視為較為重要的神經元,相較於這類的神經元,對於匯入圖像隨機產生反應,由於較難理解,一直無法證實這些難以理解的神經元重要性。

為了評估神經元對深度神經網路的重要性,DeepMind測量了刪除個別神經元後,神經網路對於分類圖像表現的變化,若該神經元對於整個神經網路非常重要,則刪除後會導致神經網路的表現變差,相同地,如果該神經元對神經網路的重要性不高,則不會對神經網路的表現造成太大的影響,這項方法神經學中較為常見,但是不容易實踐於人類大腦的研究,而這個方法用於研究人工的神經網路則是可行的。

DeepMind透過概念圖(如下圖)展示刪除神經元來評估神經元重要性的方法,顏色越深的神經元代表該神經元越活躍,經由刪除的方法,可以了解有些神經元的確對整個神經網路較為重要。特別的是,DeepMind發現對特定圖像有明確反應的神經元反而較不重要,而那些不容易解釋的神經元隱藏了更多有用的資訊,研究人員若要了解深度神經網路,應該要研究這些不易解釋的神經元。

第二個令人驚訝的結果則是能夠正確分類未曾出現在訓練集圖片的神經元,比只能分類訓練過圖片的神經元,在刪除神經元實驗中更能夠適應,也就是說,這些能夠正確分類未曾出現在訓練集圖片的神經元對單向的依賴性較小。DeepMind試圖打造出聰明的神經網路模型,而聰明的模型則是要在未經訓練的情況下,也可以正確地辨識,若是一個分類模型只能辨識出已經訓練過的狗圖片,卻無法辨識出不同圖片但同種類的狗,這樣的模型就無法發揮效益。

不過,要分辨出一個模型,是否學會像人類一樣透過辨特徵來分類,還是只是記下每一個圖片來分類圖像,並不是這麽簡單。

透過刪除越來越多的部分神經元,可以發現透過特徵來辨識圖像的神經元相較於記憶型的神經元還要堅固,也就是說,有學習能力的神經元在經歷刪除法的過程中,分類表現比較不容易受到影響,這樣的實驗方式可以判斷神經網路是否透過「作弊」的方式在分類圖像,理解神經網路中兩種類型的神經元,可以讓研究人員建立出更不依賴記憶的神經網路。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06