臉書

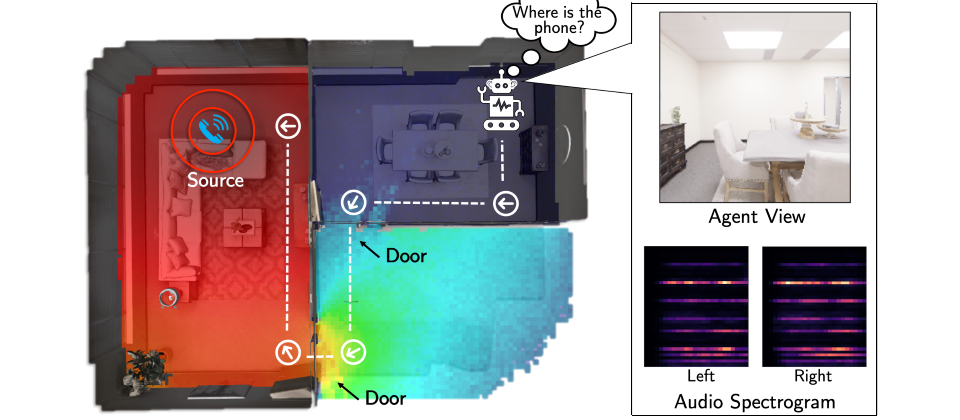

臉書在去年開源了體現AI(embodied AI)模擬平臺AI Habitat,該平臺的目的是為了建立一個可在實體環境中像人類般運作的機器人,不過,以往這個機器人是聾的,只有視覺,卻無聽覺,近日臉書以AI Habitat為核心並打造了SoundSpaces,號稱是全球首個同時具備視覺與聽覺的體現AI平臺,大幅提升機器人辨識與理解環境的能力。

SoundSpaces可用來訓練同時具備視覺與聽覺的機器人,臉書另也打造了一個端對端的學習框架Semantic MapNet,這是一個機器人的記憶模組,改善機器人記憶與理解環境的能力,還有一個新的預測模型,能夠用來預測機器人看不到的空間。

基於AI Habitat的SoundSpaces提供一個新的聲音感應器,可從資料集中插入任何從真實環境中蒐集而來的聲音,再利用AudioGoal任務來挖掘在實體環境中發出聲音的物件,此外,SoundSpaces還能利用回音來判斷空間中的幾何元素。

於是,結合SoundSpaces的機器人就能判斷正在響的手機位置,且有別於傳統的機器人導航系統必須應對特定的點,採用SoundSpaces的機器人並不需要到達特定位置的指標,只要採用多模式感應就能更快到達目的地,該平臺已透過GitHub開源。

臉書團隊也替機器人更新了記憶的方式,Semantic MapNet模組不只能記錄空間及語義地圖,也能建立一個以第三人視角所觀察的3D地圖,這讓機器人得以完成許多任務,像是找到某張桌子、回答有關空間的問題。

新的Occupancy Anticipation預測模型,讓機器人可在不必造訪每個角落的狀況下,迅速繪製出陌生環境的地圖。臉書表示,與最強大的對手相較,在同樣的精確度上,臉書機器人只花了1/3的移動數量,而在同樣的移動數量上,臉書機器人的地圖精確度比對手好上30%。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-10

2026-02-11

2026-02-10

2026-02-09

2026-02-10