Google發布最新的人工智慧偏見改善工作,在Open Images資料集,添加更具包容性註解的人物資料集(More Inclusive Annotations for People,MIAP),這個系列包含更完整的定界框註解,每個註解具有公平性屬性。這項工作是Google負責任人工智慧研究的一部分,Google希望能夠透過這項工作,鼓勵已經採用Open Images資料集的研究人員,把公平性也納入研究中。

Open Images資料集在2016年的時候發布,內含900萬張圖像以及600個類別的定界框註解,過去該資料集經過多次更新,以提高註解的多樣性。雖然Open Images資料集的標籤範圍很廣,但是缺乏敏感屬性,以至於用該資料集訓練的機器學習模型存在公平性疑慮,尤其是在電腦視覺領域的應用。

原始Open Images資料集中的每個圖像,都存在註解以描述定界框中的物體,而為了避免同一個物體存在太多定界框,於是當時Google使用了標籤候選集,利用階層去除重複資料的方法,移除了不具體的類型,像是圖片內容有貓和洗衣機,則定界框會被註解為貓和洗衣機,但是原本描述貓的動物標籤便被移除。

但是這種階層刪除重複資料的方法,從原始註解中加入根本限制,強化了女性/女孩和男性/男孩之間的區別,Google舉例,當註解者被要求對一張班級照片,加上上女孩的註解,註解者會跳過所有男孩,並且可能會在女性人物上加上女孩註解,決定加上註解與否,取決於註解者的文化背景,以及對於年齡的評估,導致每張圖像的標籤可能不一致。

而Google新的MIAP資料集,則是要解決Open Images資料集中,人、男人、女人、男孩和女孩共5個人物階層類別的問題,避免註解者自身對於性別和年齡的偏見,影響資料集的公平性。新的資料集不再要求註解者添加性別和年齡相關的屬性註解,而是僅加入無關性別和年齡類別定界框。

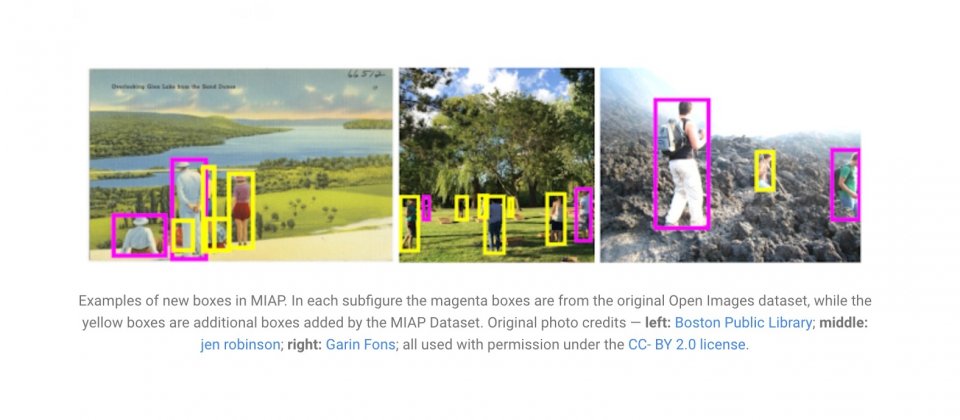

Google提到,性別並非二元,每個人對自己的性別認同,與他人的預期可能不符,因此這個註解方法的改變,也可以降低無意識偏見對註解的影響。MIAP增加了大量過去沒有採用的定界框屬性,在包含人物的10萬張圖片中,人物定界框的數量,從36萬上升到45萬,這些定界框對人物偵測模型,提供了更多基本事實資訊,並且使得電腦視覺可以更具公平性。

熱門新聞

2026-02-06

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09