DeepMind設計一套演算法ReST,不透過人類回饋就能讓LLM產出與人類偏好一致。

DeepMind

重點新聞(0818~0824)

強化學習 DeepMind ReST

DeepMind發表新演算法ReST,不需人為介入強化學習了

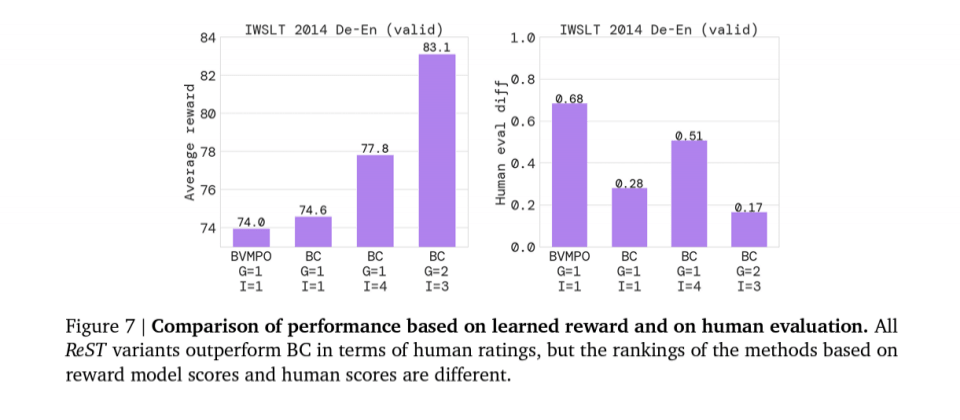

DeepMind最近發表強化自我訓練演算法ReST,可望改變大型語言模型(LLM)訓練方法。進一步來說,人類回饋強化學習(RLHF)是大型語言模型常用的強化學習方法,透過人類提出的回饋來優化模型,讓大型語言模型的產出與人類偏好一致、給出高品質回覆。但DeepMind開發一種簡單的演算法,不需人類回饋,就能讓模型的產出與人類偏好一致。

只要給定初始LLM策略,ReST就會根據策略產生樣本,這些樣本累積成一個資料集,再加上離線強化學習演算法,就能一起用來改善LLM策略。經測試,團隊發現ReST比典型的線上RLHF還要有效,因為訓練資料集是離線產生,有助於資料重複使用。雖然ReST適用於所有生成式學習模型,但團隊用它來改善機器翻譯,並發現,ReST大幅改善翻譯品質,在自動基準測試和人工評測,結果都是如此。這證明了,ReST克服線上RLHF的局限性,能降低在訓練過程中持續產生新樣本的運算成本。(詳全文)

Hugging Face 多模態 Flamingo

Hugging Face發布圖文通吃的多模態模型,媲美DeepMind的Flamingo

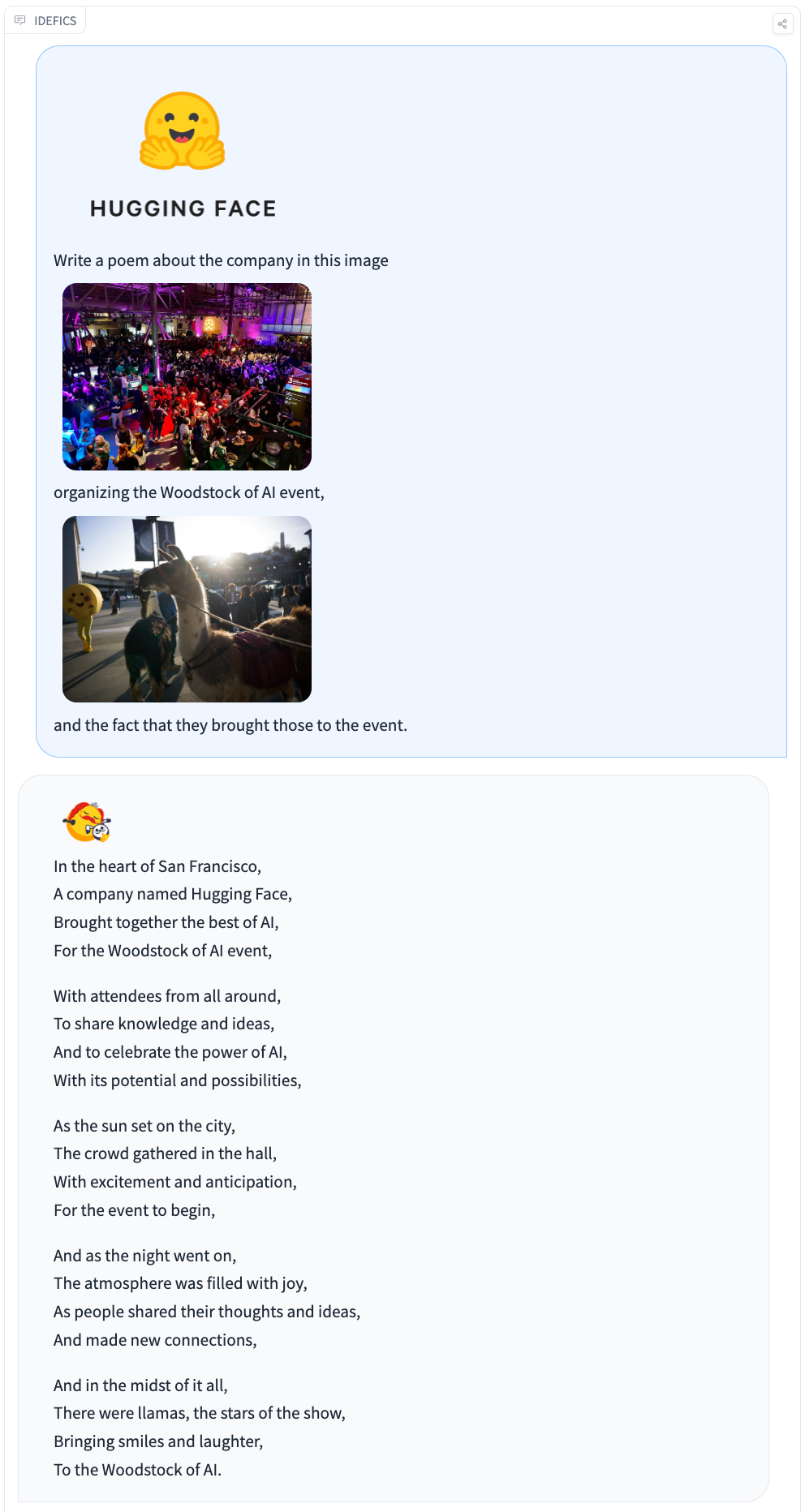

最近,專攻自然語言處理的Hugging Face團隊發表800億參數多模態模型IDEFICS,可處理文字和圖像輸入,並能產出文字結果,比如回答關於圖片的問題、產生圖說、根據多張圖片說故事等。進一步來說,IDEFICS完全以開放資料和模型打造而成,採用的模型包括LLaMA v1和OpenCLIP,訓練資料則來自維基百科、公開多模態資料集、LAION,以及他們開源的OBELICS資料集,含1,115億Token,由網路抓取的1.41億個圖文檔案組成。

Hugging Face開放存取IDEFICS,包含基礎版和指令調校版,各版本皆有90億參數和800億參數兩種大小的模型,同時提供經微調、適合對話應用的版本idefics-80B-instruct和idefics-9B-instruct。團隊表示,IDEFICS是仿DeepMind的語言-視覺模型Flamingo而成,Flamingo表現優越(SOTA),但未開源。經測試,IDEFICS在各項圖文基準測試的表現,都與Flamingo相媲美。Hugging Face表示,由於IDEFICS使用Meta的LLaMA v1,使用者若要使用IDEFICS,得向Meta申請許可。(詳全文)

Meta 翻譯 語音

文字、語音都能懂!Meta開源多語言翻譯模型

Meta最近宣布釋出多語言、多模態翻譯模型SeamlessM4T,支援將近100種語言的文字和語音翻譯。SeamlessM4T是Meta打造單一翻譯工具計畫的最新成果。2020年,Meta就發表支援100種語言的翻譯模型M2M-100,去年又釋出文字轉文字翻譯模型NLLB 200,支援200種語言,今年上半年則發布大量多語語音(MMS)模型,可提供1,100多種語言的語音辨識和語音合成。

SeamlessM4T整合了這些計畫的技術,用多種語音資料訓練,將多語言、多模翻譯能力整合至單一模型中。就技術而言,Meta小組重新設計序列建模工具fairseq,增加建模和資料載入API,並用支援語音辨識、聽寫、語音合成、文字對文字的多任務UnitY架構為基礎模型,再以自監督語音編碼器w2v-BERT 2.0進行語音資料預處理,並採用NLLB模型的文字編碼器。在語音合成方面,則用UnitY模型的語音生成元件T2U和HiFi-GAN unit vocoder,來產出翻譯後的語音。為訓練SeamlessM4T,專案小組使用了44.3萬小時的語音/文字對,還有2.9萬小時的語音/語音對,支援36種語言,統稱為SeamlessAlign。Meta宣稱,從數量和涵括的語言來看,這組資料集都是當今之冠。(詳全文)

Excel Python 微軟

Excel Python 微軟

微軟在Excel加入Python支援

日前,微軟宣布在Excel加入Python支援,讓同一個Excel工作簿能同時執行Python程式和Excel公式,如機器學習、資料清洗或預測式分析,目前為公開預覽版。

進一步來說,Excel加入Python支援,可讓用戶在Excel資料格內,輸入Python腳本程式語言,並在雲端執行運算,再將包含圖表或視覺化物件的結果回傳到工作表。Python in Excel可和Excel現有工具如公式、PivotTables、Excel圖表相容,且配合Excel內建的連接器和Power Query,使用者還可將資料抓進Python in Excel。微軟表示,Python開發者可用Excel完成資料視覺化、資料清洗,或執行預測式分析、機器學習等任務。(詳全文)

微調 GPT-3.5 OpenAI

GPT-3.5 Turbo開放微調了

OpenAI開放自家大型語言模型GPT-3.5 Turbo的微調功能,使用者可自定義模型,來滿足特殊用例需求。語言模型微調是指,用特定資料集來訓練一套預訓練模型,來強化模型對特定任務或應用的表現。OpenAI測試發現,GPT-3.5 Turbo微調,在特定任務上的表現甚至超過GPT-4的基礎能力。

微調不只讓模型適應特殊任務,還能讓使用者用較短的提示語,得到不錯的效能。OpenAI指出,早期測試者可將提示長度縮短90%,API的呼叫也會更快速,更節省成本。現在微調後的GPT-3.5-Turbo模型,可處理的Token數多達4,000,是之前微調模型的2倍。至於微調價格,主要分為初始訓練成本和使用成本,使用10萬Token的檔案微調gpt-3.5-turbo,經3次完整訓練,成本約為2.4美元。今年稍晚,OpenAI還會推出新功能,允許使用者針對函式呼叫與gpt-3.5-turbo-16k模型微調。(詳全文)

VMware 生成式AI 離線部署

VMware推出多項生成式AI服務,也有離線部署方案

在今年VMware Explore大會中,VMware發表跨雲新服務Private AI,可支援多雲的企業生成式AI模型訓練、測試和部署,另也與Nvidia聯手,推出可於離線環境中使用的方案,來協助企業開發和客製化自己的LLM模型,降低內部資料外洩風險。

進一步來說,Private AI是VMware的第6大跨雲服務,可確保企業數據隱私和權限控管,並整合資安和管理機制,可協助企業在複雜多雲環境中,執行、微調或進行LLM模型推論,並應用於各場景,如程式碼生成或使用生成式AI Chatbot。同時,VMware也與Nvidia推出可地端部署的一站式生成式AI平臺,企業只需在自家資料中心內部署這套平臺,就能進行生成式AI基礎模型的訓練和推論,屬於離線部署方案。最後,VMware也將生成式AI融入多雲產品,像是在VMware Tanzu、Workspace ONE、NSX+等服務中,加入用Private AI開發的生成式AI智慧助手功能。(詳全文)

Hugging Face 程式開發 SafeCoder

資料不外洩!Hugging Face推出企業級自託管程式開發助手

企業可用的程式開發助手又多一例,Hugging Face最近推出SafeCoder,強調更安全、自託管,就像是企業地端的GitHub Copilot一樣。Hugging Face說明,SafeCoder並不是一個模型,而是完整的端到端商業解決方案,並以安全和隱私為核心原則打造,也就是說,程式碼在訓練或推論過程中,都不會離開企業的虛擬私有雲(VPC)。

企業可透過SafeCoder,在自家基礎設施上建立自己的程式碼大型語言模型,不需與Hugging Face或其他第三方共享程式碼,免除用自家資料微調閉源模型的資料外洩風險。(詳全文)

YouTube 生成式AI 孵化器

YouTube成立音樂AI孵化器,鼓勵創作者用AI做音樂

日前,YouTube成立音樂AI孵化器(Music AI Incubator),要深究AI在音樂創作的潛力,並鼓勵作詞、作曲等領域的創作者參與,使用AI工具來創作。為順利推動這項計畫,YouTube也聯手環球音樂集團(UMG),透過旗下藝人來測試生成式AI於音樂創作的應用,並給出洞察。此外,YouTube也會在這項計畫下,利用生成式AI來保護作品,比如找出濫用AI生成的錯誤內容、商標等,來保障創作者社群。(詳全文)

圖片來源/Hugging Face、Meta、微軟

AI近期新聞

1. 麥肯錫用生成式AI打造企業資料搜尋工具Lilli

2. 吳恩達推出語義搜尋LLM免費課程

資料來源:iThome整理,2023年8月

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10