| CloudFlare | VibeSDK | Vibe Coding | AI開發 | LLM

Cloudflare釋出VibeSDK,讓用戶一鍵部署Vibe Coding平臺

Cloudflare以開源形式釋出VibeSDK,供組織快速自架Vibe Coding平臺,讓終端用戶以自然語言生成並部署應用,結合Agents SDK與大型語言模型,支援即時預覽、沙箱開發與多模型路由

2025-09-25

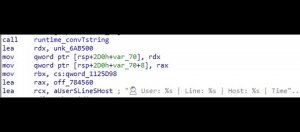

| 惡意程式 | MalTerminal | LLM

資安業者揭露疑似全球最早的LLM驅動惡意程式MalTerminal

美國資安業者SentinelOne揭露一個整合了大型語言模型(LLM)的惡意程式MalTerminal

2025-09-23

| Docker API | Emoji | LLM | Tor | Chrome DevTools | Telnet

針對曝露的Docker API,駭客透過Tor網路發動新一波行動,疑綁架用於殭屍網路

駭客似乎打算再度透過洋蔥網路(Tor Network),對組態配置不當的Docker API發動攻擊,並企圖封鎖相關連接埠,以防他人存取受害主機資源,而他們的目的,很可能是用於建置殭屍網路的基礎設施

2025-09-15

| Grammarly | AI代理 | 文法檢測 | LLM

Grammarly推出AI寫作介面與8款代理支援研究與專業寫作

Grammarly發表8款人工智慧代理與人工智慧寫作介面docs,功能涵蓋查證、抄襲檢測與受眾預測,回應大語言模型衝擊下的文法檢測市場,並延續收購Coda後的產品整合

2025-08-19

| 美國艾倫人工智慧研究所 | AI2 | OMAI | LLM

艾倫人工智慧研究所獲Nvidia與NSF共1.52億美元資助,打造開源AI科研平臺

在Nvidia與美國國家科學基金會資助下,美國艾倫人工智慧研究所(Ai2)啟動OMAI計畫,以建構完全開源的多模態大型AI生態系統

2025-08-15

| Google Ads | LLM | 資料標註 | 廣告安全 | Cohen’s Kappa

Google Ads推出新資料篩選與專家標註流程,針對大型語言模型在廣告安全任務上,能將微調資料量縮至原本萬分之一,同時維持或提升與專家的一致性

2025-08-11

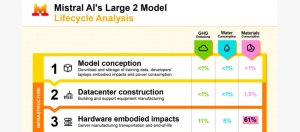

| Mistral AI | 大型語言模型 | LLM | 模型生命周期 | 碳排放 | 水資源消耗 | 永續

Mistral AI發布全球首份AI模型的生命周期環境影響報告,揭露碳、水、資源消耗影響

隨著生成式AI快速擴張,Mistral強調業界亟需建立統一的環境評估框架,讓使用者、企業與政府能更清楚掌握AI模型從開發、部署到使用階段產生的碳排放,以及消耗的水資源與金屬資源

2025-07-23